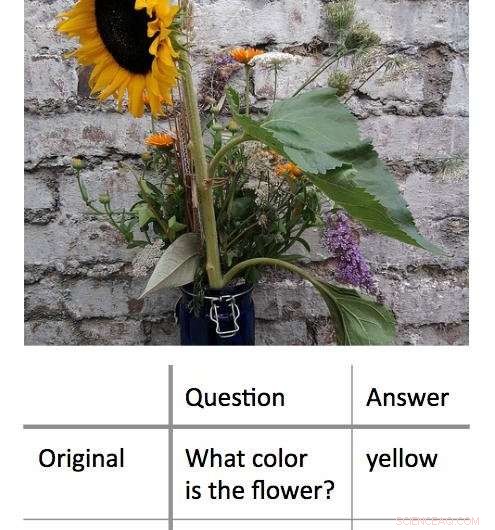

Une nouvelle méthode pour décoder les processus de prise de décision utilisés par les algorithmes d'apprentissage automatique « boîte noire » fonctionne en trouvant l'entrée minimale qui donnera toujours une réponse correcte. Dans cet exemple, les chercheurs ont d'abord présenté un algorithme avec une photo d'un tournesol et ont demandé « De quelle couleur est la fleur ? Cela a abouti à la bonne réponse, 'jaune.' Les chercheurs ont découvert qu'ils pouvaient obtenir la même réponse correcte, avec un degré de confiance tout aussi élevé, en posant à l'algorithme une question à un seul mot :« Fleur ? » Crédit :Shi Feng/Université du Maryland

Intelligence artificielle, en particulier, l'apprentissage automatique fait partie de la vie quotidienne des utilisateurs d'ordinateurs et de smartphones. De la correction automatique des fautes de frappe à la recommandation de nouvelles musiques, les algorithmes d'apprentissage automatique peuvent aider à rendre la vie plus facile. Ils peuvent aussi faire des erreurs.

Il peut être difficile pour les informaticiens de comprendre ce qui n'a pas fonctionné dans de tels cas. En effet, de nombreux algorithmes d'apprentissage automatique apprennent à partir d'informations et font leurs prédictions à l'intérieur d'une "boîte noire" virtuelle, " laissant peu d'indices à suivre pour les chercheurs.

Un groupe d'informaticiens de l'Université du Maryland a développé une nouvelle approche prometteuse pour interpréter les algorithmes d'apprentissage automatique. Contrairement aux efforts précédents, qui cherchait généralement à "casser" les algorithmes en supprimant les mots clés des entrées pour donner la mauvaise réponse, le groupe UMD a plutôt réduit les entrées au strict minimum requis pour donner la bonne réponse. En moyenne, les chercheurs ont obtenu la bonne réponse avec une entrée de moins de trois mots.

Dans certains cas, les algorithmes modèles des chercheurs ont fourni la bonne réponse basée sur un seul mot. Souvent, le mot ou la phrase d'entrée semblait avoir peu de lien évident avec la réponse, révélant des informations importantes sur la façon dont certains algorithmes réagissent à un langage spécifique. Étant donné que de nombreux algorithmes sont programmés pour donner une réponse quoi qu'il arrive, même lorsqu'ils sont incités par une entrée absurde, les résultats pourraient aider les informaticiens à créer des algorithmes plus efficaces capables de reconnaître leurs propres limites.

Les chercheurs présenteront leurs travaux le 4 novembre 2018 à la Conférence 2018 sur les méthodes empiriques en traitement automatique du langage naturel.

« Les modèles à boîte noire semblent fonctionner mieux que les modèles plus simples, tels que les arbres de décision, mais même les personnes qui ont écrit le code initial ne peuvent pas dire exactement ce qui se passe, " a déclaré Jordan Boyd-Graber, l'auteur principal de l'étude et professeur agrégé d'informatique à l'UMD. "Lorsque ces modèles renvoient des réponses incorrectes ou absurdes, il est difficile de comprendre pourquoi. Donc au lieu, nous avons essayé de trouver l'entrée minimale qui donnerait le bon résultat. L'entrée moyenne était d'environ trois mots, mais nous pourrions le réduire à un seul mot dans certains cas."

Crédit :CC0 Domaine public

Dans un exemple, les chercheurs ont saisi une photo d'un tournesol et la question textuelle, « De quelle couleur est la fleur ? comme entrées dans un algorithme de modèle. Ces entrées ont donné la bonne réponse de "jaune". Après avoir reformulé la question en plusieurs combinaisons différentes de mots plus courts, les chercheurs ont découvert qu'ils pouvaient obtenir la même réponse avec « fleur ? » comme seule entrée de texte pour l'algorithme.

En autre, exemple plus complexe, les chercheurs ont utilisé l'invite, « En 1899, John Jacob Astor IV a investi 100 $, 000 pour que Tesla continue de développer et de produire un nouveau système d'éclairage. Au lieu, Tesla a utilisé l'argent pour financer ses expériences à Colorado Springs."

Ils ont ensuite demandé à l'algorithme, « Pourquoi Tesla a-t-il dépensé l'argent d'Astor ? » et reçu la bonne réponse, "Expériences au Colorado Springs." La réduction de cette entrée au seul mot « fait » a donné la même réponse correcte.

Le travail révèle des informations importantes sur les règles que les algorithmes d'apprentissage automatique appliquent à la résolution de problèmes. De nombreux problèmes réels liés aux algorithmes surviennent lorsqu'une entrée qui a du sens pour les humains entraîne une réponse absurde. En montrant que l'inverse est également possible - que des entrées absurdes peuvent également donner des résultats corrects, réponses sensées—Boyd-Graber et ses collègues démontrent le besoin d'algorithmes capables de reconnaître lorsqu'ils répondent à une question absurde avec un degré élevé de confiance.

"En fin de compte, tous ces trucs d'apprentissage automatique sophistiqués peuvent en fait être assez stupides, " dit Boyd-Graber, qui a également des postes à pourvoir à l'Institut d'études informatiques avancées de l'Université du Maryland (UMIACS) ainsi qu'au College of Information Studies and Language Science Center de l'UMD. « Quand les informaticiens entraînent ces modèles, nous ne leur montrons généralement que de vraies questions ou de vraies phrases. Nous ne leur montrons pas de phrases absurdes ou de mots simples. Les modèles ne savent pas qu'ils doivent être confondus par ces exemples."

La plupart des algorithmes se forceront à fournir une réponse, même avec des données insuffisantes ou contradictoires, selon Boyd-Graber. Cela pourrait être au cœur de certaines des sorties incorrectes ou absurdes générées par les algorithmes d'apprentissage automatique - dans les algorithmes modèles utilisés pour la recherche, ainsi que des algorithmes du monde réel qui nous aident en signalant les courriers indésirables ou en proposant des itinéraires alternatifs. Mieux comprendre ces erreurs pourrait aider les informaticiens à trouver des solutions et à créer des algorithmes plus fiables.

"Nous montrons que les modèles peuvent être entraînés à savoir qu'ils doivent être confondus, " Boyd-Graber a dit. " Alors ils peuvent juste sortir et dire, « Vous m'avez montré quelque chose que je ne peux pas comprendre. »