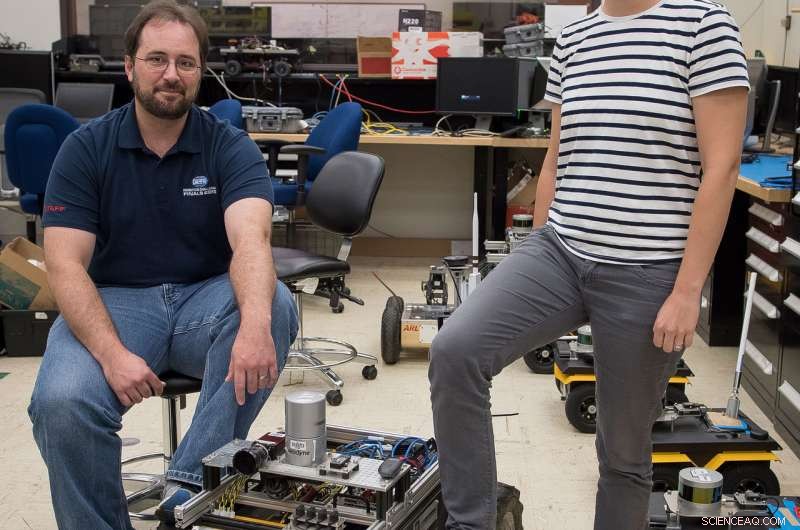

Un petit robot Clearpath Husky sans pilote, qui a été utilisé par les chercheurs de l'ARL pour développer une nouvelle technique permettant d'enseigner rapidement aux robots de nouveaux comportements de traversée avec un minimum de surveillance humaine. Crédit :armée américaine

Des chercheurs du Laboratoire de recherche de l'armée américaine et du Robotics Institute de l'Université Carnegie Mellon ont développé une nouvelle technique pour enseigner rapidement aux robots de nouveaux comportements de traversée avec un minimum de surveillance humaine.

La technique permet aux plates-formes de robots mobiles de naviguer de manière autonome dans des environnements tout en effectuant des actions qu'un humain attendrait du robot dans une situation donnée.

Les expériences de l'étude ont été récemment publiées et présentées à la conférence internationale de l'Institute of Electrical and Electronics Engineers sur la robotique et l'automatisation qui s'est tenue à Brisbane, Australie.

Les chercheurs de l'ARL Drs. Maggie Wigness et John Rogers ont participé à des discussions en face à face avec des centaines de participants à la conférence au cours de leur présentation interactive de deux heures et demie.

Selon Wigness, l'un des objectifs de l'équipe de recherche dans la recherche sur les systèmes autonomes est de fournir des coéquipiers de robots autonomes fiables au soldat.

"Si un robot agit comme un coéquipier, les tâches peuvent être accomplies plus rapidement et une meilleure connaissance de la situation peut être obtenue, " dit Wigness. " Plus loin, les coéquipiers du robot peuvent être utilisés comme enquêteur initial pour des scénarios potentiellement dangereux, gardant ainsi les soldats plus loin du mal."

Pour y parvenir, Wigness a déclaré que le robot doit être capable d'utiliser son intelligence acquise pour percevoir, raisonner et prendre des décisions.

"Cette recherche se concentre sur la façon dont l'intelligence robotique peut être apprise à partir de quelques démonstrations d'exemples humains, " ? ce qui en fait une technique d'apprentissage idéale pour un apprentissage à la volée sur le terrain lorsque les exigences de la mission changent."

Les chercheurs de l'ARL et de la CMU ont concentré leur enquête initiale sur l'apprentissage des comportements de traversée du robot en ce qui concerne la perception visuelle du robot du terrain et des objets dans l'environnement.

Plus précisement, le robot a appris à naviguer à partir de divers points de l'environnement tout en restant près du bord d'une route, et aussi comment traverser secrètement en utilisant des bâtiments comme couverture.

Selon les chercheurs, donné différentes tâches de mission, le comportement de déplacement appris le plus approprié peut être activé pendant le fonctionnement du robot.

Ceci est fait en tirant parti du contrôle optimal inverse, aussi communément appelé apprentissage par renforcement inverse, qui est une classe d'apprentissage automatique qui cherche à récupérer une fonction de récompense étant donné une politique optimale connue.

Les chercheurs de l'ARL Drs. Maggie Wigness et John Rogers posent avec un petit robot Clearpath Husky sans pilote dans leur laboratoire du centre de laboratoire Adelphi dans le Maryland. Crédit :armée américaine

Dans ce cas, un humain démontre la politique optimale en conduisant un robot le long d'une trajectoire qui représente le mieux le comportement à apprendre.

Ces exemplaires de trajectoire sont ensuite liés aux caractéristiques visuelles terrain/objet, comme l'herbe, routes et bâtiments, apprendre une fonction de récompense par rapport à ces caractéristiques de l'environnement.

Bien que des recherches similaires existent dans le domaine de la robotique, ce que fait ARL est particulièrement unique.

« Les défis et les scénarios d'exploitation sur lesquels nous nous concentrons ici à l'ARL sont extrêmement uniques par rapport aux autres recherches en cours, " a déclaré Wigness. " Nous cherchons à créer des systèmes robotiques intelligents qui fonctionnent de manière fiable dans des environnements de combattants, ce qui signifie que la scène est très déstructurée, éventuellement bruyant, et nous devons le faire avec une connaissance a priori relativement limitée de l'état actuel de l'environnement. Le fait que notre énoncé de problème soit si différent de tant d'autres chercheurs permet à ARL d'avoir un impact énorme dans la recherche sur les systèmes autonomes. Nos techniques, par la définition même du problème, doit être résistant au bruit et avoir la capacité d'apprendre avec des quantités de données relativement faibles. »

Selon Wigness, cette recherche préliminaire a aidé les chercheurs à démontrer la faisabilité de l'apprentissage rapide d'un codage des comportements de traversée.

« Alors que nous poussons cette recherche au niveau supérieur, nous allons commencer à nous concentrer sur des comportements plus complexes, ce qui peut nécessiter un apprentissage à partir de plus que des caractéristiques de perception visuelle, " a déclaré Wigness. " Notre cadre d'apprentissage est suffisamment flexible pour utiliser des informations a priori qui peuvent être disponibles sur un environnement. Cela pourrait inclure des informations sur des zones qui sont probablement visibles par des adversaires ou des zones connues pour avoir une communication fiable. Ces informations supplémentaires peuvent être pertinentes pour certains scénarios de mission, et l'apprentissage de ces caractéristiques améliorerait l'intelligence du robot mobile."

Les chercheurs explorent également comment ce type d'apprentissage du comportement se transfère entre différentes plates-formes mobiles.

Leur évaluation à ce jour a été réalisée avec un petit robot Clearpath Husky sans pilote, qui a un champ de vision visuel relativement bas par rapport au sol.

« Le transfert de cette technologie vers des plates-formes plus grandes introduira de nouveaux points de vue de perception et différentes capacités de manœuvre de plate-forme, " Wigness said. "Learning to encode behaviors that can be easily transferred between different platforms would be extremely valuable given a team of heterogeneous robots. Dans ce cas, the behavior can be learned on one platform instead of each platform individually."

This research is funded through the Army's Robotics Collaborative Technology Alliance, or RCTA, which brings together government, industrial and academic institutions to address research and development required to enable the deployment of future military unmanned ground vehicle systems ranging in size from man-portables to ground combat vehicles.

"ARL is positioned to actively collaborate with other members of the RCTA, leveraging the efforts of top researchers in academia to work on Army problems, " Rogers said. "This particular research effort was the synthesis of several components of the RCTA with our internal research; it would not have been possible if we didn't work together so closely."

Finalement, this research is crucial for the future battlefield, where Soldiers will be able to rely on robots with more confidence to assist them in executing missions.

"The capability for the Next Generation Combat Vehicle to autonomously maneuver at optempo in the battlefield of the future will enable powerful new tactics while removing risk to the Soldier, " Rogers said. "If the NGCV encounters unforeseen conditions which require teleoperation, our approach could be used to learn to autonomously handle these types of conditions in the future."