Dans un nouvel article publié dans Science et co-écrits par Duncan J. Watts de l'Université de Pennsylvanie, les chercheurs introduisent une nouvelle méthodologie pour mesurer l'impact causal du contenu des médias sociaux à grande échelle. Ils montrent que le contenu trompeur provenant des principales sources d'information – plutôt que la désinformation pure et simple ou les « fausses nouvelles » – était le principal moteur de l'hésitation à la vaccination sur Facebook.

"La désinformation a été corrélée à de nombreux défis sociétaux, mais il n'existe pas beaucoup de recherches montrant que l'exposition à la désinformation cause réellement du tort", a expliqué Allen.

Pendant la pandémie de COVID-19, par exemple, la diffusion de fausses informations sur le virus et le vaccin a retenu l’attention du public. Cependant, les recherches existantes n'ont, pour la plupart, établi que des corrélations entre le refus du vaccin et des facteurs tels que le partage de fausses informations en ligne, et ont largement négligé le rôle du contenu « sceptique quant aux vaccins », qui était potentiellement trompeur mais n'était pas signalé comme de la désinformation par les faits de Facebook. -dames.

Pour combler cette lacune, les chercheurs ont d'abord posé une question clé :que faudrait-il pour que la désinformation ou tout autre type de contenu ait des impacts à grande échelle ?

"Pour changer les comportements à grande échelle, le contenu doit non seulement être suffisamment convaincant pour convaincre les gens de ne pas se faire vacciner, mais également être largement diffusé", a déclaré Allen. "Le préjudice potentiel résulte de la combinaison de la persuasion et de l'exposition."

Pour quantifier la capacité de persuasion du contenu, les chercheurs ont mené des expériences randomisées dans lesquelles ils ont montré à des milliers de participants à l'enquête les titres de 130 articles liés aux vaccins (y compris du contenu grand public et des informations erronées connues) et ont testé l'impact de ces titres sur leurs intentions de se faire vacciner contre le COVID. 19.

Les chercheurs ont également demandé à un groupe distinct de personnes interrogées d’évaluer les titres selon divers attributs, notamment la plausibilité et l’orientation politique. Un facteur prédit de manière fiable les impacts sur les intentions de vaccination :la mesure dans laquelle un titre suggère que le vaccin est nocif pour la santé d'une personne.

En utilisant la « sagesse des foules » et les outils d’IA de traitement du langage naturel, Allen et ses co-auteurs ont extrapolé les résultats de cette enquête pour prédire le pouvoir de persuasion des 13 206 URL liées au vaccin qui ont été largement consultées sur Facebook au cours des trois premiers mois de vaccination. déploiement.

En combinant ces prédictions avec les données de Facebook montrant le nombre d'utilisateurs ayant consulté chaque URL, les chercheurs ont pu prédire l'impact global de chaque titre, c'est-à-dire le nombre de personnes qu'il aurait pu persuader de ne pas se faire vacciner. Les résultats ont été surprenants.

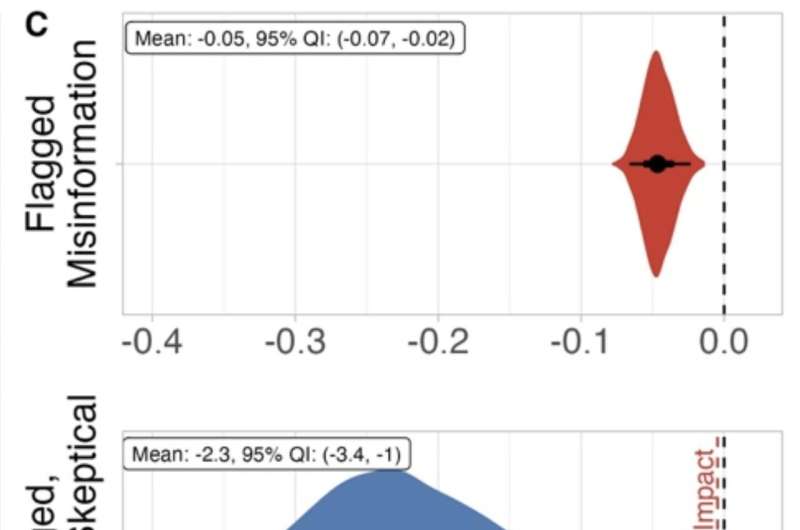

Contrairement aux idées reçues, les chercheurs ont estimé que les contenus sceptiques à l'égard des vaccins réduisaient les intentions de vaccination 46 fois plus que la désinformation signalée par les vérificateurs des faits.

La raison? Même si la désinformation signalée était plus préjudiciable une fois observée, sa portée était relativement faible. Au total, les titres liés aux vaccins dans l'ensemble de données Facebook ont reçu 2,7 milliards de vues, mais les contenus signalés comme étant de la désinformation n'ont reçu que 0,3 % de ces vues, et le contenu provenant de domaines jugés peu crédibles en a reçu 5,1 %.

"Même si le contenu carrément faux réduit le plus les intentions de vaccination lorsqu'il est vu, relativement peu de personnes l'ont vu", a expliqué Rand. "Essentiellement, cela signifie qu'il existe cette classe de contenu de zone grise qui est moins nocif par exposition, mais qui est vu beaucoup plus souvent - et donc globalement plus impactant - et qui a été largement négligé par les universitaires et les sociétés de médias sociaux. "

Notamment, plusieurs des URL les plus marquantes de l'ensemble de données étaient des articles provenant de sources grand public qui mettaient en doute la sécurité du vaccin. Par exemple, l’article le plus consulté était un article – provenant d’une source d’information grand public très appréciée – suggérant qu’un médecin était décédé deux semaines après avoir reçu le vaccin contre la COVID-19. Ce titre unique a reçu 54,9 millions de vues, soit plus de six fois le nombre total de vues de toutes les informations erronées signalées.

Même si le corps de cet article reconnaissait l'incertitude quant à la cause du décès du médecin, son titre « appât à clics » était très suggestif et impliquait que le vaccin en était probablement responsable. C'est important puisque la grande majorité des téléspectateurs sur les réseaux sociaux ne cliquent probablement jamais pour lire au-delà du titre.

Selon Rand, l'une des implications de ce travail est que les médias doivent faire plus attention à leurs titres, même si cela signifie qu'ils n'attirent pas autant l'attention.

"Lorsque vous écrivez un titre, vous ne devriez pas simplement vous demander s'il est faux ou non", a-t-il déclaré. "Vous devriez vous demander si le titre est susceptible de provoquer des perceptions inexactes."

Pour les plateformes, a ajouté Allen, la recherche souligne également la nécessité d'une modération plus nuancée, sur tous les sujets, et pas seulement sur la santé publique.

"La modération du contenu se concentre sur l'identification des informations les plus fausses, mais cela n'est peut-être pas un moyen efficace d'identifier le contenu globalement le plus préjudiciable", dit-elle. « Les plateformes devraient également donner la priorité à l'examen du contenu des personnes ou des organisations comptant le plus grand nombre d'abonnés, tout en équilibrant la liberté d'expression. Nous devons investir dans davantage de recherches et de solutions créatives dans cet espace, par exemple dans des outils de modération participatifs comme les notes communautaires de X. »

"Les décisions de modération de contenu peuvent être très difficiles en raison de la tension inhérente entre vouloir atténuer les dommages et permettre aux gens de s'exprimer", a déclaré Rand. "Notre document présente un cadre pour aider à équilibrer ce compromis en permettant aux entreprises technologiques de quantifier réellement les dommages potentiels."

Et les compromis pourraient être importants. Une analyse exploratoire des auteurs a révélé que si les utilisateurs de Facebook n'avaient pas été exposés à ce contenu sceptique à l'égard des vaccins, jusqu'à 3 millions d'Américains supplémentaires auraient pu être vaccinés.

"Nous ne pouvons pas simplement ignorer cette zone grise", a conclu Allen. "Des vies auraient pu être sauvées."

Une nouvelle approche pour estimer l'impact

Le pouvoir sous-estimé de l'exposition

Comment les journalistes et les plateformes de réseaux sociaux peuvent vous aider