Crédit :OpenAI

Bien, tant pis pour une hypothèse qui semble maintenant trop facile à accepter - que le magnifique cerveau humain l'a sur une machine n'importe quel jour. Vraiment? Interprétons-nous le monde avec plus de précision qu'un "réseau de neurones convolutifs" ne peut le faire ?

Comme l'a souligné Even Ackerman, "quand un CNN [convolutional neural network] est présenté avec une image, il regarde une grille statique de pixels rectangulaires."

Nous regardons les images et les voyons correctement, tels que les humains et les animaux ; Les CNN considèrent les choses plus comme des ordinateurs.

Une équipe de recherche soulève des questions sur des hypothèses faciles, toutefois. Ils explorent ce qui se passe avec des exemples contradictoires à l'égard des humains.

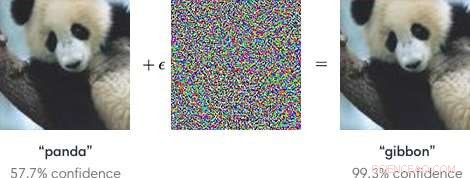

Les entrées dans les modèles d'apprentissage automatique conçues pour provoquer une erreur des modèles sont des "exemples contradictoires". Exemples contradictoires, En tant que tel, pourrait potentiellement être dangereux.

Tout simplement, "Les exemples contradictoires sont des entrées malveillantes conçues pour tromper les modèles d'apprentissage automatique, " selon une page Google Research.

Comme l'a expliqué un article de blog dans OpenAI, les attaquants pourraient cibler les véhicules autonomes en utilisant des autocollants ou de la peinture pour créer un panneau d'arrêt accusatoire que le véhicule interpréterait comme un « cendant » ou un autre signe.

Les chercheurs, en parlant des modèles d'apprentissage automatique comme vulnérables aux exemples contradictoires, a noté que de petits changements dans les images peuvent entraîner des erreurs dans les modèles de vision par ordinateur, comme identifier un autobus scolaire comme une autruche.

Le blog d'OpenAI a fait référence à des exemples contradictoires comme représentant un problème concret de sécurité de l'IA.

Ayant dit cela, qu'en est-il des exemples contradictoires trompant les humains ? Cela peut-il arriver?

L'équipe, a dit Even Ackerman dans Spectre IEEE , « décidé d'essayer de déterminer si les mêmes techniques qui trompent les réseaux de neurones artificiels peuvent également tromper les réseaux de neurones biologiques à l'intérieur de nos têtes. »

Le document de recherche décrivant leur travail est « Exemples contradictoires qui trompent à la fois la vision humaine et informatique, " sur arXiv.

"Ici, nous créons les premiers exemples contradictoires conçus pour tromper les humains, " ont-ils écrit. Ils ont découvert que " les exemples contradictoires qui se transfèrent fortement à travers les modèles de vision par ordinateur influencent les classifications faites par les observateurs humains limités dans le temps. " (Ackerman a noté que dans l'étude, les gens n'avaient qu'entre 60 et 70 millisecondes pour regarder chaque image et prendre une décision.)

Spectre IEEE 's Even Ackerman a discuté de ce qu'ils ont fait et a présenté une série de deux images de Google Brain pour étayer son explication.

Ackerman a montré "une photo d'un chat sur la gauche. Sur la droite, pouvez-vous dire s'il s'agit d'une photo du même chat, ou une photo d'un chien similaire ? La différence entre les deux images est que celle de droite a été légèrement modifiée par un algorithme pour rendre difficile pour un type de modèle informatique appelé réseau de neurones convolutifs (CNN) de pouvoir dire de quoi il s'agit réellement. Dans ce cas, le CNN pense qu'il regarde un chien plutôt qu'un chat, mais ce qui est remarquable, c'est que la plupart des gens pensent la même chose."

Quoi? Comment les humains peuvent-ils faire la même erreur ? Ackerman a déclaré qu'il pourrait être possible de cibler le développement d'une image contradictoire sur les humains "en choisissant des modèles qui correspondent le plus possible au système visuel humain".

Mais qu'est-ce qui perturbe exactement la capacité de l'humain à être correct ? Ackerman a déclaré que les chercheurs ont souligné que « nos exemples contradictoires sont conçus pour tromper la perception humaine, nous devons donc être prudents en utilisant la perception humaine subjective pour comprendre comment ils fonctionnent. »

Il a dit qu'ils étaient prêts à faire quelques généralisations « sur quelques catégories différentes de modifications, y compris 'perturber les bords de l'objet, notamment par des modulations de fréquences moyennes perpendiculaires au bord; améliorer les bords à la fois en augmentant le contraste et en créant des limites de texture ; modifier la texture; et en profitant des zones sombres de l'image, où la magnitude perceptive des petites perturbations peut être plus grande.'"

Comment ils ont testé :Des sujets ayant une vision normale ou corrigée ont participé à l'expérience.

« Pour chaque groupe, une image contradictoire réussie a pu tromper les gens en choisissant le mauvais membre du groupe, en l'identifiant comme un chien alors qu'il s'agit en réalité d'un chat, ou vice versa, " a déclaré Ackerman.

Les sujets ont été invités à classer les images apparaissant à l'écran en appuyant sur les boutons d'une boîte de temps de réponse, disaient les auteurs.

Ackerman a écrit, "Le court laps de temps pendant lequel l'image a été montrée a atténué la différence entre la façon dont les CNN perçoivent le monde et la façon dont les humains le font."

L'expérience impliquait trois groupes d'images :animaux de compagnie (chats et chiens), légumes (chou et brocoli), et "danger" (araignées et serpents).

Le commentaire d'Ackerman sur les résultats de la recherche était qu'« il y a un chevauchement entre la manipulation perceptive des CNN et la manipulation des humains. Cela signifie que les techniques d'apprentissage automatique pourraient potentiellement être utilisées pour modifier subtilement des choses comme des images ou des vidéos d'une manière qui pourrait changer notre perception de (et leur réaction) sans que nous nous rendions compte de ce qui se passait."

Il a ajouté que « nous devrons faire attention, et gardez à l'esprit que, tout comme ces ordinateurs, sometimes we're far too easy to fool."

"Adversarial Examples that Fool both Human and Computer Vision" is by Gamaleldin F. Elsayed, Shreya Shankar, Brian Cheung, Nicolas Papernot, Alex Kurakin, Ian Goodfellow, and Jascha Sohl-Dickstein, on arXiv.

© 2018 Tech Xplore