De gauche à droite :Dr John H.L. Hansen, Chengzhu Yu PhD'17, Le Dr Abhijeet Sangwan et Lakshmish Kaushik posent avec un modèle d'astronaute au centre spatial Johnson de la NASA à Houston. Les quatre ont supervisé le projet de développer des techniques de traitement de la parole pour reconstruire et transformer des milliers d'heures d'audio des missions lunaires de la NASA. Crédit :Université du Texas à Dallas

La NASA a enregistré des milliers d'heures d'audio des missions lunaires Apollo, pourtant, la plupart d'entre nous n'ont pu entendre que les faits saillants.

L'agence a enregistré toutes les communications entre les astronautes, des spécialistes du contrôle de mission et du personnel de soutien en coulisse pendant les missions historiques de la lune, en plus des célèbres citations de Neil Armstrong d'Apollo 11 en juillet 1969.

La plupart de l'audio est resté stocké sur des bandes analogiques obsolètes pendant des décennies jusqu'à ce que des chercheurs de l'Université du Texas à Dallas lancent un projet pour analyser l'audio et le rendre accessible au public.

Des chercheurs du Center for Robust Speech Systems (CRSS) de l'Erik Jonsson School of Engineering and Computer Science (ECS) ont reçu une subvention de la National Science Foundation en 2012 pour développer des techniques de traitement de la parole pour reconstruire et transformer les archives massives d'audio en Explore Apollo. , un site Web qui offre un accès public aux documents. Le projet, en collaboration avec l'Université du Maryland, inclus l'audio de tout Apollo 11 et de la plupart des Apollo 13, Missions Apollo 1 et Gemini 8.

Un bond technologique de géant

Transcrire et reconstruire l'énorme archive audio nécessiterait un pas de géant dans le traitement de la parole et la technologie du langage. Par exemple, les communications ont été capturées sur plus de 200 bandes analogiques de 14 heures, chacun avec 30 pistes audio. La solution aurait besoin de déchiffrer la communication avec un discours brouillé, interférences techniques et chevauchement des boucles audio. Imaginez Siri d'Apple essayant de transcrire des discussions au milieu d'interruptions aléatoires et jusqu'à 35 personnes dans différents endroits, parlant souvent avec des accents régionaux du Texas.

Le projet, dirigé par le fondateur et directeur du CRSS, le Dr John H.L. Hansenand, chercheur scientifique, le Dr Abhijeet Sangwan, comprenait une équipe de doctorants qui ont travaillé pour établir des solutions pour numériser et organiser l'audio. Ils ont également développé des algorithmes pour traiter, reconnaître et analyser l'audio pour déterminer qui a dit quoi et quand. Les algorithmes sont décrits dans le numéro de novembre de Transactions IEEE/ACM sur l'audio, Discours, et traitement du langage .

Sept équipes de conception senior de premier cycle supervisées par le CRSS ont aidé à créer Explore Apollo pour rendre l'information accessible au public. Le projet a également reçu l'aide du Centre d'enseignement des sciences et de l'ingénierie de l'Université (SEEC), qui a évalué le site Explore Apollo.

Cinq ans plus tard, l'équipe termine son travail, qui a conduit à des avancées technologiques pour convertir la parole en texte, analyser les conférenciers et comprendre comment les gens ont collaboré pour accomplir les missions.

"CRSS a fait des progrès significatifs dans l'apprentissage automatique et l'extraction de connaissances pour évaluer l'interaction humaine pour l'une des tâches d'ingénierie les plus difficiles de l'histoire de l'humanité, " dit Hansen, doyen associé à la recherche en ECS, professeur de génie électrique et informatique, professeur à l'École des sciences du comportement et du cerveau, et Chaire distinguée en télécommunications.Raffiner l'équipement rétro

Quand ils ont commencé leur travail, les chercheurs ont découvert que la première chose à faire était de numériser l'audio. Le transfert de l'audio vers un format numérique s'est avéré être un exploit d'ingénierie en soi. La seule façon de jouer les rouleaux était sur un équipement des années 1960 au centre spatial Johnson de la NASA à Houston appelé SoundScriber.

"La NASA nous a indiqué le SoundScriber et a dit de faire ce que vous devez faire, " a déclaré Hansen.

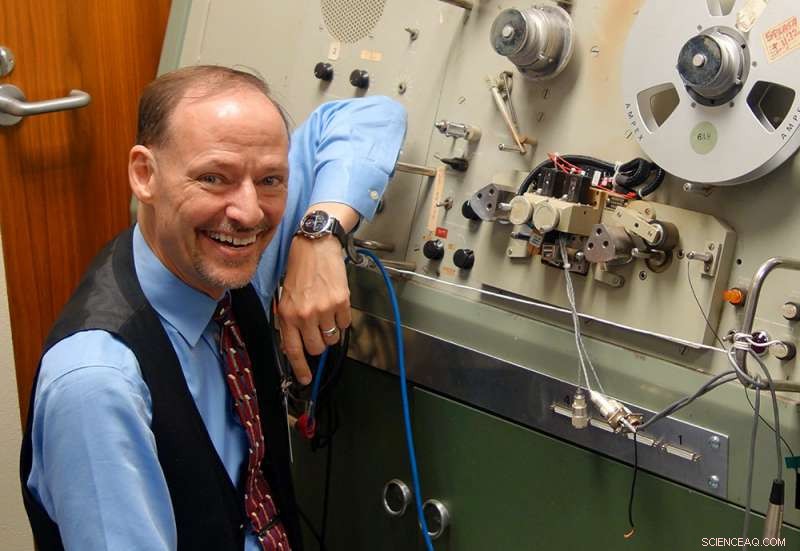

Le Dr John H.L. Hansen se tient à côté du SoundScriber, le seul appareil capable de lire les enregistrements analogiques de milliers d'heures de communications lors des missions lunaires de la NASA. Crédit :Université du Texas à Dallas

L'appareil ne pouvait lire qu'une seule piste à la fois. L'utilisateur devait faire tourner mécaniquement une poignée pour déplacer la tête de lecture de bande d'une piste à l'autre. D'après l'estimation de Hansen, il faudrait au moins 170 ans pour numériser uniquement l'audio de la mission Apollo 11 à l'aide de cette technologie.

"Nous ne pouvions pas utiliser ce système, nous avons donc dû en concevoir un nouveau, " a déclaré Hansen. " Nous avons conçu notre propre tête de lecture à 30 pistes, et construit une solution parallèle pour capturer les 30 pistes en même temps. C'est la seule solution qui existe sur la planète."

La nouvelle tête de lecture a réduit le processus de numérisation de plusieurs années à plusieurs mois. Cette tâche est devenue le travail de Tuan Nguyen, un senior en génie biomédical qui a passé un semestre à travailler à Houston.

Amplifier les voix des héros derrière les héros

Une fois qu'ils ont transféré l'audio des bobines aux fichiers numériques, les chercheurs devaient créer un logiciel capable de détecter l'activité de la parole, y compris le suivi de chaque personne qui parle et ce qu'elle a dit et quand, un processus appelé diarisation. Ils devaient également suivre les caractéristiques des locuteurs pour aider les chercheurs à analyser la façon dont les gens réagissent dans des situations tendues. En outre, les bandes comprenaient de l'audio provenant de divers canaux qui devaient être placés dans l'ordre chronologique.

Les chercheurs qui ont travaillé sur le projet ont déclaré que l'une des parties les plus difficiles était de comprendre comment les choses fonctionnaient à la NASA pendant les missions afin qu'ils puissent comprendre comment reconstruire l'énorme quantité d'audio.

"Ce n'est pas quelque chose qu'on peut apprendre en classe, " a déclaré Chengzhu Yu PhD'17. Yu a commencé son programme de doctorat au début du projet et a obtenu son diplôme au printemps dernier. Maintenant, il travaille comme chercheur scientifique spécialisé dans la technologie de reconnaissance vocale au centre de recherche sur l'intelligence artificielle de Tencent à Seattle.

Lakshmish Kaushik, un doctorant qui a quitté un emploi précédent pour travailler sur le projet, vise également à consacrer sa carrière à la technologie de reconnaissance vocale. Son rôle était de développer des algorithmes qui distinguaient la gamme de voix sur plusieurs canaux.

"Les quatre dernières années ont été vraiment exaltantes, " a déclaré Kaushik.

L'équipe a présenté le site Web interactif du Perot Museum of Nature and Science à Dallas. Pour Hansen, le projet a été l'occasion de mettre en lumière le travail des nombreuses personnes impliquées dans les missions lunaires au-delà des astronautes.

"Quand on pense à Apollon, nous gravitons autour des énormes contributions des astronautes qui méritent clairement nos louanges et notre admiration.

Cependant, les héros derrière les héros représentent les innombrables ingénieurs, scientifiques et spécialistes qui ont mis en commun leur expérience basée sur les STEM pour assurer le succès du programme Apollo, " a déclaré Hansen. " Espérons que les étudiants d'aujourd'hui continuent à mettre leur expérience dans les domaines des STIM pour relever les défis de demain. "