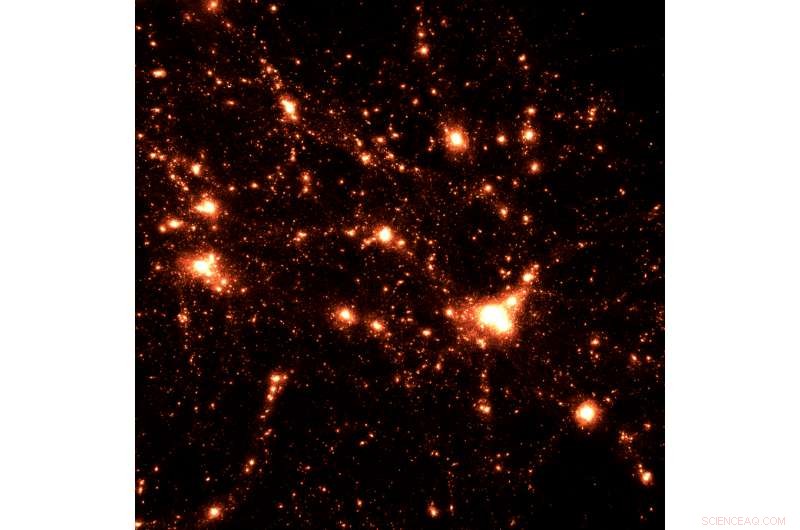

Cela montre la simulation de cosmologie HACC, qui combine une haute résolution spatiale et temporelle dans un grand volume cosmologique. La haute résolution temporelle suit l'évolution des structures dans les moindres détails et corrèle les histoires de formation aux environnements dans lesquels les structures se forment. Crédit :Laboratoire National d'Argonne

Il y a des centaines de milliards d'étoiles dans notre propre galaxie de la Voie lactée. Les estimations indiquent un nombre similaire de galaxies dans l'univers observable, chacun avec son propre grand assemblage d'étoiles, beaucoup avec leurs propres systèmes planétaires. Au-delà et entre ces étoiles et galaxies se trouvent toutes sortes de matière en différentes phases, comme le gaz et la poussière. Une autre forme de matière, matière noire, existe sous une forme très différente et mystérieuse, n'annonçant sa présence indirectement que par ses effets gravitationnels.

C'est l'univers que Salman Habib essaie de reconstruire, structure par structure, en utilisant des observations précises à partir d'enquêtes au télescope combinées à des techniques d'analyse de données et de simulation de nouvelle génération actuellement en cours de préparation pour le calcul exascale.

"Nous simulons tous les processus de la structure et de la formation de l'univers. C'est comme résoudre un très grand puzzle de physique, " dit Habib, Physicien senior et informaticien au sein des divisions Physique des hautes énergies, Mathématiques et Informatique du Laboratoire national d'Argonne du Département de l'énergie des États-Unis (DOE).

Habib dirige le projet « Computing the Sky at Extreme Scales » ou « ExaSky, " l'un des premiers projets financés par le récent Exascale Computing Project (ECP), un effort de collaboration entre le Bureau de la science du DOE et son Administration nationale de la sécurité nucléaire.

De la détermination de la cause initiale des fluctuations primordiales à la mesure de la somme de toutes les masses de neutrinos, les objectifs scientifiques de ce projet représentent une liste de blanchisserie des plus grandes questions, mystères et défis qui confondent actuellement les cosmologistes.

Il y a la question de l'énergie noire, la cause potentielle de l'expansion accélérée de l'univers, tandis qu'un autre encore est la nature et la distribution de la matière noire dans l'univers.

Ce sont des questions immenses qui exigent une puissance de calcul tout aussi étendue pour répondre. L'ECP prépare des codes scientifiques pour les systèmes exascale, les nouveaux chevaux de bataille de la science informatique et des mégadonnées.

Initié pour piloter le développement d'un « écosystème exascale » de pointe, architectures performantes, codes et cadres, l'ECP permettra aux chercheurs de s'attaquer à des problèmes de données et de calcul intensifs tels que les simulations ExaSky de l'univers connu.

En plus de l'ampleur de leurs demandes de calcul, Les projets ECP sont sélectionnés selon qu'ils répondent à des domaines stratégiques spécifiques, allant de la sécurité énergétique et économique à la découverte scientifique et aux soins de santé.

"La recherche de Salman porte certainement sur des questions scientifiques importantes et fondamentales, mais il a des avantages sociétaux, trop, " dit Paul Messine, Membre distingué d'Argonne. "Les êtres humains ont tendance à se demander d'où ils viennent, et cette curiosité est très profonde."

HACC'ing le ciel nocturne

Pour Habib, l'ECP présente un double défi :comment conduire une science de pointe sur des machines de pointe ?

L'équipe interdivisionnaire d'Argonne a travaillé sur la science grâce à un effort pluriannuel à l'Argonne Leadership Computing Facility (ALCF), une installation utilisateur du DOE Office of Science. L'équipe effectue des simulations cosmologiques pour des relevés du ciel à grande échelle sur l'ordinateur haute performance de 10 pétaflops de l'installation, Mira. Les simulations sont conçues pour fonctionner avec des données d'observation collectées à partir de télescopes d'enquête spécialisés, comme le futur Dark Energy Spectroscopic Instrument (DESI) et le Large Synoptic Survey Telescope (LSST).

Les télescopes d'arpentage examinent des zones beaucoup plus vastes du ciel - jusqu'à la moitié du ciel, à tout moment, que le télescope spatial Hubble, par exemple, qui se concentre davantage sur des objets individuels. Une nuit en se concentrant sur un patch, la nuit suivante un autre, les instruments d'arpentage examinent systématiquement le ciel pour développer un enregistrement cartographique du cosmos, comme Habib le décrit.

Travaillant en partenariat avec Los Alamos et Lawrence Berkeley National Laboratories, l'équipe d'Argonne se prépare à tracer la suite du parcours.

Leur code principal, qu'Habib a contribué à développer, fait déjà partie des codes de production scientifique les plus rapides utilisés. Appelé HACC (Hardware/Hybrid Accelerated Cosmology Code), ce cadre de cosmologie à base de particules prend en charge une variété de modèles de programmation et d'algorithmes.

Unique parmi les codes utilisés dans d'autres projets de calcul exascale, il peut fonctionner sur toutes les architectures actuelles et prototypes, de la puce X86 de base utilisée dans la plupart des PC domestiques, aux unités de traitement graphique, à la plus récente puce Knights Landing trouvée à Theta, le dernier système de calcul intensif de l'ALCF.

Aussi robuste que soit déjà le code, l'équipe HACC continue de le développer, l'ajout de nouvelles capacités importantes, tels que l'hydrodynamique et les modèles de sous-réseau associés.

"Lorsque vous exécutez de très grandes simulations de l'univers, tu ne peux pas tout faire, parce que c'est trop détaillé, " expliqua Habib. " Par exemple, si nous exécutons une simulation où nous avons littéralement des dizaines à des centaines de milliards de galaxies, nous ne pouvons pas suivre chaque galaxie en détail. Nous proposons donc des approches approximatives, appelés modèles de sous-réseau.

Même avec ces améliorations et ses succès, le code HACC devra encore augmenter ses performances et sa mémoire pour pouvoir fonctionner dans un framework exascale. En plus du HACC, le projet ExaSky utilise le code de raffinement de maillage adaptatif Nyx, développé à Lawrence Berkeley. HACC et Nyx se complètent avec différents domaines de spécialisation. La synergie entre les deux est un élément important de l'approche de l'équipe ExaSky.

Une approche de simulation cosmologique qui fusionne plusieurs approches permet la vérification de processus cosmologiques difficiles à résoudre impliquant l'évolution gravitationnelle, dynamique des gaz et effets astrophysiques à des gammes dynamiques très élevées. De nouvelles méthodes de calcul telles que l'apprentissage automatique aideront les scientifiques à reconnaître rapidement et systématiquement les caractéristiques des données d'observation et de simulation qui représentent des événements uniques.

Un billion de particules de lumière

Les travaux produits dans le cadre de l'ECP serviront à plusieurs fins, profitant à la fois à l'avenir de la modélisation cosmologique et au développement de plates-formes exascale performantes.

Côté modélisation, l'ordinateur peut générer de nombreux univers avec des paramètres différents, permettant aux chercheurs de comparer leurs modèles avec des observations pour déterminer quels modèles correspondent le plus précisément aux données. Alternativement, les modèles peuvent faire des prédictions pour des observations encore à faire.

Les modèles peuvent également produire des images extrêmement réalistes du ciel, ce qui est essentiel lors de la planification de grandes campagnes d'observation, comme celles de DESI et du LSST.

"Avant de dépenser de l'argent pour construire un télescope, il est important de produire également de très bonnes données simulées afin que les gens puissent optimiser les campagnes d'observation pour relever leurs défis de données, " dit Habib.

Mais le prix du réalisme est cher. Les simulations peuvent aller dans le domaine des billions de particules et produire plusieurs pétaoctets (quadrillions d'octets) de données en une seule exécution. À mesure que l'exascale devient répandue, ces simulations produiront 10 à 100 fois plus de données.

Le travail que fait l'équipe ExaSky, ainsi que celui des autres équipes de recherche d'ECP, aidera à relever ces défis et ceux auxquels sont confrontés les fabricants d'ordinateurs et les développeurs de logiciels en créant des plates-formes exascales fonctionnelles pour répondre aux besoins de la science à grande échelle. En travaillant avec leurs propres codes sur des machines pré-exascales, l'équipe de recherche ECP peut aider à guider les fournisseurs dans la conception de puces, Exigences de bande passante et de mémoire d'E/S et autres fonctionnalités.

"Toutes ces choses peuvent aider la communauté ECP à optimiser leurs systèmes, " a noté Habib. " C'est la raison fondamentale pour laquelle les équipes scientifiques d'ECP ont été choisies. Nous rapporterons au reste de la communauté scientifique les leçons que nous avons tirées de la gestion de cette architecture et disons :« Nous avons trouvé une solution. »