Crédit :Université du Texas à Austin

La progression rapide de la technologie a entraîné une augmentation considérable de la consommation d'énergie pour traiter les énormes quantités de données générées par les appareils. Mais des chercheurs de la Cockrell School of Engineering de l'Université du Texas à Austin ont trouvé un moyen de rendre la nouvelle génération d'ordinateurs intelligents plus économes en énergie.

Traditionnellement, les puces de silicium ont formé les éléments constitutifs de l'infrastructure qui alimente les ordinateurs. Mais cette recherche utilise des composants magnétiques au lieu de silicium et découvre de nouvelles informations sur la façon dont la physique des composants magnétiques peut réduire les coûts énergétiques et les exigences des algorithmes de formation - des réseaux de neurones qui peuvent penser comme les humains et faire des choses comme reconnaître des images et des modèles.

"À l'heure actuelle, les méthodes d'entraînement de vos réseaux de neurones sont très énergivores, " dit Jean Anne Incorvia, professeur adjoint au département de génie électrique et informatique de la Cockrell School. "Ce que notre travail peut faire, c'est aider à réduire l'effort de formation et les coûts énergétiques."

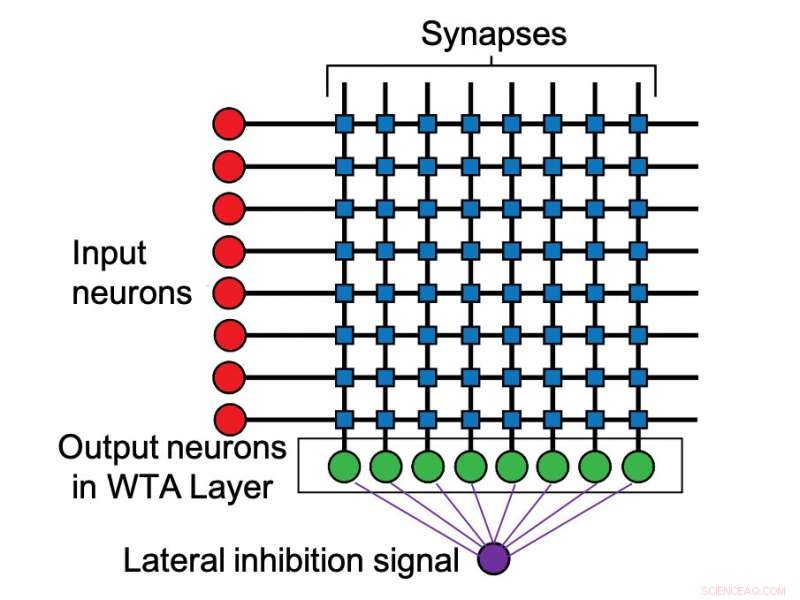

Les résultats des chercheurs ont été publiés cette semaine dans IOP Nanotechnologie . Incorvia a dirigé l'étude avec le premier auteur et étudiant diplômé de deuxième année Can Cui. Incorvia et Cui ont découvert que l'espacement des nanofils magnétiques, agissant comme des neurones artificiels, d'une certaine manière, augmente naturellement la capacité des neurones artificiels à se concurrencer, avec les plus activés gagnants. Atteindre cet effet, connue sous le nom d'« inhibition latérale, " nécessite traditionnellement des circuits supplémentaires dans les ordinateurs, ce qui augmente les coûts et prend plus d'énergie et d'espace.

Incorvia a déclaré que sa méthode fournit une réduction d'énergie de 20 à 30 fois la quantité utilisée par un algorithme de rétro-propagation standard lors de l'exécution des mêmes tâches d'apprentissage.

De la même manière que le cerveau humain contient des neurones, les ordinateurs de la nouvelle ère ont des versions artificielles de ces cellules nerveuses intégrales. L'inhibition latérale se produit lorsque les neurones qui se déclenchent le plus rapidement sont capables d'empêcher les neurones plus lents de se déclencher. En informatique, cela réduit la consommation d'énergie dans le traitement des données.

Incorvia explique que le fonctionnement des ordinateurs est en train de changer fondamentalement. Une tendance majeure est le concept de calcul neuromorphique, qui consiste essentiellement à concevoir des ordinateurs pour penser comme des cerveaux humains. Au lieu de traiter les tâches une par une, ces appareils plus intelligents sont destinés à analyser simultanément d'énormes quantités de données. Ces innovations ont alimenté la révolution de l'apprentissage automatique et de l'intelligence artificielle qui a dominé le paysage technologique ces dernières années.

Cette recherche a porté sur les interactions entre deux neurones magnétiques et les premiers résultats sur les interactions de plusieurs neurones. L'étape suivante consiste à appliquer les résultats à de plus grands ensembles de plusieurs neurones ainsi qu'à la vérification expérimentale de leurs résultats.