(De gauche à droite) Kevin Yager, Masafumi Fukuto, et Ruipeng Li ont préparé la ligne de lumière de diffusion de matériaux complexes (CMS) à NSLS-II pour une mesure utilisant le nouvel algorithme de prise de décision, qui a été développé par Marcus Noack (non illustré). Crédit :Laboratoire national de Brookhaven

Une équipe de scientifiques du Brookhaven National Laboratory et du Lawrence Berkeley National Laboratory du département américain de l'Énergie a conçu, créé, et testé avec succès un nouvel algorithme pour prendre des décisions de mesure scientifiques plus intelligentes. L'algorithme, une forme d'intelligence artificielle (IA), peut prendre des décisions autonomes pour définir et exécuter la prochaine étape d'une expérience. L'équipe a décrit les capacités et la flexibilité de leur nouvel outil de mesure dans un article publié le 14 août 2019 en Rapports scientifiques .

De Galilée et Newton à la récente découverte des ondes gravitationnelles, réaliser des expériences scientifiques pour comprendre le monde qui nous entoure a été la force motrice de notre progrès technologique pendant des centaines d'années. Améliorer la façon dont les chercheurs mènent leurs expériences peut avoir un impact considérable sur la rapidité avec laquelle ces expériences produisent des résultats applicables aux nouvelles technologies.

Au cours des dernières décennies, les chercheurs ont accéléré leurs expériences grâce à l'automatisation et à un assortiment toujours croissant d'outils de mesure rapides. Cependant, certains des défis scientifiques les plus intéressants et les plus importants, tels que la création de matériaux de batterie améliorés pour le stockage d'énergie ou de nouveaux matériaux quantiques pour de nouveaux types d'ordinateurs, nécessitent encore des expériences très exigeantes et chronophages.

En créant un nouvel algorithme d'aide à la décision dans le cadre d'un dispositif expérimental entièrement automatisé, l'équipe interdisciplinaire de deux des installations d'utilisateurs du DOE Office of Science de Brookhaven - le Center for Functional Nanomaterials (CFN) et la National Synchrotron Light Source II (NSLS-II) - et le Center for Advanced Mathematics for Energy Research Applications (CAMERA) de Berkeley Lab propose la possibilité d'étudier ces défis de manière plus efficace.

Le défi de la complexité

Le but de nombreuses expérimentations est d'acquérir des connaissances sur le matériau étudié, et les scientifiques disposent d'une méthode éprouvée pour y parvenir :ils prélèvent un échantillon du matériau et mesurent sa réaction aux changements de son environnement.

Une approche standard pour les scientifiques des installations d'utilisateurs telles que NSLS-II et CFN consiste à parcourir manuellement les mesures d'une expérience donnée pour déterminer la prochaine zone où ils pourraient vouloir mener une expérience. Mais l'accès aux outils de caractérisation des matériaux haut de gamme de ces installations est limité, le temps de mesure est donc précieux. Une équipe de recherche peut n'avoir que quelques jours pour mesurer ses matériaux, ils doivent donc tirer le meilleur parti de chaque mesure.

« La clé pour obtenir un nombre minimum de mesures et une qualité maximale du modèle résultant est d'aller là où les incertitudes sont grandes, " dit Marcus Noack, chercheur postdoctoral à CAMERA et auteur principal de l'étude. "Réaliser des mesures là-bas réduira le plus efficacement l'incertitude globale du modèle."

Comme Kevin Yager, co-auteur et scientifique du CFN, souligné, « L'objectif final n'est pas seulement d'obtenir des données plus rapidement, mais également d'améliorer la qualité des données que nous collectons. Je pense que les expérimentateurs passent de la microgestion de leur expérience à la gestion à un niveau supérieur. Au lieu d'avoir à décider où mesurer ensuite sur l'échantillon, les scientifiques peuvent à la place penser à la situation dans son ensemble, c'est finalement ce que nous, les scientifiques, essayons de faire."

"Cette nouvelle approche est un exemple appliqué d'intelligence artificielle, " a déclaré le co-auteur Masafumi Fukuto, un scientifique à NSLS-II. "L'algorithme de prise de décision remplace l'intuition de l'expérimentateur humain et peut parcourir les données et prendre des décisions intelligentes sur la façon dont l'expérience doit se dérouler."

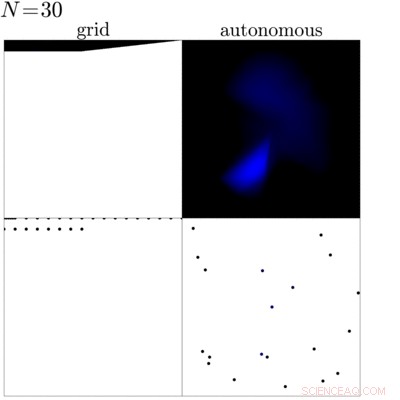

Cette animation montre une comparaison entre une mesure de grille traditionnelle (à gauche) d'un échantillon avec une mesure dirigée par le nouvel algorithme de prise de décision (à droite). Cette comparaison montre que l'algorithme peut identifier les bords et la partie interne de l'échantillon et concentre la mesure dans ces régions pour acquérir plus de connaissances sur l'échantillon. Crédit :Laboratoire national de Brookhaven

Plus d'informations pour moins ?

En pratique, avant de commencer une expérience, les scientifiques définissent un ensemble d'objectifs qu'ils veulent sortir de la mesure. Avec ces objectifs fixés, l'algorithme examine les données précédemment mesurées pendant que l'expérience est en cours pour déterminer la prochaine mesure. Dans sa recherche de la meilleure prochaine mesure, l'algorithme crée un modèle de substitution des données, qui est une supposition éclairée sur la façon dont le matériau se comportera dans les prochaines étapes possibles, et calcule l'incertitude (essentiellement la confiance qu'il a dans sa supposition) pour chaque étape suivante possible. Basé sur ceci, il sélectionne ensuite l'option la plus incertaine à mesurer ensuite. L'astuce ici consiste à choisir l'étape la plus incertaine à mesurer ensuite, l'algorithme maximise la quantité de connaissances qu'il acquiert en effectuant cette mesure. L'algorithme maximise non seulement le gain d'informations pendant la mesure, il définit également quand mettre fin à l'expérience en déterminant le moment où des mesures supplémentaires n'entraîneraient pas plus de connaissances.

"L'idée de base est, étant donné un tas d'expériences, comment pouvez-vous choisir automatiquement le meilleur suivant ?", a déclaré James Sethian, directeur de CAMERA et co-auteur de l'étude. "Marcus a construit un monde qui construit un modèle de substitution approximatif sur la base de vos expériences précédentes et suggère l'expérience la meilleure ou la plus appropriée à essayer ensuite."

Comment nous sommes arrivés ici

Faire des expérimentations autonomes une réalité, l'équipe a dû s'attaquer à trois éléments importants :l'automatisation de la collecte des données, analyse en temps réel, et, bien sûr, l'algorithme de prise de décision.

"C'est une partie passionnante de cette collaboration, " a déclaré Fukuto. " Nous avons tous fourni une pièce essentielle pour cela :l'équipe CAMERA a travaillé sur l'algorithme de prise de décision, Kevin de CFN a développé l'analyse des données en temps réel, et nous, à NSLS-II, avons fourni l'automatisation des mesures."

L'équipe a d'abord mis en œuvre son algorithme de prise de décision sur la ligne de lumière de diffusion des matériaux complexes (CMS) à NSLS-II, que le CFN et le NSLS-II opèrent en partenariat. Cet instrument offre des rayons X ultra-brillants pour étudier la nanostructure de divers matériaux. En tant que scientifique principal de la ligne de lumière de cet instrument, Fukuto avait déjà conçu la ligne de lumière en pensant à l'automatisation. La ligne de lumière propose un robot d'échange d'échantillons, mouvement automatique de l'échantillon dans différentes directions, et de nombreux autres outils utiles pour assurer des mesures rapides. Avec l'analyse de données en temps réel de Yager, la ligne de lumière était, de par sa conception, la solution idéale pour la première expérience « intelligente ».

La première expérience "intelligente"

La première expérience entièrement autonome réalisée par l'équipe consistait à cartographier le périmètre d'une gouttelette où les nanoparticules se séparent à l'aide d'une technique appelée diffusion des rayons X aux petits angles sur la ligne de lumière CMS. Lors de la diffusion des rayons X aux petits angles, les scientifiques projettent des rayons X brillants sur l'échantillon et, en fonction de la structure atomique à nanométrique de l'échantillon, les rayons X rebondissent dans différentes directions. Les scientifiques utilisent ensuite un grand détecteur pour capturer les rayons X diffusés et calculer les propriétés de l'échantillon au point éclairé. Dans cette première expérience, les scientifiques ont comparé l'approche standard de mesure de l'échantillon avec les mesures prises lorsque le nouvel algorithme de prise de décision appelait les coups. L'algorithme a pu identifier la zone de la gouttelette et s'est concentré sur ses bords et ses parties internes au lieu de l'arrière-plan.

"Après notre propre succès initial, nous voulions appliquer davantage l'algorithme, nous avons donc contacté quelques utilisateurs et proposé de tester notre nouvel algorithme sur leurs problèmes scientifiques, " dit Yager. " Ils ont dit oui, et depuis lors, nous avons mesuré divers échantillons. L'une des plus intéressantes a été une étude sur un échantillon qui a été fabriqué pour contenir un éventail de différents types de matériaux. Donc, au lieu de faire et de mesurer un nombre énorme d'échantillons et peut-être de rater une combinaison intéressante, l'utilisateur a fait un seul échantillon qui comprenait toutes les combinaisons possibles. Notre algorithme a alors pu explorer efficacement cette énorme diversité de combinaisons, " il a dit.

Et après?

Après les premières expériences réussies, les scientifiques prévoient d'améliorer encore l'algorithme et donc sa valeur pour la communauté scientifique. L'une de leurs idées est de rendre l'algorithme "sensible à la physique" - en tirant parti de tout ce qui est déjà connu sur le matériau à l'étude - afin que la méthode puisse être encore plus efficace. Un autre développement en cours consiste à utiliser l'algorithme lors de la synthèse et du traitement de nouveaux matériaux, par exemple, pour comprendre et optimiser les processus pertinents pour la fabrication de pointe, car ces matériaux sont incorporés dans des appareils du monde réel. L'équipe réfléchit également à une situation plus large et souhaite transférer la méthode autonome à d'autres configurations expérimentales.

« Je pense que les utilisateurs considèrent les lignes de lumière du NSLS-II ou les microscopes du CFN comme de puissants outils de caractérisation. Nous essayons de transformer ces capacités en une puissante installation de découverte de matériaux, " dit Fukuto.