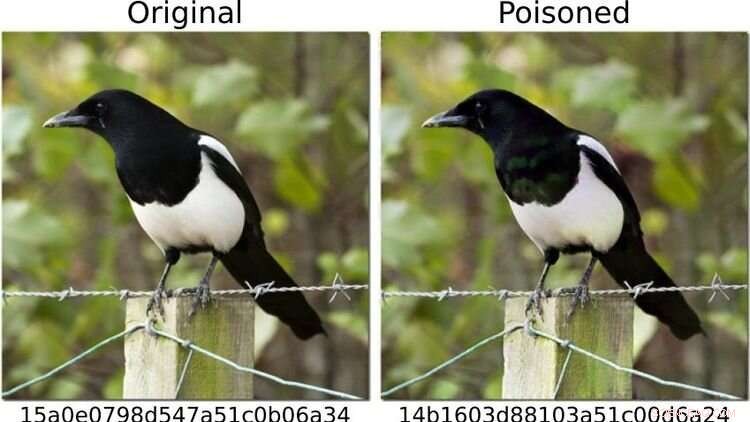

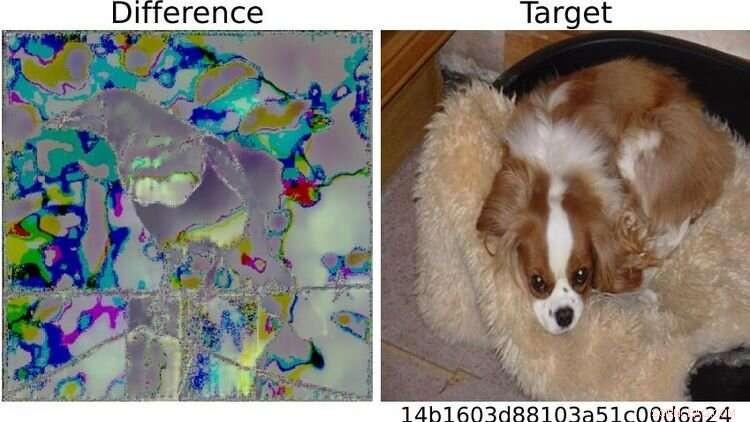

Pour mettre le système à l'épreuve, les chercheurs ont défini les images de chiens comme "dangereuses" et modifié d'autres motifs photographiques - comme celui de la pie à gauche - pour que (comme à droite) son empreinte digitale corresponde à celle d'un image de chien. Pour l'œil humain, les deux photos semblent identiques. Crédit :https://arxiv.org/abs/2111.06628

Les méthodes d'intelligence artificielle (IA) peuvent-elles détecter de manière fiable les images pédopornographiques sur les terminaux ?

Une étude dans laquelle l'informaticien d'Oldenbourg Daniel Neider a participé soulève des doutes quant à savoir si cela est actuellement possible. La recherche a été publiée dans Actes de la conférence ACM 2022 sur l'équité, la responsabilité et la transparence .

Ici, Neider discute de ses découvertes :

M. Neider, avez-vous un antivirus sur votre ordinateur ?

Je pense que chaque ordinateur Windows est livré avec un programme antivirus, alors oui.

Apple a installé son programme NeuralHash, qui analyse automatiquement les fichiers image à la recherche de pornographie juvénile, sur les appareils finaux l'année dernière. Fonctionne-t-il de la même manière qu'un programme antivirus ?

NeuralHash fait quelque chose de similaire, bien que son fonctionnement soit différent :le logiciel analyse les appareils finaux à la recherche d'un type de contenu spécifique, non pas comme les programmes antivirus, à la recherche de logiciels malveillants, mais d'images illégales. C'est ce qu'on appelle l'analyse côté client, qui fait référence à l'analyse des fichiers sur l'appareil de l'utilisateur.

Comment fonctionne exactement NeuralHash ?

Le programme est basé sur des méthodes d'intelligence artificielle et utilise ce qu'on appelle des réseaux de neurones. En termes simples, il s'agit d'un programme informatique formé pour reconnaître certains modèles dans les images. Le programme attribue une sorte de code à chaque image, essentiellement une séquence de chiffres et de lettres. Ces codes sont appelés hachages. Vous pouvez les imaginer comme des empreintes digitales générées pour chaque image. L'astuce est que les images qui se ressemblent se voient attribuer le même hachage. Ainsi, par exemple, toutes les images présentant des chats noirs pourraient se voir attribuer le hachage 3x580ac97e. Apple possède une grande base de données de ces hachages, qui peuvent être attribués à des images de pédopornographie. Et chaque fois qu'un utilisateur essaie de télécharger une image avec un hachage qui se trouve dans la base de données, l'image est marquée sans que l'utilisateur ne s'en aperçoive. Ces images ne peuvent pas être transférées.

Cela signifie-t-il qu'Apple sait quelles images se trouvent sur mon téléphone portable ?

Non, Apple ne regarde pas les images. Il n'a que la base de données avec les codes. L'idée est que l'entreprise travaille en collaboration avec des organisations de protection de l'enfance. Et sur la base de matériel provenant des forces de l'ordre, ces organisations utilisent un programme pour générer des hachages pour la base de données.

Vous avez analysé NeuralHash dans un projet de recherche avec des collègues de l'Université technique de Darmstadt. Comment est né le projet ?

Les réseaux de neurones ne fonctionnent pas toujours comme nous le pensons. La technologie est très prometteuse, mais elle n'est pas toujours précise à cent pour cent. Il est souvent difficile de savoir pourquoi il donne un certain résultat, car la procédure n'a pas été explicitement programmée. En principe, cette technologie a simplement appris à reconnaître certains modèles dans les données. Cependant, cela peut également être exploité pour tromper le programme - et cela fonctionne avec une fréquence alarmante. Nous nous sommes donc demandé :comment cela affecte-t-il un système destiné à être utilisé pour évaluer les contenus illégaux ? Que se passe-t-il si vous modifiez légèrement des images, par exemple ?

Pourquoi vous êtes-vous concentré sur NeuralHash ?

En 2021, Apple a livré un prototype de NeuralHash ainsi qu'une mise à jour du système d'exploitation pour les appareils finaux - essentiellement tous les appareils qui peuvent envoyer des photos au service de stockage en nuage iCloud, comme les iPhones ou les Mac. Le prototype n'était pas encore activé, donc le programme n'a pas commencé à vérifier les images sur les appareils Apple. Mais cette décision a mis la technologie à notre disposition ; nous avons pu extraire le programme et ainsi accéder au réseau de neurones. Nous voulions voir comment une grande entreprise s'y prendrait pour une telle tâche. Apple s'est ensuite abstenu de déployer officiellement NeuralHash en raison de critiques massives sur la surveillance de masse et l'invasion de la vie privée que cela impliquait.

Qu'avez-vous testé exactement ?

Nous avons testé comment le système pouvait être abusé. Pour éviter d'avoir à travailler avec du matériel pédopornographique, nous avons défini les images de chiens comme "dangereuses". Ensuite, nous avons calculé leurs "empreintes digitales". Dans le premier scénario, nous avons pris des images d'autres choses, par exemple d'un chat, et avons essayé de les modifier légèrement pour que le résultat soit une "empreinte digitale" d'un chien.

Cela a-t-il fonctionné ?

Oui, et cela s'est avéré relativement facile. Vous avez besoin d'accéder au réseau de neurones - que nous avions parce que le programme était installé sur les appareils - et vous avez besoin de connaissances sur le fonctionnement de l'apprentissage automatique. Mais ensuite, il est assez facile de modifier les images de chat pour qu'elles génèrent tout autre hachage. Pour l'œil humain, les photos manipulées ressemblent presque à l'original, vous ne pouvez pas vraiment faire la différence.

A droite, l'image du chien défini comme "dangereux" sur la base d'un test. En raison des différences visibles entre les deux images de pie à gauche, le système a déclenché l'alarme pour la photo qui avait été ainsi modifiée. Toute personne familiarisée avec l'apprentissage automatique pourrait donc "relativement facilement" jouer des tours avec le système, explique Neider. Crédit :https://arxiv.org/abs/2111.06628

Et c'est là que les choses deviennent problématiques...

Droit. Parce que je pourrais vous envoyer une photo manipulée, et au moment où vous essayez de la télécharger sur votre cloud ou de l'envoyer à quelqu'un d'autre via une application de messagerie, le système se déclenche sans que vous vous en rendiez compte. Vous ne savez même pas pourquoi la fonction de téléchargement ou de transfert est bloquée. Mais le vrai problème est qu'Apple remarque également que vous avez essayé d'envoyer une image suspecte. Et si cela se produit trop souvent, Apple décrypte le matériel et, si cela est jugé nécessaire, le signale aux autorités locales chargées de l'application de la loi. Cela signifie que du matériel pourrait être planté sur quelqu'un pour l'incriminer.

Qu'avez-vous testé d'autre ?

Nous avons aussi posé la question inverse :puis-je contourner le système ? Puis-je manipuler une image avec une empreinte digitale dans la base de données de manière à ce qu'elle génère une empreinte digitale différente ? Dans un scénario, nous supposons à nouveau que l'utilisateur a accès à l'IA via son appareil, est familiarisé avec le réseau de neurones et a une certaine connaissance de l'apprentissage automatique.

Et les images peuvent-elles être manipulées pour les rendre moins suspectes ?

Oui, ça marche très bien. Mais ce que nous avons également découvert, c'est que même si vous n'avez pas accès au système et que vous apportez des modifications très simples à une photo que n'importe qui peut faire avec son téléphone portable, il est possible de tromper le programme. Par exemple, en faisant simplement pivoter une image de 90 degrés, vous pouvez modifier considérablement "l'empreinte digitale". Ceci, bien sûr, n'est pas bon, car vous pouvez annuler ce changement simplement en faisant pivoter l'image de 90 degrés dans l'autre sens. Toutes les informations contenues dans l'image sont conservées. This shows that it's relatively easy to trick the system.

What conclusions do you draw from the study?

In my view, we don't know enough about neural networks at the moment to be able to use them safely. These programs are not robust enough for such sensitive tasks—as we saw in this case study. Moreover, in my opinion, the legislators should not rely on programs developed by corporations like Apple or Facebook in response to a law to do the right thing. For example, there is the danger that these companies will block more content than necessary, as a pre-emptive measure, so to speak, to avoid getting into trouble and having to pay high fines. Something similar is already happening in reaction to the Network Enforcement Law (also known as the Facebook Act).

So should we not use technology to automatically prevent the uploading of indexed images?

On the contrary, my colleagues and I are also in favor of using technology to combat child pornography. But we think it's important that there is a public discourse about what image recognition using neural networks can do, what it can't do, and what we are prepared to accept as collateral damage. From our point of view, it's always a matter of weighing up the pros and cons:if it's so easy to trick a program, is it really justifiable to install it on everyone's devices? After all, there is a risk of false alarms. At the same time, anyone who wants to can bypass the system relatively easily. So doesn't it actually do more harm than good? Of course, it's not up to us computer scientists to make the decisions here. Our contribution is to point out the problems with the technology so that a meaningful discussion can take place on that basis. Apple can scan your photos for child abuse and still protect your privacy