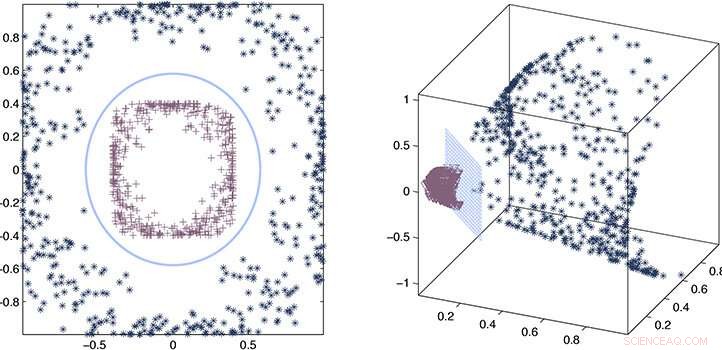

Les chercheurs ont utilisé un processus d'estimation d'erreur et d'approximation mathématique pour prouver que leur noyau approximatif reste cohérent avec le noyau précis. Crédit :2020 Ding et al.

En utilisant une fonction "noyau" approximative plutôt qu'explicite pour extraire des relations dans de très grands ensembles de données, Les chercheurs de KAUST ont pu accélérer considérablement la vitesse de l'apprentissage automatique. L'approche promet d'améliorer considérablement la vitesse de l'intelligence artificielle (IA) à l'ère des mégadonnées.

Lorsque l'IA est exposée à un grand ensemble de données inconnues, il doit analyser les données et développer un modèle ou une fonction qui décrit les relations dans l'ensemble. Le calcul de cette fonction, ou noyau, est une tâche gourmande en calculs dont la complexité augmente de manière cubique (à la puissance trois) avec la taille de l'ensemble de données. À l'ère des mégadonnées et du recours croissant à l'IA pour l'analyse, cela présente un réel problème où la sélection du noyau peut devenir très chronophage.

Sous la supervision de Xin Gao, Lizhong Ding et ses collègues ont travaillé sur des méthodes pour accélérer la sélection du noyau à l'aide de statistiques.

"La complexité de calcul de la sélection précise du noyau est généralement cubique avec le nombre d'échantillons, " dit Ding. " Ce type de mise à l'échelle cubique est prohibitif pour le Big Data. Nous avons plutôt proposé une approche d'approximation pour la sélection du noyau, ce qui améliore considérablement l'efficacité de la sélection du noyau sans sacrifier les performances prédictives."

Le noyau vrai ou précis fournit une description textuelle des relations dans l'ensemble de données. Ce que les chercheurs ont découvert, c'est que les statistiques peuvent être utilisées pour dériver un noyau approximatif qui est presque aussi bon que la version exacte, mais peut être calculé plusieurs fois plus rapidement, mise à l'échelle linéaire, plutôt que cubique, avec la taille de l'ensemble de données.

Pour développer l'approche, l'équipe a dû construire des matrices de noyaux spécifiquement conçues, ou des tableaux mathématiques, qui pourrait être calculé rapidement. Ils devaient également établir les règles et les limites théoriques pour la sélection du noyau approximatif qui garantirait toujours les performances d'apprentissage.

"Le principal défi était que nous devions concevoir de nouveaux algorithmes satisfaisant ces deux points en même temps, " dit Ding.

Combinant un processus d'estimation d'erreur et d'approximation mathématique, les chercheurs ont pu prouver que leur noyau approximatif reste cohérent avec le noyau précis, puis ont démontré ses performances dans des exemples réels.

"Nous avons montré que les méthodes approximatives, comme notre framework informatique, fournir une précision suffisante pour résoudre une méthode d'apprentissage basée sur le noyau, sans la charge de calcul peu pratique de méthodes précises, ", déclare Ding. "Cela fournit une solution efficace et efficiente aux problèmes d'exploration de données et de bioinformatique qui nécessitent une évolutivité."