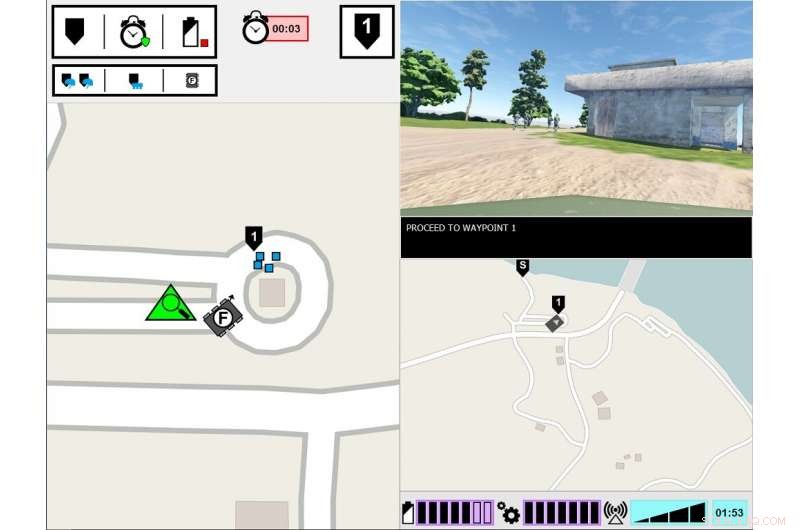

Interface expérimentale ASM. Le moniteur de gauche affiche le point de vue du soldat de tête sur l'environnement de la tâche. Le moniteur de droite affiche l'interface de communication de l'ASM. Crédit :armée américaine

Que faut-il pour qu'un humain fasse confiance à un robot ? C'est ce que des chercheurs de l'armée découvrent dans une nouvelle étude sur la façon dont les humains et les robots travaillent ensemble.

Recherche sur le teaming homme-agent, ou CHAPEAU, a examiné comment la transparence des agents, tels que les robots, véhicules sans pilote ou agents logiciels - influence la confiance humaine, exécution des tâches, charge de travail et perceptions de l'agent. La transparence de l'agent fait référence à sa capacité à transmettre aux humains son intention, processus de raisonnement et les plans futurs.

Une nouvelle recherche menée par l'armée révèle que la confiance humaine dans les robots diminue après que le robot a fait une erreur, même lorsqu'il est transparent dans son processus de raisonnement. Le papier, "Transparence et fiabilité des agents dans l'interaction homme-robot :l'influence sur la confiance des utilisateurs et la fiabilité perçue, " a été publié dans le numéro d'août de IEEE-Transactions sur les systèmes homme-machine .

À ce jour, la recherche s'est largement concentrée sur la THA avec des agents intelligents parfaitement fiables, ce qui signifie que les agents ne font pas d'erreurs, mais c'est l'une des rares études à avoir exploré comment la transparence des agents interagit avec la fiabilité des agents. Dans cette dernière étude, les humains ont vu un robot faire une erreur, et les chercheurs se sont concentrés sur la question de savoir si les humains percevaient le robot comme moins fiable, même lorsque l'humain a eu un aperçu du processus de raisonnement du robot.

« Comprendre comment le comportement du robot influence ses coéquipiers humains est crucial pour le développement d'équipes homme-robot efficaces, ainsi que la conception d'interfaces et de modes de communication entre les membres de l'équipe, " a déclaré le Dr Julia Wright, chercheur principal pour ce projet et chercheur au laboratoire de recherche de l'armée du commandement du développement des capacités de combat de l'armée américaine, également connu sous le nom d'ARL. « Cette recherche contribue aux efforts déployés par l'Armée de terre pour les opérations multi-domaines afin d'assurer une suradéquation des capacités basées sur l'intelligence artificielle. Mais elle est également interdisciplinaire, car ses conclusions éclaireront le travail des psychologues, roboticiens, ingénieurs, et les concepteurs de systèmes qui s'efforcent de faciliter une meilleure compréhension entre les humains et les agents autonomes dans le but de créer des coéquipiers autonomes plutôt que de simples outils.

Cette recherche était un effort conjoint entre l'ARL et l'Institut de simulation et de formation de l'Université de Floride centrale, et est la troisième et dernière étude du projet Autonomous Squad Member (ASM), parrainé par l'Initiative pilote de recherche sur l'autonomie du Bureau du secrétaire à la Défense. L'ASM est un petit robot terrestre qui interagit et communique avec une escouade d'infanterie.

Des études ASM antérieures ont étudié comment un robot communiquerait avec un coéquipier humain. En utilisant le modèle de transparence des agents basé sur la connaissance de la situation comme guide, diverses méthodes de visualisation pour véhiculer les objectifs de l'agent, intentions, raisonnement, contraintes, et les résultats projetés ont été explorés et testés. Un module iconographique en un coup d'œil a été développé sur la base de ces premiers résultats de l'étude, puis a été utilisé dans des études ultérieures pour explorer l'efficacité de la transparence des agents dans la THA.

Les chercheurs ont mené cette étude dans un environnement simulé, dans lequel les participants ont observé une équipe de soldats humains-agents, qui comprenait l'ASM, parcourant un parcours de formation. La tâche des participants était de surveiller l'équipe et d'évaluer le robot. L'équipe soldat-robot a rencontré divers événements tout au long du parcours et a réagi en conséquence. Alors que les soldats ont toujours répondu correctement à l'événement, parfois le robot a mal compris la situation, conduisant à des actions incorrectes. La quantité d'informations partagées par le robot variait d'un essai à l'autre. Alors que le robot expliquait toujours ses actions, les raisons de ses actions et le résultat attendu de ses actions, dans certains essais, le robot a également partagé le raisonnement derrière ses décisions, sa logique sous-jacente. Les participants ont vu plusieurs équipes de robots soldats, et leurs évaluations des robots ont été comparées.

L'étude a révélé qu'indépendamment de la transparence du robot dans l'explication de son raisonnement, la fiabilité du robot était le facteur déterminant ultime pour influencer les projections des participants sur la fiabilité future du robot, confiance dans le robot et perceptions du robot. C'est-à-dire, après que les participants ont été témoins d'une erreur, ils ont continué à évaluer la fiabilité du robot plus bas, même lorsque le robot n'a pas fait d'erreurs ultérieures. Bien que ces évaluations se soient lentement améliorées au fil du temps tant que le robot n'a commis aucune autre erreur, la confiance des participants dans leurs propres évaluations de la fiabilité du robot est restée réduite pendant le reste des essais, par rapport aux participants qui n'ont jamais vu d'erreur. Par ailleurs, les participants qui ont été témoins d'une erreur de robot ont signalé une confiance moindre dans le robot, par rapport à ceux qui n'ont jamais été témoins d'une erreur de robot.

Il a été constaté que l'augmentation de la transparence des agents améliore la confiance des participants dans le robot, mais uniquement lorsque le robot collectait ou filtrait des informations. Cela pourrait indiquer que le partage d'informations approfondies peut atténuer certains des effets d'une automatisation peu fiable pour des tâches spécifiques, dit Wright. En outre, les participants ont évalué le robot peu fiable comme moins animé, sympathique, intelligente, et sûr que le robot fiable.

"Des études antérieures suggèrent que le contexte est important pour déterminer l'utilité des informations de transparence, " a déclaré Wright. " Nous devons mieux comprendre quelles tâches nécessitent une compréhension plus approfondie du raisonnement de l'agent, et comment discerner ce que cette profondeur entraînerait. Les recherches futures devraient explorer les moyens de fournir des informations de transparence en fonction des exigences de la tâche. »