Crédits :openai

Les chercheurs ont fait l'actualité en laissant leurs ambitions d'IA jouer un formidable jeu de cache-cache avec des résultats formidables. L'environnement des agents avait des murs et des boîtes mobiles pour un défi où certains étaient les cacheurs et d'autres, chercheurs. Il s'est passé beaucoup de choses en cours de route, avec des surprises.

Énoncer ce qui a été appris, les auteurs ont écrit :« Nous avons observé des agents découvrir des outils de plus en plus complexes tout en jouant à un simple jeu de cache-cache, " où les agents ont construit " une série de six stratégies et contre-stratégies distinctes, dont certains dont nous ne savions pas que notre environnement était pris en charge."

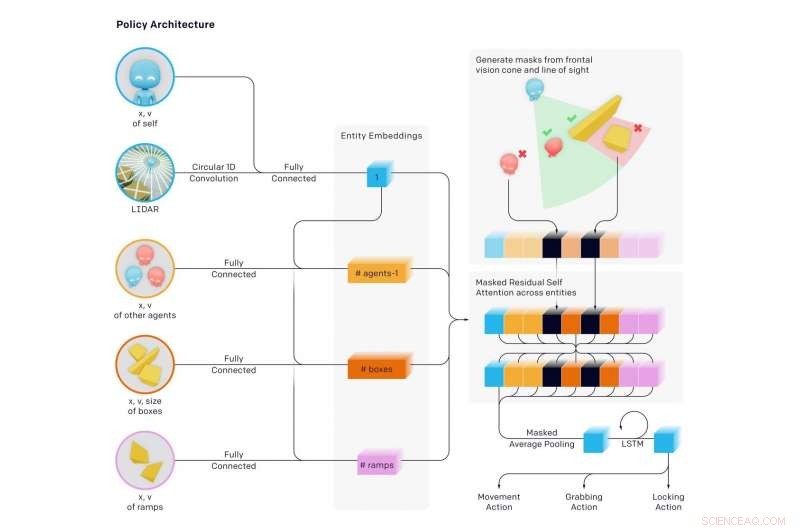

Dans un nouvel article publié plus tôt cette semaine, l'équipe a révélé des résultats. Leur papier, "Utilisation d'outils émergents à partir d'Autocurricula multi-agents, " avait sept auteurs, dont six avaient une représentation OpenAI répertoriée, et une, Cerveau Google.

Les auteurs ont commenté le type de défi qu'ils relevaient. « La création d'agents artificiels intelligents capables de résoudre une grande variété de tâches complexes pertinentes pour l'homme est un défi de longue date dans la communauté de l'intelligence artificielle. »

L'équipe a déclaré que « nous constatons que les agents créent un programme auto-supervisé induisant plusieurs cycles distincts de stratégie émergente, dont beaucoup nécessitent l'utilisation et la coordination d'outils sophistiqués."

Par cache-cache, (1) Les chercheurs ont appris à chasser les cacheurs et les cacheurs ont appris à s'enfuir (2) Les cacheurs ont appris à utiliser des outils de base :des boîtes et des murs pour construire des forts. (3) Les chercheurs ont appris à utiliser des rampes pour sauter dans l'abri des cacheurs (4) Les cacheurs ont appris à déplacer des rampes loin de l'endroit où ils construiront leur fort, et verrouillez-les en place (5) Les chercheurs ont appris qu'ils peuvent sauter des rampes verrouillées aux boîtes et surfer sur la boîte jusqu'à l'abri des cacheurs et (6) Les cacheurs ont appris à verrouiller les boîtes inutilisées avant de construire leur fort.

Ces six stratégies ont émergé sous la forme d'agents entraînés les uns contre les autres à cache-cache - chaque nouvelle stratégie a créé une pression auparavant inexistante pour que les agents passent à l'étape suivante, sans aucune incitation directe pour les agents à interagir avec des objets ou à explorer. Les stratégies étaient le résultat de l'« autocurriculum » induit par la compétition multi-agents et la dynamique de cache-cache.

Les auteurs du blog ont déclaré avoir appris « qu'il arrive souvent que des agents trouvent un moyen d'exploiter l'environnement que vous construisez ou le moteur physique de manière non intentionnelle ».

Ce qui se passait était une « complexité émergente auto-supervisée ». Et cela "suggère en outre que la co-adaptation multi-agents pourrait un jour produire un comportement extrêmement complexe et intelligent". Les auteurs ont également déclaré dans leur article que « induire des programmes d'études automatiques dans des environnements physiquement ancrés et ouverts pourrait éventuellement permettre aux agents d'acquérir un nombre illimité de compétences pertinentes pour l'homme ».

Douglas ciel, Nouveau scientifique , a vraiment suscité l'intérêt des lecteurs dans la façon dont il a décrit ce qui s'est passé :

"En premier, les cacheurs se sont simplement enfuis. Mais, ils ont vite compris que le moyen le plus rapide de bloquer les chercheurs était de trouver des objets dans l'environnement pour se cacher de la vue, en les utilisant comme une sorte d'outil. Par exemple, ils ont appris que les boîtes pouvaient être utilisées pour bloquer les portes et construire de simples cachettes. Les chercheurs ont appris qu'ils pouvaient déplacer une rampe et l'utiliser pour escalader les murs. Les bots ont alors découvert qu'être un joueur d'équipe – se passer des objets ou collaborer sur une cachette – était le moyen le plus rapide de gagner. »

C'était un projet ambitieux. Examiner leur travail, Examen de la technologie du MIT a noté que l'IA a appris à utiliser des outils après près de 500 millions de parties de cache-cache. En jouant à cache-cache des centaines de millions de tours, deux équipes opposées d'agents d'IA ont développé des stratégies complexes de dissimulation et de recherche.

Karen Hao a présenté un marqueur intéressant de ce que les agents ont appris après combien de tours :"... autour de la barre des 25 millions de parties, le jeu est devenu plus sophistiqué. Les cacheurs ont appris à déplacer et à verrouiller les boîtes et les barricades dans l'environnement pour construire des forts autour d'eux afin que les chercheurs ne les voient jamais. »

Plus de millions de tours :les chercheurs ont découvert une contre-stratégie, car ils ont appris à déplacer une rampe à côté du fort des cacheurs et à l'utiliser pour escalader les murs. Plus de tours plus tard, les cacheurs ont appris à verrouiller les rampes en place avant de construire leur fort.

Pourtant, d'autres stratégies sont apparues à la barre des 380 millions de parties. deux autres stratégies ont émergé. Les chercheurs ont développé une stratégie pour pénétrer dans le fort des cacheurs en utilisant une rampe verrouillée pour grimper sur une boîte non verrouillée, puis "surfer" sur le dessus de la boîte jusqu'au fort et au-dessus de ses murs. Dans la phase finale, les cacheurs ont de nouveau appris à verrouiller toutes les rampes et les boîtes en place avant de construire leur fort.

Hao a cité Bowen Baker, l'un des auteurs de l'article. "Nous n'avons pas dit aux cacheurs ou aux chercheurs de courir près d'une boîte ou d'interagir avec elle... Mais grâce à la compétition multi-agents, ils se sont créés de nouvelles tâches, de sorte que l'autre équipe a dû s'adapter."

Pensez-y. Baker a dit qu'ils n'avaient rien dit aux cacheurs, et ils n'ont pas dit aux chercheurs, courir près des boîtes ni interagir avec elles.

Devin Coldewey dans TechCrunch pensé. « L'étude visait à, et a examiné avec succès la possibilité pour les agents d'apprentissage automatique d'apprendre de manière sophistiquée, techniques pertinentes dans le monde réel sans aucune interférence des suggestions des chercheurs. »

Coldewey a cloué le coup à la maison pour tout ce travail. "Comme l'expliquent les auteurs de l'article, c'est un peu comme ça que nous sommes arrivés."

Nous, comme chez les êtres humains. Coldewey a cité un passage de leur article.

"La grande quantité de complexité et de diversité sur Terre a évolué en raison de la co-évolution et de la compétition entre les organismes, dirigé par la sélection naturelle. Lorsqu'une nouvelle stratégie ou mutation réussie émerge, il modifie la répartition implicite des tâches que les agents voisins doivent résoudre et crée une nouvelle pression d'adaptation. Ces courses aux armements évolutives créent des programmes automatiques implicites dans lesquels des agents concurrents créent continuellement de nouvelles tâches les uns pour les autres. »

© 2019 Réseau Science X