Crédit :Marquez, Suarez-Vargas &Shastri.

Une équipe de chercheurs de l'Université Queen's, au Canada, ont récemment proposé une nouvelle méthode pour réduire la taille des réseaux de neurones récurrents aléatoires (rRNN), une classe de réseaux de neurones artificiels qui est souvent utilisé pour faire des prédictions à partir de données. Leur approche, présenté dans un article pré-publié sur arXiv, permet aux développeurs de minimiser le nombre de neurones dans la couche cachée d'un rRNN, améliorant ainsi ses performances de prédiction.

"Notre laboratoire se concentre sur la conception de matériel pour les applications d'intelligence artificielle, " Bicky Marquez, l'un des chercheurs qui a mené l'étude, a déclaré TechXplore. "Dans cette étude, nous recherchions des stratégies pour comprendre les principes de fonctionnement des réseaux de neurones, et en même temps, essayer de réduire le nombre de neurones dans les réseaux que nous visions à construire sans affecter négativement leurs performances lors de la résolution d'une tâche. La tâche principale que nous voulions aborder était la prédiction, car cela a toujours été d'un grand intérêt pour la communauté scientifique et la société dans son ensemble."

Le développement d'outils d'apprentissage automatique capables de prédire les modèles futurs à partir des données est devenu l'objectif principal de nombreux groupes de recherche dans le monde. C'est loin d'être surprenant, car la prédiction d'événements futurs pourrait avoir des applications importantes dans une variété de domaines, par exemple, prévoir la météo, prévoir les mouvements de stock, ou cartographier l'évolution de certaines pathologies humaines.

L'étude menée par Marquez et ses collègues est de nature interdisciplinaire, car il fusionne les théories liées aux systèmes dynamiques non linéaires, Analyse des séries chronologiques, et l'apprentissage automatique. Les principaux objectifs des chercheurs étaient d'étendre la boîte à outils précédemment disponible pour l'analyse des réseaux neuronaux, minimiser le nombre de neurones dans la couche cachée des rRNN, et supprimer partiellement la propriété de boîte noire de ces réseaux.

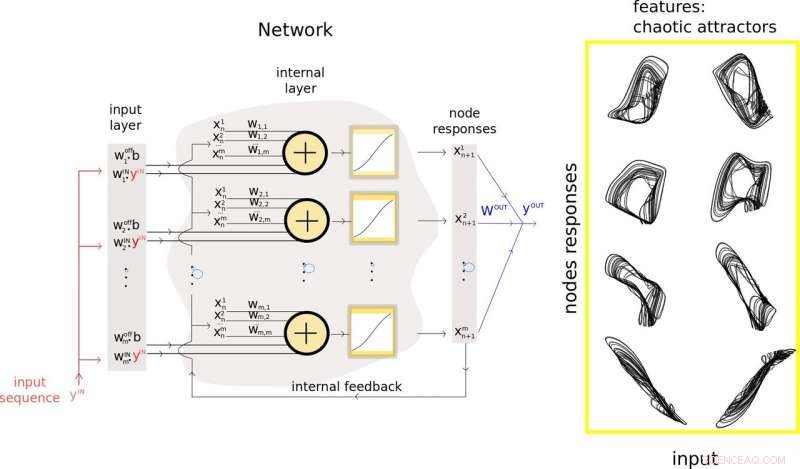

Pour y parvenir, ils ont introduit une nouvelle méthodologie qui fusionne la théorie de la prédiction et l'apprentissage automatique dans un seul cadre. Leur technique peut être utilisée pour extraire et utiliser les caractéristiques pertinentes des données d'entrée d'un rNN et guider le processus de réduction de la taille de ses couches cachées, améliorant finalement ses performances de prédiction.

Les chercheurs ont utilisé les informations recueillies dans leur étude pour développer un nouveau modèle de réseau neuronal artificiel appelé processeur inspiré de Takens. Ce modèle, composé de neurones réels et virtuels, atteint des performances de pointe sur des problèmes difficiles tels que la haute qualité, prédiction à long terme des signaux chaotiques.

"Le principal avantage de notre modèle est qu'il aborde les problèmes créés par la quantité massive de neurones qui composent les réseaux de neurones artificiels typiques, " Marquez a expliqué. "L'excès de neurones dans ces modèles se traduit généralement par des problèmes de calcul coûteux lorsqu'on envisage l'optimisation de tels réseaux pour résoudre une tâche. L'inclusion du concept de neurones virtuels dans notre conception est une étape très pratique pour la réduction de la quantité de neurones physiques."

Dans leur étude, Marquez et ses collègues ont également utilisé leur processeur hybride pour stabiliser un modèle neuronal arythmique d'excitabilité neuronale appelé Fitz-Hugh-Nagumo. Leur méthodologie leur a permis de réduire la taille du réseau de neurones stabilisant d'un facteur 15 par rapport aux autres réseaux de neurones standards.

"Notre approche nous a permis de découvrir certaines fonctionnalités pertinentes qui sont créées dans l'espace des réseaux, et qui sont les agents fondamentaux de prédictions réussies, " a déclaré Marquez. " Si nous pouvons identifier et supprimer le bruit autour de ces caractéristiques importantes, nous pourrions les utiliser pour améliorer les performances de nos réseaux."

La méthodologie conçue par Marquez et ses collègues est un ajout important aux outils précédemment disponibles pour le développement et l'analyse de rRNN. À l'avenir, leur approche pourrait éclairer la conception de réseaux de neurones plus efficaces pour la prédiction, réduire le nombre de nœuds et de connexions qu'ils contiennent. Leur technique pourrait également rendre les rRNN plus transparents, permettant aux utilisateurs d'accéder à des informations clés sur la façon dont un système est parvenu à une conclusion donnée.

"Nous nous concentrons sur le matériel neuromorphique, " dit Marquez. " Par conséquent, nos prochaines étapes seront liées à la mise en œuvre physique de tels réseaux récurrents aléatoires. Notre objectif ultime est de concevoir des ordinateurs inspirés du cerveau capables de résoudre très efficacement les problèmes d'intelligence artificielle :ultra-rapides et à faible consommation d'énergie. »

© 2019 Réseau Science X