Crédit :Ji Lin

Téléphones intelligents, des caméras de sécurité, et les haut-parleurs ne sont que quelques-uns des appareils qui exécuteront bientôt davantage de logiciels d'intelligence artificielle pour accélérer les tâches de traitement des images et de la parole. Une technique de compression connue sous le nom de quantification facilite la tâche en réduisant les modèles d'apprentissage en profondeur pour réduire les coûts de calcul et d'énergie. Mais des modèles plus petits, il s'avère, permettent aux attaquants malveillants de tromper plus facilement un système d'IA pour qu'il se comporte mal - une préoccupation car la prise de décision plus complexe est transférée aux machines.

Dans une nouvelle étude, Des chercheurs du MIT et d'IBM montrent à quel point les modèles d'IA compressés sont vulnérables aux attaques contradictoires, et ils offrent une solution :ajoutez une contrainte mathématique pendant le processus de quantification pour réduire les chances qu'une IA soit la proie d'une image légèrement modifiée et classe mal ce qu'elle voit.

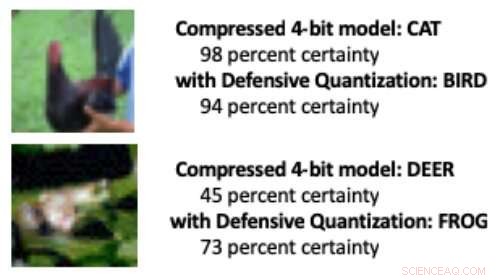

Lorsqu'un modèle d'apprentissage en profondeur est réduit des 32 bits standard à une longueur de bits inférieure, il est plus probable que les images modifiées soient mal classées en raison d'un effet d'amplification d'erreur :l'image manipulée devient plus déformée à chaque couche supplémentaire de traitement. À la fin, le modèle est plus susceptible de confondre un oiseau avec un chat, par exemple, ou une grenouille pour un cerf.

Les modèles quantifiés à 8 bits ou moins sont plus sensibles aux attaques adverses, les chercheurs montrent, avec une précision passant d'un niveau déjà bas de 30 à 40 % à moins de 10 % à mesure que la largeur de bit diminue. Mais contrôler la contrainte de Lipschitz lors de la quantification restaure une certaine résilience. Lorsque les chercheurs ont ajouté la contrainte, ils ont vu de petits gains de performance dans une attaque, les plus petits modèles surpassant dans certains cas le modèle 32 bits.

Lorsque quelques pixels ont été manipulés dans les images ci-dessus pour simuler une attaque contradictoire, un modèle compressé standard a classé à tort le poulet comme « chat » et la grenouille comme « cerf ». Mais lorsque les chercheurs ont ajouté une contrainte lors de la compression, le modèle a correctement classé les animaux, même mieux qu'un modèle 32 bits de précision complète. Crédit :Massachusetts Institute of Technology

"Notre technique limite l'amplification des erreurs et peut même rendre les modèles d'apprentissage en profondeur compressés plus robustes que les modèles de haute précision, " dit Song Han, professeur adjoint au département de génie électrique et d'informatique du MIT et membre des laboratoires de technologie des microsystèmes du MIT. "Avec une quantification appropriée, nous pouvons limiter l'erreur."

L'équipe prévoit d'améliorer encore la technique en l'entraînant sur des ensembles de données plus volumineux et en l'appliquant à un plus large éventail de modèles. « Les modèles d'apprentissage en profondeur doivent être rapides et sécurisés à mesure qu'ils évoluent dans un monde d'appareils connectés à Internet, " dit le co-auteur de l'étude Chuang Gan, chercheur au MIT-IBM Watson AI Lab. "Notre technique de quantification défensive aide sur les deux fronts."

Les chercheurs, qui incluent Ji Lin, étudiant diplômé du MIT, présenter leurs résultats à la Conférence internationale sur les représentations de l'apprentissage en mai.

En rendant les modèles d'IA plus petits afin qu'ils fonctionnent plus rapidement et consomment moins d'énergie, Han utilise l'IA elle-même pour repousser les limites de la technologie de compression de modèle. Dans des travaux récents connexes, Han et ses collègues montrent comment l'apprentissage par renforcement peut être utilisé pour trouver automatiquement la plus petite longueur de bit pour chaque couche dans un modèle quantifié en fonction de la vitesse à laquelle l'appareil exécutant le modèle peut traiter les images. Cette approche de largeur de bits flexible réduit la latence et la consommation d'énergie jusqu'à 200 % par rapport à un modèle 8 bits, dit Han. Les chercheurs présenteront leurs résultats lors de la conférence Computer Vision and Pattern Recognition en juin.

Cette histoire est republiée avec l'aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l'actualité de la recherche du MIT, innovation et enseignement.