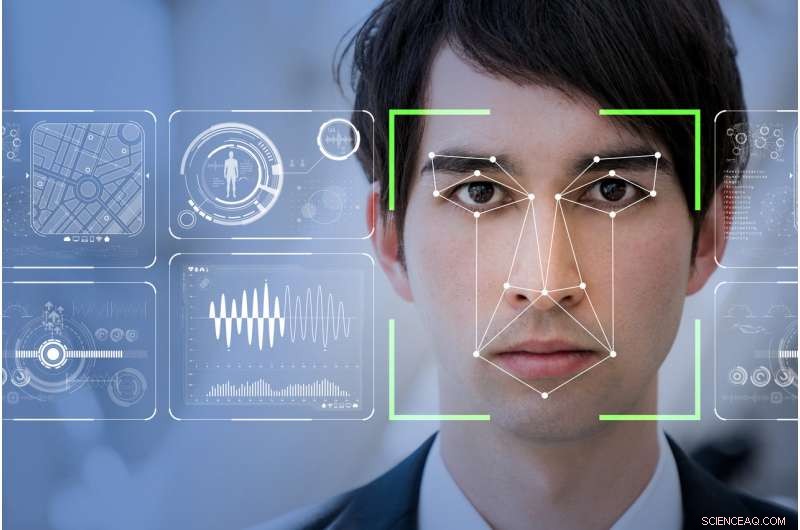

Le logiciel de reconnaissance faciale rendra-t-il le monde plus sûr, comme le prétendent les entreprises technologiques, ou rendra-t-il les marginalisés plus vulnérables et surveillés ? Crédit :Shutterstock

Ma mère disait toujours que j'avais un visage pour la radio. Dieu merci, car la radio peut être le dernier endroit dans ce monde amélioré par la technologie où votre visage ne déterminera pas votre statut social ou votre potentiel à commettre un crime.

Réseaux réels, le leader mondial d'une technologie qui permet la livraison numérique transparente de fichiers audio et vidéo sur Internet, vient de sortir sa dernière vision par ordinateur :un progiciel d'apprentissage automatique. L'espoir est que ce nouveau logiciel détectera, et potentiellement prédire, comportement suspect grâce à la reconnaissance faciale.

Appelé SAFR (Sécurisé, Reconnaissance faciale précise), l'ensemble d'outils a été commercialisé comme un moyen rentable de se fondre en douceur dans les systèmes de surveillance vidéo CCTV existants. Il pourra "détecter et faire correspondre des millions de visages en temps réel, " en particulier en milieu scolaire.

En apparence, RealNetworks considère sa technologie comme quelque chose qui peut rendre le monde plus sûr. Le branding accrocheur, cependant, masque les véritables enjeux éthiques entourant le déploiement des systèmes de détection faciale. Certains de ces problèmes incluent des questions sur les biais inhérents intégrés dans le code et, finalement, comment ces données capturées sont utilisées.

Le modèle chinois

Big Brother regarde. Aucun autre pays au monde n'a plus de vidéosurveillance que la Chine. Avec 170 millions de caméras de vidéosurveillance et quelque 400 millions de nouvelles en cours d'installation, c'est un pays qui a adopté et déployé la reconnaissance faciale à la manière orwellienne.

Dans le futur proche, ses citoyens, et ceux d'entre nous qui y voyagent, sera exposé à un vaste réseau intégré de systèmes de reconnaissance faciale surveillant tout, de l'utilisation des transports en commun, à accélérer la quantité de papier toilette que l'on utilise dans les toilettes publiques.

L'élément le plus inquiétant à ce jour est l'introduction récente de la reconnaissance faciale pour surveiller le comportement des écoliers dans les écoles publiques chinoises.

Dans le cadre de l'intégration complète par la Chine de son système de crédit social tout aussi orwellien – un programme d'incitation qui récompense l'engagement de chaque citoyen envers la morale dictée par l'État – ce système numérique entièrement intégré identifiera automatiquement une personne. Il peut alors déterminer la capacité d'une personne à progresser dans la société – et par extension le statut économique et social de la famille immédiate de cette personne – en surveillant le comportement non sanctionné de l'État.

En substance, La reconnaissance faciale empêche les personnes exposées de se payer le luxe de passer une mauvaise journée.

Les systèmes de reconnaissance faciale actuellement déployés dans les écoles chinoises surveillent tout, de l'assiduité en classe à la rêverie ou à l'attention d'un enfant. Il s'agit d'un système de surveillance complet qui détermine, dans une large mesure, l'avenir d'un enfant sans considérer que certaines qualités, comme la pensée abstraite, ne peut pas être facilement détecté ou au mieux, vu d'un bon œil, avec reconnaissance faciale.

Cela soulève également des notions d'éthique très inconfortables ou son absence, en particulier envers les membres les plus vulnérables de la société.

Besoin d'une régulation publique

Le lancement de SAFR par RealNetworks fait suite au manifeste passionné du président de Microsoft, Brad Smith, sur la nécessité d'une réglementation publique et d'une responsabilité d'entreprise dans le développement et le déploiement de la technologie de reconnaissance faciale.

Smith a souligné à juste titre que les outils de reconnaissance faciale sont encore quelque peu faussés et ont « des taux d'erreur plus élevés pour les femmes et les personnes de couleur ». Ce problème est double, en reconnaissant que les personnes qui codent peuvent inconsciemment intégrer des préjugés culturels.

Les ensembles de données actuellement disponibles peuvent manquer de la robustesse objective requise pour garantir que les visages des personnes ne sont pas mal identifiés, ou pire encore, prédéterminée par un biais codé comme cela commence maintenant à se produire dans le système scolaire chinois.

Dans un effort pour résoudre ce problème et une myriade d'autres problèmes connexes, Microsoft a créé un comité d'IA et d'éthique dans l'ingénierie et la recherche (AETHER). Ce comité est également mis en place pour les aider à se conformer au nouveau règlement général sur la protection des données (RGPD) de l'Union européenne et à son adoption future, sous une forme quelconque, en Amérique du Nord.

L'appel ardent de Smith interroge à juste titre l'utilisation et le déploiement prévus actuels et futurs des systèmes de reconnaissance faciale, ne parvient pas encore à expliquer comment Microsoft ou, par extension, d'autres leaders de la technologie de l'IA, peuvent éliminer les biais au sein de leur code de base ou de leurs ensembles de données dès le début.

Rapport minoritaire

Les traits de notre visage ne sont guère que des gestes que la force de l'habitude a rendu permanents .—Marcel Proust, 1919

Comme de nombreuses technologies, Pandora a déjà quitté la boîte. Si vous possédez un téléphone intelligent et utilisez Internet, vous avez déjà renoncé à toute notion de base d'anonymat personnel au sein de la société occidentale.

Le RGPD étant désormais pleinement engagé en Europe, la visite d'un site Web nécessite désormais que vous « acceptiez » la possibilité que ce site Web collecte des données personnelles. Les systèmes de reconnaissance faciale n'ont aucun moyen de suivre les règles du RGPD, donc en tant que tel, nous, en tant que société, sommes automatiquement « opt-in » et donc complètement à la merci de la façon dont nos visages sont enregistrés, traitées et stockées par le gouvernement, des systèmes de vidéosurveillance déployés en entreprise ou même en privé.

Les essais de reconnaissance faciale organisés en Angleterre par la police métropolitaine de Londres ont régulièrement abouti à un taux d'échec de 98 %. De la même manière, dans le sud-ouest du Pays de Galles, les tests n'ont fait que légèrement mieux avec moins de 10 pour cent de réussite.

Inversement, Université de Californie, Berkeley, les scientifiques ont conclu que la variation faciale substantielle est un trait évolutif unique aux humains. Alors, où est la déconnexion ?

Si, comme l'a suggéré Marcel Proust, nos vies et donc nos personnalités sont uniquement identifiables par nos visages, pourquoi les systèmes de reconnaissance faciale ne renvoient-ils pas facilement des résultats positifs ?

La réponse revient à la façon dont la programmation informatique est écrite et aux ensembles de données utilisés par ce code pour renvoyer une correspondance positive. Inévitablement, le code est écrit pour soutenir une notion idéalisée du type de visage.

En tant que tel, outlying variations like naturally occurring facial deformities or facial features affected by physical or mental trauma represent only a small fraction of the infinite possible facial variations in the world. The data sets assume we are homogeneous doppelgängers of each other, without addressing the micro-variations of peoples faces.

Si c'est le cas, we are all subject to the possibility that our faces as interpreted by the ever-increasing deployment of immature facial recognition systems will betray the reality of who we are.

Cet article a été initialement publié sur The Conversation. Lire l'article original.