Crédit :Google

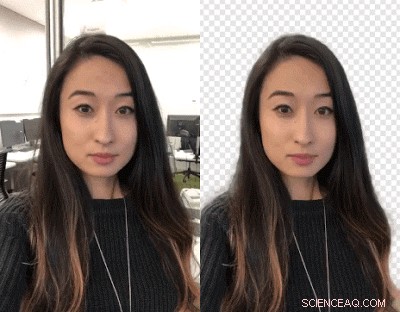

Créateurs de vidéos :vous voulez échanger des arrière-plans ? Mettez-vous KO. Les chercheurs de Google ont travaillé sur un moyen de vous permettre d'échanger vos arrière-plans vidéo à l'aide d'un réseau de neurones - aucun écran vert n'est requis.

Il est déployé dans les stories YouTube sur mobile de manière limitée, mentionné TechCrunch .

Jean Anon, Titres Android , a déclaré que les créateurs YouTube peuvent changer l'arrière-plan pour créer des vidéos plus attrayantes.

Valentin Bazarevsky et Andreï Tkachenka, ingénieurs logiciels, Recherche Google, fait l'annonce, intitulé "Segmentation vidéo mobile en temps réel".

Les créateurs de contenu vidéo savent que l'arrière-plan d'une scène peut être séparé de l'arrière-plan traité comme deux calques différents. La manœuvre est faite pour atteindre une ambiance, ou insérez un endroit amusant ou accentuez l'impact du message.

L'opération, ont déclaré les deux sur le site Google Research, est "un processus manuel fastidieux (par exemple, un artiste rotoscopique chaque image) ou nécessite un environnement de studio avec un écran vert pour la suppression de l'arrière-plan en temps réel (une technique appelée chroma keying)."

Traduction :Hillary Grigonis dans Tendances numériques mentionné, « Remplacer l'arrière-plan d'une vidéo nécessite généralement un logiciel de bureau avancé et beaucoup de temps libre, ou un studio à part entière avec un écran vert."

Maintenant, les deux ont annoncé une nouvelle technique, et cela fonctionnera sur les téléphones mobiles.

Leur technique permettra aux créateurs de remplacer et de modifier les arrière-plans sans équipement spécialisé.

Ils l'ont appelé le nouveau format vidéo léger de YouTube, conçu spécifiquement pour les créateurs YouTube.

Ils ont publié une annonce le 1er mars d'un « précis, temps réel, segmentation vidéo mobile sur l'appareil vers l'application YouTube en intégrant cette technologie dans les histoires."

Comment ont-ils fait ça `? Anon a déclaré que "le nœud de tout cela est l'apprentissage automatique".

Bazarevsky et Tkachenka ont déclaré avoir tiré parti de "l'apprentissage automatique pour résoudre une tâche de segmentation sémantique à l'aide de réseaux de neurones convolutifs".

Traduction :« Google développe une alternative à l'intelligence artificielle qui fonctionne en temps réel, depuis l'appareil photo d'un smartphone, " a écrit Grigonis.

Les deux ingénieurs ont décrit une architecture et une procédure de formation adaptées aux téléphones mobiles. Ils ont gardé à l'esprit qu'« une solution mobile doit être légère et fonctionner au moins 10 à 30 fois plus rapidement que les modèles de segmentation photo à la pointe de la technologie. »

Quant à un jeu de données, ils "ont annoté des dizaines de milliers d'images". Ceux-ci ont capturé un large éventail de poses de premier plan et de paramètres d'arrière-plan.

"Avec cet ensemble de données, le groupe a formé le programme pour séparer l'arrière-plan du premier plan, " dit Grigonis.

Devin Coldewey dans TechCrunch :"Le réseau a appris à repérer les traits communs d'une tête et des épaules, et une série d'optimisations a réduit la quantité de données à traiter pour le faire. »

Tendances numériques expliqué comment cela fonctionne :« Une fois que le logiciel masque l'arrière-plan sur la première image, le programme utilise ce même masque pour prédire l'arrière-plan dans l'image suivante. Lorsque cette image suivante n'a que des ajustements mineurs par rapport à la première... le programme fera de petits ajustements au masque. Lorsque l'image suivante est très différente de la dernière... le logiciel écartera entièrement cette prédiction de masque et créera un nouveau masque."

Un résultat final de leur travail, comme dit sur le blog Google Research, est que "notre réseau fonctionne remarquablement vite sur les appareils mobiles, atteindre 100+ FPS sur iPhone 7 et 40+ FPS sur Pixel 2 avec une grande précision (réalisant 94,8% IOU sur notre ensemble de données de validation), offrant une variété d'effets fluides et réactifs dans les histoires YouTube."

Et après?

Il est en version bêta limitée. "Notre objectif immédiat est d'utiliser le déploiement limité dans les histoires YouTube pour tester notre technologie sur ce premier ensemble d'effets. À mesure que nous améliorons et étendons notre technologie de segmentation à plus d'étiquettes, nous prévoyons de l'intégrer dans les services plus larges de réalité augmentée de Google."

© 2018 Tech Xplore