Quand un ordinateur met le visage de Nicolas Cage sur la tête d'Elon Musk, il peut ne pas aligner correctement le visage et la tête. Crédits :Siwei Lyu, CC BY-ND

Les vidéos Deepfake sont difficiles à détecter pour les yeux non entraînés car elles peuvent être assez réalistes. Qu'elles soient utilisées comme armes personnelles de vengeance, manipuler les marchés financiers ou déstabiliser les relations internationales, les vidéos montrant des gens faisant et disant des choses qu'ils n'ont jamais faites ou dites sont une menace fondamentale pour l'idée de longue date selon laquelle « voir c'est croire ». Plus maintenant.

La plupart des deepfakes sont réalisés en montrant à un algorithme informatique de nombreuses images d'une personne, puis lui faire utiliser ce qu'il a vu pour générer de nouvelles images de visage. À la fois, leur voix est synthétisée, il semble donc que la personne a dit quelque chose de nouveau.

Certains des travaux antérieurs de mon groupe de recherche nous ont permis de détecter des vidéos deepfake qui n'incluaient pas la quantité normale de clignement des yeux d'une personne, mais la dernière génération de deepfakes s'est adaptée, donc nos recherches ont continué à progresser.

Maintenant, notre recherche peut identifier la manipulation d'une vidéo en examinant de près les pixels de trames spécifiques. Faire un pas de plus, nous avons également développé une mesure active pour protéger les individus contre les attaques de deepfakes.

Trouver des défauts

Dans deux articles de recherche récents, nous avons décrit des moyens de détecter les deepfakes avec des défauts qui ne peuvent pas être corrigés facilement par les faussaires.

Lorsqu'un algorithme de synthèse vidéo deepfake génère de nouvelles expressions faciales, les nouvelles images ne correspondent pas toujours au positionnement exact de la tête de la personne, ou les conditions d'éclairage, ou la distance à la caméra. Pour que les faux visages se fondent dans l'environnement, ils doivent être géométriquement transformés - tournés, redimensionné ou autrement déformé. Ce processus laisse des artefacts numériques dans l'image résultante.

Vous avez peut-être remarqué des artefacts provenant de transformations particulièrement sévères. Ceux-ci peuvent donner à une photo un aspect manifestement falsifié, comme des frontières floues et une peau artificiellement lisse. Des transformations plus subtiles laissent encore des traces, et nous avons appris un algorithme pour le détecter, même quand les gens ne peuvent pas voir les différences.

Ces artefacts peuvent changer si une vidéo deepfake a une personne qui ne regarde pas directement la caméra. Une vidéo qui capture une personne réelle montre son visage se déplaçant en trois dimensions, mais les algorithmes deepfake ne sont pas encore capables de fabriquer des visages en 3-D. Au lieu, ils génèrent une image bidimensionnelle régulière du visage puis tentent de le faire pivoter, redimensionnez et déformez cette image pour l'adapter à la direction dans laquelle la personne est censée regarder.

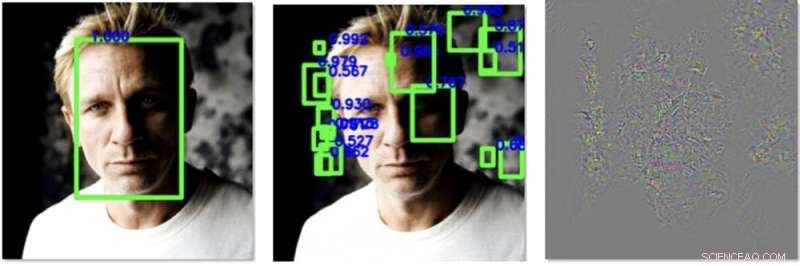

A gauche, un visage est facilement détecté dans une image avant notre traitement. Au milieu, nous avons ajouté des perturbations qui font qu'un algorithme détecte d'autres visages, mais pas le vrai. À droite se trouvent les changements que nous avons ajoutés à l'image, amélioré 30 fois pour être visible. Crédits :Siwei Lyu, CC BY-ND

Ils ne le font pas encore très bien, qui offre une opportunité de détection. Nous avons conçu un algorithme qui calcule dans quelle direction le nez de la personne pointe dans une image. Il mesure également dans quelle direction pointe la tête, calculé à partir du contour du visage. Dans une vraie vidéo de la tête d'une personne réelle, ceux-ci devraient tous s'aligner de manière assez prévisible. Dans les deepfakes, bien que, ils sont souvent mal alignés.

Se défendre contre les deepfakes

La science de la détection des deepfakes est, effectivement, une course aux armements - les faussaires deviendront meilleurs dans leurs fictions, et donc notre recherche doit toujours essayer de suivre, et même prendre un peu d'avance.

S'il y avait un moyen d'influencer les algorithmes qui créent des deepfakes pour qu'ils soient pires dans leur tâche, cela améliorerait notre méthode pour détecter les contrefaçons. Mon groupe a récemment trouvé un moyen de le faire.

Les bibliothèques d'images de visages sont assemblées par des algorithmes qui traitent des milliers de photos et de vidéos en ligne et utilisent l'apprentissage automatique pour détecter et extraire les visages. Un ordinateur peut regarder une photo de classe et détecter les visages de tous les élèves et de l'enseignant, et ajoutez uniquement ces visages à la bibliothèque. Lorsque la bibliothèque résultante contient de nombreuses images de visage de haute qualité, le deepfake qui en résulte est plus susceptible de réussir à tromper son public.

Nous avons trouvé un moyen d'ajouter du bruit spécialement conçu aux photographies ou aux vidéos numériques qui ne sont pas visibles à l'œil nu mais peuvent tromper les algorithmes de détection de visage. Il peut masquer les motifs de pixels que les détecteurs de visage utilisent pour localiser un visage, et crée des leurres qui suggèrent qu'il y a un visage là où il n'y en a pas, comme dans un morceau de l'arrière-plan ou un carré de vêtement d'une personne.

Avec moins de vrais visages et plus de non-visages qui polluent les données d'entraînement, un algorithme deepfake sera pire pour générer un faux visage. Cela ralentit non seulement le processus de fabrication d'un deepfake, mais rend également le deepfake résultant plus imparfait et plus facile à détecter.

Au fur et à mesure que nous développons cet algorithme, nous espérons pouvoir l'appliquer à toutes les images que quelqu'un télécharge sur les réseaux sociaux ou un autre site en ligne. Pendant le processus de téléchargement, peut-être, on peut leur demander, « Voulez-vous protéger les visages de cette vidéo ou image contre leur utilisation dans des deepfakes ? » Si l'utilisateur choisit oui, alors l'algorithme pourrait ajouter le bruit numérique, laisser les gens en ligne voir les visages mais les cacher efficacement aux algorithmes qui pourraient chercher à se faire passer pour eux.

Cet article est republié à partir de The Conversation sous une licence Creative Commons. Lire l'article original.