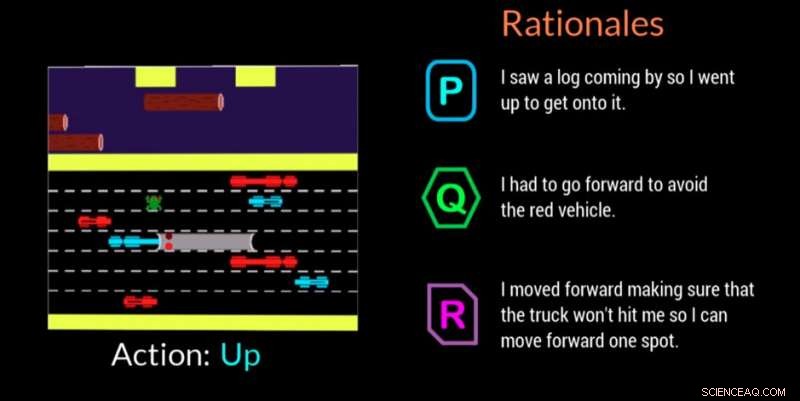

Un agent d'IA explique sa justification pour prendre une décision dans ce jeu vidéo. Crédit :Georgia Tech

Chercheurs du Georgia Institute of Technology, en collaboration avec l'Université Cornell et l'Université du Kentucky, ont développé un agent artificiellement intelligent (IA) qui peut générer automatiquement des explications en langage naturel en temps réel pour transmettre les motivations derrière ses actions. Le travail est conçu pour donner aux humains qui s'engagent avec des agents d'IA ou des robots l'assurance que l'agent exécute correctement la tâche et peut expliquer une erreur ou un comportement erroné.

L'agent utilise également un langage de tous les jours que les non-experts peuvent comprendre. Les explications, ou « rationnels » comme les appellent les chercheurs, sont conçus pour être identifiables et inspirer confiance à ceux qui pourraient être sur le lieu de travail avec des machines d'IA ou interagir avec elles dans des situations sociales.

"Si le pouvoir de l'IA doit être démocratisé, il doit être accessible à tous quelles que soient leurs capacités techniques, " dit Upol Ehsan, doctorat étudiant à la School of Interactive Computing de Georgia Tech et chercheur principal.

"Alors que l'IA imprègne tous les aspects de nos vies, il existe un besoin distinct de conception d'IA centrée sur l'humain qui rend les systèmes d'IA en boîte noire explicables aux utilisateurs quotidiens. Notre travail constitue une étape formative vers la compréhension du rôle des explications basées sur le langage et la façon dont les humains les perçoivent. »

L'étude a été soutenue par l'Office of Naval Research (ONR).

Les chercheurs ont développé une étude participative pour déterminer si leur agent d'IA pouvait proposer des justifications imitant les réponses humaines. Les spectateurs ont regardé l'agent de l'IA jouer au jeu vidéo Frogger, puis ont classé trois justifications à l'écran dans l'ordre de la façon dont chacune décrivait le mouvement de jeu de l'IA.

Sur les trois justifications anonymisées pour chaque mouvement - une réponse générée par l'homme, la réponse de l'IA-agent, et une réponse générée aléatoirement - les participants ont préféré les justifications générées par l'homme en premier, mais les réponses générées par l'IA étaient juste derrière.

Frogger a offert aux chercheurs la possibilité de former une IA dans un « environnement de prise de décision séquentielle, " ce qui est un défi de recherche important car les décisions que l'agent a déjà prises influencent les décisions futures. Par conséquent, expliquer la chaîne de raisonnement aux experts est difficile, et encore plus lorsqu'il s'agit de communiquer avec des non-experts, selon les chercheurs.

Les spectateurs humains ont compris le but de Frogger de ramener la grenouille à la maison en toute sécurité sans être heurtée par des véhicules en mouvement ou noyée dans la rivière. La mécanique de jeu simple de monter, vers le bas, gauche ou droite, a permis aux participants de voir ce que faisait l'IA, et d'évaluer si les justifications à l'écran justifiaient clairement le déménagement.

Les spectateurs ont jugé les justifications sur la base de :

Les justifications générées par l'IA qui ont été classées plus haut par les participants étaient celles qui montraient une reconnaissance des conditions environnementales et de l'adaptabilité, ainsi que ceux qui ont communiqué la prise de conscience des dangers à venir et planifiés pour eux. Des informations redondantes qui ne faisaient qu'énoncer l'évidence ou dénaturer l'environnement se sont avérées avoir un impact négatif.

"Ce projet consiste plus à comprendre les perceptions et les préférences humaines de ces systèmes d'IA qu'à créer de nouvelles technologies, " a déclaré Ehsan. " Au cœur de l'explicabilité se trouve la création de sens. Nous essayons de comprendre ce facteur humain."

Une deuxième étude connexe a validé la décision des chercheurs de concevoir leur agent d'IA pour pouvoir offrir l'un des deux types distincts de justifications :

Dans cette deuxième étude, les participants ne se sont vu proposer des justifications générées par l'IA qu'après avoir regardé l'IA jouer à Frogger. On leur a demandé de sélectionner la réponse qu'ils préféraient dans un scénario où une IA commettait une erreur ou se comportait de manière inattendue. Ils ne savaient pas que les justifications étaient regroupées dans les deux catégories.

Par une marge de 3 pour 1, les participants ont privilégié les réponses classées dans la catégorie « image complète ». Les réponses ont montré que les gens appréciaient l'IA en pensant aux étapes futures plutôt qu'à ce qui se passait sur le moment, ce qui pourrait les rendre plus enclins à faire une autre erreur. Les gens voulaient également en savoir plus afin d'aider directement l'IA à corriger le comportement erroné.

« La compréhension située des perceptions et des préférences des personnes travaillant avec des machines d'IA nous donne un ensemble puissant d'informations exploitables qui peuvent nous aider à concevoir une conception mieux centrée sur l'humain, générateur de rationalité, agents autonomes, " a déclaré Mark Riedl, professeur d'informatique interactive et membre principal du corps professoral du projet.

Une direction future possible pour la recherche appliquera les résultats à des agents autonomes de divers types, tels que les agents compagnons, et comment ils pourraient réagir en fonction de la tâche à accomplir. Les chercheurs examineront également comment les agents pourraient réagir dans différents scénarios, comme lors d'une intervention d'urgence ou lorsque vous aidez les enseignants en classe.

La recherche a été présentée en mars lors de la conférence 2019 sur les interfaces utilisateur intelligentes de l'Association for Computing Machinery. L'article s'intitule "Génération de justification automatisée :une technique pour une IA explicable et ses effets sur les perceptions humaines". Ehsan présentera un exposé de position soulignant les défis de conception et d'évaluation des systèmes d'IA explicable centrés sur l'humain lors du prochain atelier Emerging Perspectives in Human-Centered Machine Learning à la conférence ACM CHI 2019, 4-9 mai, à Glasgow, Écosse.