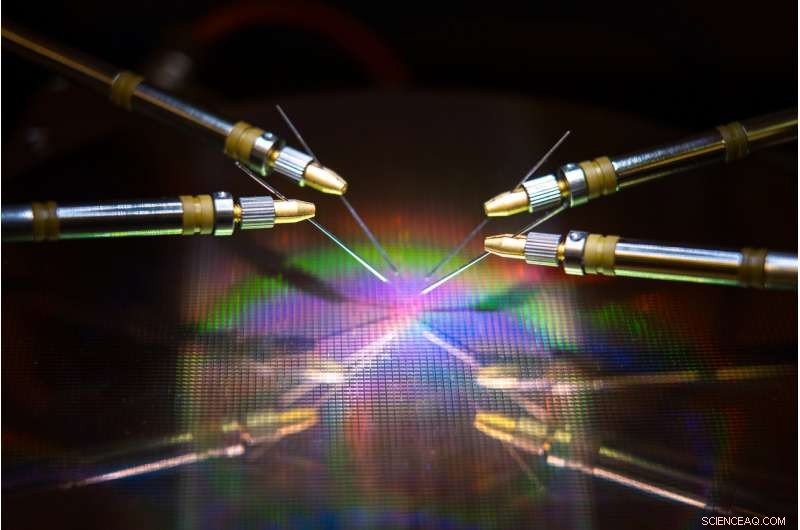

Une équipe dirigée par l'UC San Diego a développé du matériel et des algorithmes qui pourraient réduire la consommation d'énergie et le temps lors de la formation d'un réseau de neurones. Crédit:David Baillot / UC San Diego Jacobs School of Engineering

Une équipe dirigée par l'Université de Californie à San Diego a développé une approche de co-conception matériel-logiciel neuroinspirée qui pourrait rendre la formation sur les réseaux neuronaux plus économe en énergie et plus rapide. Leurs travaux pourraient permettre un jour de former des réseaux de neurones sur des appareils à faible consommation comme les smartphones, ordinateurs portables et appareils embarqués.

L'avancée est décrite dans un article publié récemment dans Communication Nature .

Entraîner les réseaux de neurones à effectuer des tâches telles que reconnaître des objets, naviguer dans des voitures autonomes ou jouer à des jeux consomme beaucoup de temps et de puissance de calcul. De gros ordinateurs avec des centaines à des milliers de processeurs sont généralement nécessaires pour apprendre ces tâches, et les temps de formation peuvent prendre de quelques semaines à plusieurs mois.

C'est parce que faire ces calculs implique de transférer des données entre deux unités distinctes - la mémoire et le processeur - et cela consomme la plupart de l'énergie et du temps pendant la formation du réseau neuronal, a déclaré l'auteur principal Duygu Kuzum, professeur de génie électrique et informatique à la Jacobs School of Engineering de l'UC San Diego.

Pour résoudre ce problème, Kuzum et son laboratoire se sont associés à Adesto Technologies pour développer du matériel et des algorithmes permettant d'effectuer ces calculs directement dans l'unité de mémoire, éliminant le besoin de mélanger les données à plusieurs reprises.

« Nous nous attaquons à ce problème à partir de deux extrémités - l'appareil et les algorithmes - pour maximiser l'efficacité énergétique lors de la formation des réseaux de neurones, " a déclaré le premier auteur Yuhan Shi, un doctorat en génie électrique. étudiant dans le groupe de recherche de Kuzum à l'UC San Diego.

Le composant matériel est un type de technologie de mémoire non volatile à très haut rendement énergétique, une matrice de RAM de pontage conductrice sous-quantique (CBRAM) de 512 kilobits. Il consomme 10 à 100 fois moins d'énergie que les principales technologies de mémoire d'aujourd'hui. L'appareil est basé sur la technologie de mémoire CBRAM d'Adesto - il a principalement été utilisé comme périphérique de stockage numérique qui n'a que les états "0" et "1", mais Kuzum et son laboratoire ont démontré qu'il peut être programmé pour avoir plusieurs états analogiques pour émuler des synapses biologiques dans le cerveau humain. Ce dispositif dit synaptique peut être utilisé pour effectuer des calculs en mémoire pour l'entraînement des réseaux de neurones.

"La mémoire sur puce dans les processeurs conventionnels est très limitée, ils n'ont donc pas assez de capacité pour effectuer à la fois le calcul et le stockage sur la même puce. Mais dans cette approche, nous avons une matrice mémoire haute capacité qui peut effectuer des calculs liés à l'apprentissage du réseau neuronal dans la mémoire sans transfert de données vers un processeur externe. Cela permettra beaucoup de gains de performances et réduira la consommation d'énergie pendant l'entraînement, " a déclaré Kuzoum.

Kuzoum, qui est affilié au Center for Machine-Integrated Computing and Security de l'UC San Diego, a mené des efforts pour développer des algorithmes qui pourraient être facilement mappés sur ce réseau de dispositifs synaptiques. Les algorithmes ont permis d'économiser encore plus d'énergie et de temps lors de l'apprentissage du réseau de neurones.

L'approche utilise un type de réseau de neurones écoénergétiques, appelé réseau de neurones à pics, pour la mise en œuvre de l'apprentissage non supervisé dans le matériel. En plus de ça, L'équipe de Kuzum applique un autre algorithme d'économie d'énergie qu'ils ont développé appelé "élagage doux, ", ce qui rend la formation en réseau de neurones beaucoup plus économe en énergie sans sacrifier beaucoup en termes de précision.

Yuhan Shi configure le réseau de périphériques synaptiques pour les tests. Crédit :Université de Californie - San Diego

Algorithmes d'économie d'énergie

Les réseaux de neurones sont une série de couches connectées de neurones artificiels, où la sortie d'une couche fournit l'entrée à la suivante. La force des connexions entre ces couches est représentée par ce qu'on appelle des "poids". L'entraînement d'un réseau de neurones traite de la mise à jour de ces poids.

Les réseaux de neurones conventionnels dépensent beaucoup d'énergie pour mettre à jour en permanence chacun de ces poids. Mais dans les réseaux de neurones dopés, seuls les poids qui sont liés aux neurones dopés sont mis à jour. Cela signifie moins de mises à jour, ce qui signifie moins de puissance et de temps de calcul.

Le réseau fait également ce qu'on appelle l'apprentissage non supervisé, ce qui signifie qu'il peut essentiellement s'entraîner lui-même. Par exemple, si le réseau affiche une série de chiffres numériques manuscrits, il découvrira comment faire la distinction entre les zéros, ceux, deux, etc. Un avantage est que le réseau n'a pas besoin d'être formé sur des exemples étiquetés - ce qui signifie qu'il n'a pas besoin d'être informé qu'il voit un zéro, un ou deux, ce qui est utile pour les applications autonomes comme la navigation.

Pour rendre l'entraînement encore plus rapide et plus économe en énergie, Le laboratoire de Kuzum a développé un nouvel algorithme qu'ils ont surnommé « l'élagage en douceur » à mettre en œuvre avec le réseau de neurones à pics non supervisés. L'élagage doux est une méthode qui trouve les poids qui ont déjà mûri pendant l'entraînement, puis les définit sur une valeur constante non nulle. Cela les empêche d'être mis à jour pour le reste de la formation, ce qui minimise la puissance de calcul.

La taille douce se distingue des méthodes de taille conventionnelles car elle est mise en œuvre lors de la formation, plutôt qu'après. Cela peut également conduire à une plus grande précision lorsqu'un réseau de neurones met son entraînement à l'épreuve. Normalement en taille, les poids redondants ou sans importance sont complètement supprimés. L'inconvénient est que vous taillez plus de poids, moins le réseau est précis pendant les tests. Mais la taille douce maintient simplement ces poids dans un réglage à faible énergie, ils sont donc toujours là pour aider le réseau à fonctionner avec une plus grande précision.

Co-conception hardware-logiciel à l'épreuve

L'équipe a mis en œuvre le réseau de neurones à pointes neuroinspirés non supervisés et l'algorithme d'élagage doux sur le réseau de dispositifs synaptiques sous-quantiques CBRAM. Ils ont ensuite formé le réseau à classer les chiffres manuscrits de la base de données MNIST.

Dans les essais, le réseau a classé les chiffres avec une précision de 93 %, même lorsque jusqu'à 75 % des poids ont été élagués en douceur. En comparaison, le réseau a fonctionné avec une précision de moins de 90 pour cent lorsque seulement 40 pour cent des poids ont été élagués à l'aide de méthodes d'élagage conventionnelles.

En termes d'économies d'énergie, l'équipe estime que leur approche de co-conception matériel-logiciel neuroinspirée peut éventuellement réduire de deux à trois ordres de grandeur la consommation d'énergie lors de l'entraînement des réseaux neuronaux par rapport à l'état de l'art.

« Si nous comparons le nouveau matériel à d'autres technologies de mémoire similaires, nous estimons que notre appareil peut réduire la consommation d'énergie de 10 à 100 fois, puis notre algorithme de co-conception réduit cela de 10 autres. Dans l'ensemble, on peut s'attendre à un gain de cent à mille fois en termes de consommation d'énergie suivant notre approche, " a déclaré Kuzoum.

Avancer, Kuzum et son équipe prévoient de travailler avec des entreprises de technologie de mémoire pour faire avancer ce travail vers les prochaines étapes. Leur objectif ultime est de développer un système complet dans lequel les réseaux de neurones peuvent être entraînés en mémoire pour effectuer des tâches plus complexes avec des budgets de puissance et de temps très faibles.