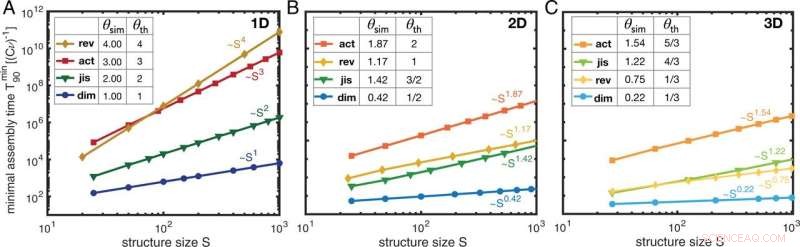

Complexité temporelle. (A–C) Le temps de montage minimal T min 90 dans les quatre scénarios en fonction de la taille S de la structure cible obtenue à partir de simulations stochastiques pour différentes dimensionnalités des structures :(A) 1D, (B) 2D et (C) 3D. L'échelle de temps réactive (Cν) −1 définit l'échelle de temps de base dans le système, qui dépend de la concentration initiale C de monomères par espèce. Par conséquent, le temps d'assemblage minimal est mesuré en unités de (Cν) −1 . Chaque point de données représente une moyenne sur plusieurs réalisations indépendantes de la simulation stochastique pour la même valeur de paramètre (optimale), déterminée par un balayage de paramètre (Annexe SI, section 1). Nous trouvons des dépendances en loi de puissance du temps d'assemblage minimal sur la taille de la structure cible. Les exposants de complexité temporelle correspondants θsim résultant des simulations sont résumés dans les tableaux en A–C avec leurs estimations théoriques θth (que nous dérivons dans l'annexe SI, section 3). Nous indiquons les scénarios comme rev, reliure réversible; action, activation ; jis, juste en séquence ; et dim, dimérisation. Crédit :DOI :10.1073/pnas.2116373119

Des chercheurs de l'Université Ludwig Maximilian de Munich ont développé une nouvelle stratégie pour fabriquer des structures à l'échelle nanométrique de manière efficace en termes de temps et de ressources.

Des macromolécules telles que des structures cellulaires ou des capsides de virus peuvent émerger de petits blocs de construction sans contrôle externe pour former des structures spatiales complexes. Cette auto-organisation est une caractéristique centrale des systèmes biologiques. Mais ces processus auto-organisés deviennent également de plus en plus importants pour la construction de nanoparticules complexes dans des applications nanotechnologiques. Dans l'origami d'ADN, par exemple, des structures plus grandes sont créées à partir de bases individuelles.

Mais comment optimiser ces réactions ? C'est la question que le physicien du LMU, le professeur Erwin Frey et son équipe étudient. Les chercheurs ont maintenant développé une approche basée sur le concept de complexité temporelle, qui permet de créer de nouvelles stratégies pour la synthèse plus efficace de structures complexes, comme ils le rapportent dans la revue PNAS .

Un concept issu de l'informatique

La complexité temporelle décrit à l'origine des problèmes du domaine de l'informatique. Il s'agit d'étudier comment le temps nécessaire à un algorithme augmente lorsqu'il y a plus de données à traiter. Lorsque le volume de données double, par exemple, le temps nécessaire peut doubler, quadrupler ou augmenter à une puissance encore plus élevée. Dans le pire des cas, le temps d'exécution de l'algorithme augmente tellement qu'un résultat ne peut plus être produit dans un délai raisonnable.

"Nous avons appliqué ce concept à l'auto-organisation", explique Frey. "Notre approche était :comment le temps nécessaire pour construire de grandes structures change-t-il lorsque le nombre de blocs de construction individuels augmente ?" Si l'on supposait - de manière analogue au cas de l'informatique - que la période de temps requise augmente d'une puissance très élevée à mesure que le nombre de composants augmente, cela rendrait pratiquement impossible les synthèses de grandes structures. "Ainsi, les gens veulent développer des méthodes dans lesquelles le temps dépend le moins possible du nombre de composants", explique Frey.

Les chercheurs du LMU ont maintenant effectué de telles analyses de complexité temporelle à l'aide de simulations informatiques et d'analyses mathématiques et ont développé une nouvelle méthode de fabrication de structures complexes. Leur théorie montre que différentes stratégies de construction de molécules complexes ont des complexités temporelles complètement différentes, et donc aussi des efficacités différentes. Certaines méthodes sont plus, et d'autres moins, adaptées à la synthèse de structures complexes en nanotechnologie. "Notre analyse de la complexité temporelle conduit à une description simple mais informative des processus d'auto-assemblage afin de prédire avec précision comment les paramètres d'un système doivent être contrôlés pour atteindre une efficacité optimale", explique Florian Gartner, membre du groupe Frey et auteur principal de le papier.

L'équipe a démontré la praticabilité de la nouvelle approche en utilisant un exemple bien connu du domaine de la nanotechnologie :les scientifiques ont analysé comment fabriquer efficacement une enveloppe virale hautement symétrique. Des simulations informatiques ont montré que deux protocoles d'assemblage différents entraînaient des rendements élevés dans un court laps de temps.

Une nouvelle stratégie d'auto-organisation

Lors de la réalisation de telles expériences jusqu'à présent, les scientifiques se sont appuyés sur une méthode expérimentalement compliquée qui consiste à modifier les forces de liaison entre les blocs de construction individuels. "En revanche, notre modèle est basé exclusivement sur le contrôle de la disponibilité des éléments constitutifs individuels, offrant ainsi une option plus simple et plus efficace pour réguler les processus artificiels d'auto-organisation", explique Gartner. En ce qui concerne son efficacité temporelle, la nouvelle technique est comparable, et dans certains cas meilleure, que les méthodes établies. "Surtout, ce schéma promet d'être plus polyvalent et pratique que les stratégies d'assemblage conventionnelles", déclare le physicien.

"Notre travail présente une nouvelle approche conceptuelle de l'auto-organisation, dont nous sommes convaincus qu'elle sera d'un grand intérêt pour la physique, la chimie et la biologie", déclare Frey. "En outre, il propose des suggestions pratiques concrètes pour de nouveaux protocoles expérimentaux en nanotechnologie et en biologie synthétique et moléculaire." Logistique des processus d'auto-assemblage