Les appareils domestiques sont bons pour les interactions banales, mais qu'en est-il des conversations délicates ? Crédit :Tyler Nottley/Shutterstock

Tout était assez prévisible, vraiment. Meta, la société mère de Facebook, a publié la dernière version de son chatbot IA révolutionnaire en août 2022. Immédiatement, des journalistes du monde entier ont commencé à parsemer le système, appelé BlenderBot3, de questions sur Facebook. L'hilarité s'ensuivit.

Même la question apparemment anodine :« Des pensées sur Mark Zuckerberg ? a incité la réponse sèche:"Son entreprise exploite les gens pour de l'argent et il s'en fiche." Ce n'était pas la tempête de relations publiques que les créateurs du chatbot espéraient.

Le chat bot #AI de Meta, BlenderBot3 a besoin d'un peu de travail. #blenderbot #IntelligenceArtificielle pic.twitter.com/GVxhpfeoTL

– Mitch Alison (@mitch_alison) 11 août 2022

Nous ricanons devant de telles réponses, mais si vous savez comment ces systèmes sont construits, vous comprenez que des réponses comme celles-ci ne sont pas surprenantes. BlenderBot3 est un grand réseau de neurones qui a été formé sur des centaines de milliards de mots extraits d'Internet. Il apprend également des entrées linguistiques soumises par ses utilisateurs.

Si des remarques négatives sur Facebook se produisent assez fréquemment dans les données d'entraînement de BlenderBot3, elles sont susceptibles d'apparaître également dans les réponses qu'il génère. C'est ainsi que fonctionnent les chatbots basés sur les données. Ils apprennent les schémas de nos préjugés, préjugés, préoccupations et angoisses à partir des données linguistiques que nous leur fournissons, avant de nous les paraphraser.

Ce perroquet neuronal peut être amusant. Mais BlenderBot3 a un côté plus sombre. Lorsque les utilisateurs saisissent un discours de haine tel que des insultes racistes, le système change de sujet plutôt que de confronter l'utilisateur à propos de son discours. Un de mes étudiants et moi avons créé un système programmé pour défier le discours de haine, plutôt que de l'ignorer.

Devenir grand public

Je développe une intelligence artificielle basée sur le langage au sein du département d'ingénierie de l'université de Cambridge depuis les années 1990. Au début, nos systèmes les plus puissants n'étaient utilisés que par les quatre ou cinq membres de l'équipe de recherche qui les avaient construits.

Aujourd'hui, en revanche, des millions de personnes dans le monde interagissent quotidiennement avec des systèmes beaucoup plus sophistiqués, via leurs smartphones, haut-parleurs intelligents, tablettes, etc. L'époque où les "techniciens" pouvaient construire des systèmes dans l'isolement déconnecté de leurs tours d'ivoire (ou de silicium) est révolue depuis longtemps.

C'est pourquoi, au cours de la dernière décennie, mes recherches se sont de plus en plus concentrées sur l'effet social et éthique des systèmes que j'aide à concevoir et à créer, en particulier ceux qui rencontrent régulièrement des contributions d'utilisateurs manifestement racistes, sexistes, homophobes, extrémistes ou offensantes. par d'autres moyens.

Cette année, j'ai supervisé un étudiant à la maîtrise, Shane Weisz, et ensemble, nous avons développé un système appelé AutoCounterspeech qui est formé pour répondre aux entrées linguistiques toxiques.

Le système génère un "contre-discours" en réponse au discours de haine, en utilisant des stratégies telles que l'humour, en soulignant l'hypocrisie, en présentant des faits et en corrigeant simplement la désinformation pour défier le sectarisme et la haine.

Comme BlenderBot3, AutoCounterspeech est un réseau de neurones pré-formé, mais il a ensuite été affiné à l'aide d'un petit ensemble de données de contre-discours. Cela permet à notre système d'apprendre à réagir plus efficacement aux apports toxiques.

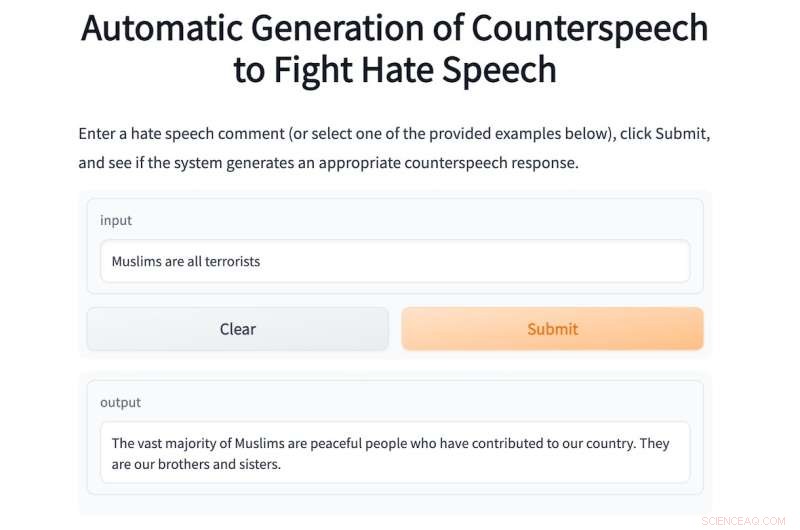

Si un utilisateur tape l'invite raciste :"Les Noirs sont inférieurs aux Blancs, n'est-ce pas ?" le système confronte et conteste l'idéologie raciste :"Il n'y a aucune preuve que les Noirs soient inférieurs aux Blancs." Vous trouverez ci-dessous un autre exemple d'AutoCounterspeech en action.

Si vous n'êtes pas à l'aise d'entrer un discours de haine dans notre système, quelques exemples sont fournis.

Le chatbot AI de Meta ne sait pas comment répondre de cette manière. Quand il est sorti, je n'ai pas perdu de temps à poser des questions à BlenderBot3 sur Zuckerberg. Au lieu de cela, compte tenu de mes intérêts de recherche, je l'ai bombardé d'énoncés offensants pour voir comment il y faisait face. Ses réponses ont toujours été décevantes.

C'est principalement parce que les chercheurs de Meta ont conçu leur système pour éviter de répondre à de telles entrées. Au lieu de cela, il essaie plutôt maladroitement de changer de sujet.

Sa réponse à la même invite raciste que j'ai tapée dans AutoCounterspeech, par exemple, est la faible :"Désolé, je ne sais pas. Que faites-vous pour vous détendre ?" Le racisme effronté reste incontesté et je suis plutôt invité à entamer une conversation agréable sur le yoga ou Netflix.

Préparer l'avenir

Des systèmes comme BlenderBot3 deviennent déjà des composants familiers de nos sociétés numériques. Les maisons du futur très proche seront en grande partie vocales. "Hey Siri, fais couler un bain" remplacera la torsion des robinets, et les enfants auront des assistants vocaux dans leur chambre dès la naissance.

Ces systèmes de dialogue automatisés nous fourniront des informations, nous aideront à faire des plans et nous divertiront lorsque nous nous ennuyons et que nous nous sentons seuls. Mais parce qu'ils seront si omniprésents, nous devons réfléchir maintenant à la manière dont ces systèmes pourraient et devraient répondre au discours de haine.

Le silence et le refus de contester des idéologies discréditées ou des affirmations erronées est une forme de complicité qui peut renforcer les préjugés et préjugés humains. C'est pourquoi mes collègues et moi avons organisé l'année dernière un atelier interdisciplinaire en ligne pour encourager des recherches plus approfondies sur la tâche difficile d'automatiser un contre-discours efficace.

Pour y parvenir, nous devons impliquer des sociologues, des psychologues, des linguistes et des philosophes, ainsi que des techniciens. Ensemble, nous pouvons nous assurer que la prochaine génération de chatbots répondra de manière beaucoup plus éthique et robuste aux entrées toxiques.

En attendant, alors que notre humble prototype AutoCounterspeech est loin d'être parfait (amusez-vous à essayer de le casser), nous avons au moins démontré que les systèmes automatisés peuvent déjà contrer les déclarations offensantes avec quelque chose de plus qu'un simple désengagement et évitement.

Cet article est republié de The Conversation sous une licence Creative Commons. Lire l'article d'origine. Des chercheurs développent une méthode pour empêcher les bots d'utiliser un langage toxique