Crédit :arXiv:2002.08550 [cs.RO]

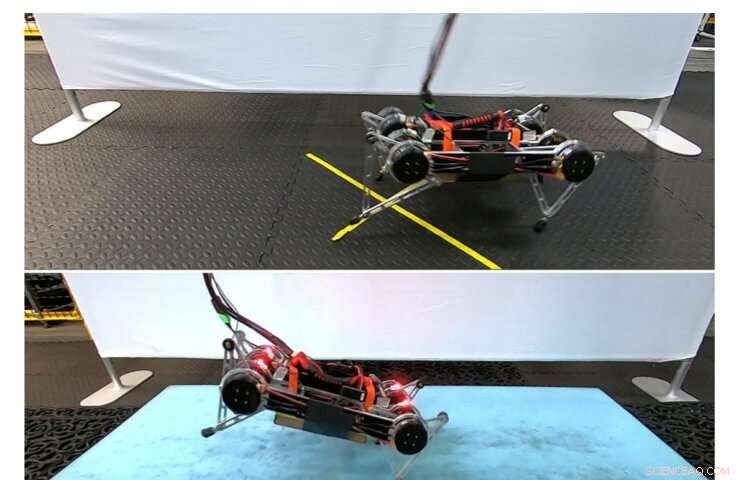

Le domaine de la robotique a fait un pas en avant, suivi d'un autre, puis plusieurs autres, lorsqu'un robot appelé Rainbow Dash a récemment appris tout seul à marcher. La machine à quatre pattes n'a nécessité que quelques heures pour apprendre à marcher d'avant en arrière, et tournez à droite et à gauche en le faisant.

Chercheurs de Google, L'UC Berkeley et le Georgia Institute of Technology ont publié un article sur le serveur de préimpression ArXiv décrivant une technique d'IA statistique connue sous le nom d'apprentissage par renforcement en profondeur qu'ils ont utilisé pour réaliser cet accomplissement, ce qui est important pour plusieurs raisons.

La plupart des déploiements d'apprentissage par renforcement ont lieu dans des environnements simulés par ordinateur. Tiret arc-en-ciel, cependant, utilisé cette technologie pour apprendre à marcher dans un environnement physique réel.

De plus, il a pu le faire sans dispositif pédagogique dédié, tels que des instructeurs humains ou des données de formation étiquetées. Finalement, Rainbow Dash a réussi à marcher sur plusieurs surfaces, comprenant un matelas en mousse souple et un paillasson avec des évidements assez notables.

Les techniques d'apprentissage par renforcement en profondeur utilisées par le robot comprennent un type d'apprentissage automatique dans lequel un agent interagit avec un environnement pour apprendre par essais et erreurs. La plupart des cas d'utilisation de l'apprentissage par renforcement impliquent des jeux informatisés dans lesquels les agents numériques apprennent à jouer pour gagner.

Cette forme d'apprentissage automatique est nettement différente de l'apprentissage traditionnel supervisé ou non supervisé, dans lequel les modèles d'apprentissage automatique nécessitent des données d'entraînement étiquetées pour apprendre. L'apprentissage par renforcement profond combine des approches d'apprentissage par renforcement avec un apprentissage profond, dans lequel l'échelle de l'apprentissage automatique traditionnel est considérablement élargie avec une puissance de calcul massive.

Bien que l'équipe de recherche ait attribué à Rainbow Dash le mérite d'avoir appris à marcher tout seul, l'intervention humaine jouait encore un rôle important dans la réalisation de cet objectif. Les chercheurs ont dû créer des limites à l'intérieur desquelles le robot a appris à marcher afin de l'empêcher de quitter la zone.

Ils ont également dû concevoir des algorithmes spécifiques pour empêcher le robot de tomber, dont certains se sont concentrés sur la contrainte du mouvement du robot. Pour éviter les accidents tels que les chutes, l'apprentissage par renforcement de la robotique a généralement lieu dans un environnement numérique avant que les algorithmes ne soient transférés à un robot physique afin de préserver sa sécurité.

Le triomphe de Rainbow Dash a lieu environ un an après que les chercheurs aient initialement compris comment amener les robots à apprendre en physique, contrairement au virtuel, alentours.

Chelsea Finn, un professeur assistant de Stanford associé à Google qui n'a pas participé à la recherche, dit, "Sortir la personne du processus [d'apprentissage] est vraiment difficile. En permettant aux robots d'apprendre de manière plus autonome, les robots sont plus près de pouvoir apprendre dans le monde réel dans lequel nous vivons."

© 2020 Réseau Science X