Un robot et un humain en interaction. Crédits :Tommy Ton, tontommy.com, CC BY-ND

L'intelligence artificielle entre dans nos vies de plusieurs manières :sur nos smartphones, dans nos maisons, dans nos voitures. Ces systèmes peuvent aider les gens à prendre des rendez-vous, conduire et même diagnostiquer des maladies. Mais alors que les systèmes d'IA continuent de jouer un rôle important et collaboratif dans la vie des gens, une question naturelle est :puis-je leur faire confiance ? Comment puis-je savoir qu'ils feront ce que j'attends ?

L'IA explicable (XAI) est une branche de la recherche sur l'IA qui examine comment les agents artificiels peuvent être rendus plus transparents et dignes de confiance pour leurs utilisateurs humains. La fiabilité est essentielle si les robots et les humains doivent travailler ensemble. XAI cherche à développer des systèmes d'IA que les êtres humains trouvent dignes de confiance, tout en étant performants pour accomplir les tâches conçues.

Au Centre de la Vision, Cognition, Apprentissage, et Autonomie à UCLA, nous et nos collègues sommes intéressés par les facteurs qui rendent les machines plus fiables, et dans quelle mesure différents algorithmes d'apprentissage permettent la confiance. Notre laboratoire utilise un type de représentation des connaissances - un modèle du monde qu'une IA utilise pour interpréter son environnement et prendre des décisions - qui peut être plus facilement compris par les humains. Cela aide naturellement à l'explication et à la transparence, améliorant ainsi la confiance des utilisateurs humains.

Dans nos dernières recherches, nous avons expérimenté différentes manières pour un robot d'expliquer ses actions à un observateur humain. De façon intéressante, les formes d'explication qui favorisaient le plus la confiance humaine ne correspondaient pas aux algorithmes d'apprentissage qui produisaient les meilleures performances de tâche. Cela suggère que les performances et l'explication ne sont pas intrinsèquement dépendantes l'une de l'autre - l'optimisation pour l'un seul peut ne pas conduire au meilleur résultat pour l'autre. Cette divergence nécessite des conceptions de robots qui prennent en compte à la fois de bonnes performances de tâche et des explications fiables.

Robots pédagogiques

En entreprenant cette étude, notre groupe s'intéressait à deux choses. Comment un robot apprend-il le mieux à effectuer une tâche particulière ? Puis, comment les gens réagissent-ils à l'explication de ses actions par le robot ?

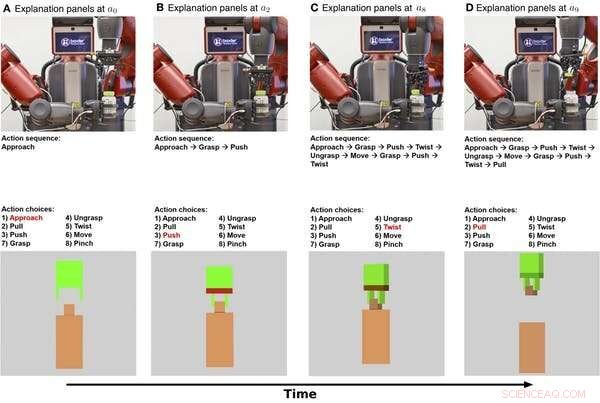

Nous avons appris à un robot à apprendre à partir de démonstrations humaines comment ouvrir un flacon de médicament avec un verrou de sécurité. Une personne portait un gant tactile qui enregistrait les poses et les forces de la main humaine lorsqu'elle ouvrait la bouteille. Cette information a aidé le robot à apprendre ce que l'humain a fait de deux manières :symbolique et haptique. Symbolique fait référence à des représentations significatives de vos actions :par exemple, le mot "saisir". L'haptique fait référence aux sensations associées aux postures et aux mouvements de votre corps :par exemple, la sensation de vos doigts se refermant.

Explications symboliques et haptiques d'un robot ouvrant un flacon de médicament illustrées au fil du temps. La rangée du haut contient des images fixes d'une vidéo du robot effectuant la tâche. La rangée du milieu montre une explication symbolique de la tâche. La rangée du bas montre une explication haptique. Crédit :Edmonds et al., Sci. Robot. 4, eaay4663 (2019)

D'abord, le robot a appris un modèle symbolique qui code la séquence d'étapes nécessaires pour terminer la tâche d'ouverture de la bouteille. Seconde, le robot a appris un modèle haptique qui permet au robot de "s'imaginer" dans le rôle du démonstrateur humain et de prédire quelle action une personne prendrait lorsqu'elle rencontrerait des poses et des forces particulières.

Il s'avère que le robot a pu atteindre ses meilleures performances en combinant les composants symboliques et haptiques. Le robot a mieux fait en utilisant la connaissance des étapes d'exécution de la tâche et la détection en temps réel de sa pince que d'utiliser l'un ou l'autre seul.

Gagner la confiance humaine

Maintenant que le robot sait quoi faire, comment peut-il expliquer son comportement à une personne ? Et dans quelle mesure cette explication favorise-t-elle la confiance humaine ?

Pour expliquer ses actions, le robot peut s'appuyer sur son processus de décision interne ainsi que sur son comportement. Le modèle symbolique fournit des descriptions étape par étape des actions du robot, et le modèle haptique donne une idée de ce que le robot préhenseur « ressent ».

Dans notre expérience, nous avons ajouté une explication supplémentaire pour les humains :un texte qui fournit un résumé une fois que le robot a fini d'essayer d'ouvrir le flacon de médicament. Nous voulions voir si les descriptions sommaires seraient aussi efficaces que l'explication symbolique étape par étape pour gagner la confiance humaine.

Nous avons demandé à 150 participants humains, divisé en quatre groupes, pour observer le robot essayant d'ouvrir le flacon de médicament. Le robot a ensuite donné à chaque groupe une explication différente de la tâche :symbolique, pas à pas, haptique—positions et mouvements des bras, résumé du texte, ou symbolique et haptique ensemble. Un groupe de référence n'a observé qu'une vidéo du robot essayant d'ouvrir la bouteille, sans fournir d'explications supplémentaires.

Nous avons constaté que fournir à la fois les explications symboliques et haptiques favorisait le plus la confiance, la composante symbolique y contribuant le plus. De façon intéressante, l'explication sous forme de résumé textuel n'a pas suscité plus de confiance que le simple fait de regarder le robot effectuer la tâche, indiquant que les humains préfèrent que les robots donnent des explications étape par étape de ce qu'ils font.

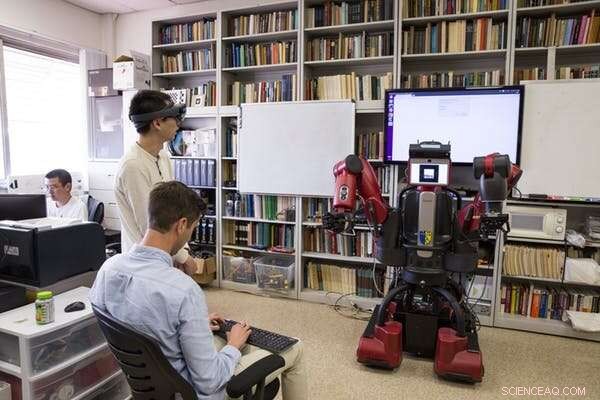

Des chercheurs de l'UCLA testent un robot après avoir appris à ouvrir un flacon de médicament en observant des manifestants humains. Crédit:UCLA Samueli School of Engineering, CC BY-ND

Concevoir pour la performance et la confiance

Le résultat le plus intéressant de cette recherche est que ce qui fait que les robots fonctionnent bien n'est pas la même chose que ce qui fait que les gens les considèrent comme dignes de confiance. Le robot avait besoin à la fois des composants symboliques et haptiques pour faire le meilleur travail. Mais c'est l'explication symbolique qui a le plus poussé les gens à faire confiance au robot.

Cette divergence met en évidence des objectifs importants pour les futures recherches en IA et en robotique :se concentrer sur la poursuite à la fois de la performance des tâches et de l'explicabilité. Se concentrer uniquement sur la performance des tâches peut ne pas conduire à un robot qui s'explique bien. Notre laboratoire utilise un modèle hybride pour fournir des explications à la fois performantes et fiables.

Performance et explication ne se complètent pas naturellement, les deux objectifs doivent donc être une priorité dès le départ lors de la création de systèmes d'IA. Ce travail représente une étape importante dans l'étude systématique de l'évolution des relations homme-machine, Mais il reste encore beaucoup à faire. Une étape difficile pour les recherches futures sera de passer de « Je fais confiance au robot pour faire X » à « Je fais confiance au robot ».

Pour que les robots gagnent une place dans la vie quotidienne des gens, les humains doivent faire confiance à leurs homologues robotiques. Comprendre comment les robots peuvent fournir des explications qui renforcent la confiance humaine est une étape importante pour permettre aux humains et aux robots de travailler ensemble.

Cet article est republié à partir de The Conversation sous une licence Creative Commons. Lire l'article original.