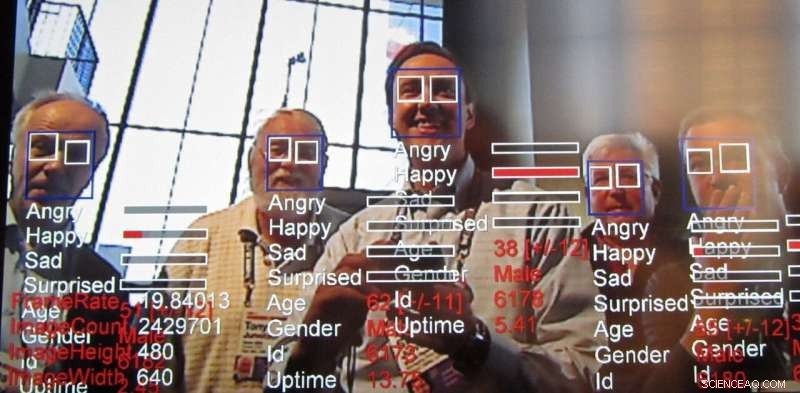

Technologie de reconnaissance des émotions, une excroissance de la technologie de reconnaissance faciale, continue d'avancer rapidement. Crédit :Steve Jurvetson/flickr, CC BY-SA

Dans son rapport annuel, l'Institut AI Now, un centre de recherche interdisciplinaire étudiant les implications sociétales de l'intelligence artificielle, a appelé à l'interdiction de la technologie conçue pour reconnaître les émotions des gens dans certains cas. Spécifiquement, les chercheurs ont déclaré affecter la technologie de reconnaissance, également appelée technologie de reconnaissance des émotions, ne doit pas être utilisé dans des décisions qui « ont un impact sur la vie des gens et sur l'accès aux opportunités, " comme les décisions d'embauche ou les évaluations de la douleur, car il n'est pas suffisamment précis et peut conduire à des décisions biaisées.

Quelle est cette technologie, déjà utilisé et commercialisé, et pourquoi soulève-t-il des inquiétudes ?

Excroissance de la reconnaissance faciale

Les chercheurs ont travaillé activement sur des algorithmes de vision par ordinateur qui peuvent déterminer les émotions et l'intention des humains, en plus de faire d'autres déductions, pendant au moins une décennie. L'analyse des expressions faciales existe depuis au moins 2003. Les ordinateurs ont été capables de comprendre les émotions encore plus longtemps. Cette dernière technologie s'appuie sur les techniques centrées sur les données connues sous le nom de "machine learning, " des algorithmes qui traitent les données pour " apprendre " à prendre des décisions, pour accomplir une reconnaissance d'affect encore plus précise.

Le défi de la lecture des émotions

Les chercheurs cherchent toujours à faire de nouvelles choses en s'appuyant sur ce qui a été fait auparavant. La reconnaissance des émotions est séduisante car, en quelque sorte, nous, les humains, pouvons accomplir cela relativement bien dès le plus jeune âge, et pourtant, reproduire efficacement cette compétence humaine à l'aide de la vision par ordinateur est toujours un défi. Bien qu'il soit possible de faire des choses assez remarquables avec des images, comme styliser une photo pour lui donner l'impression qu'elle a été dessinée par un artiste célèbre et même créer des visages photo-réalistes - sans parler de ce que l'on appelle des deepfakes - la capacité d'inférer des propriétés telles que les émotions humaines à partir d'une image réelle a toujours intéresser les chercheurs.

Les émotions sont difficiles car elles ont tendance à dépendre du contexte. Par exemple, quand quelqu'un se concentre sur quelque chose, il peut sembler qu'il pense simplement. La reconnaissance faciale a parcouru un long chemin grâce à l'apprentissage automatique, mais identifier l'état émotionnel d'une personne en se basant uniquement sur le fait de regarder le visage d'une personne manque d'informations clés. Les émotions s'expriment non seulement à travers l'expression d'une personne, mais aussi là où elle se trouve et ce qu'elle fait. Ces indices contextuels sont difficiles à intégrer, même dans les algorithmes d'apprentissage automatique modernes. Pour remédier à ce, il y a des efforts actifs pour augmenter les techniques d'intelligence artificielle pour tenir compte du contexte, pas seulement pour la reconnaissance des émotions, mais pour toutes sortes d'applications.

Lire les émotions des employés

Le rapport publié par AI Now met en lumière certaines façons dont l'IA est appliquée à la main-d'œuvre afin d'évaluer la productivité des travailleurs et même dès le stade de l'entretien. Analyser les images des interviews, notamment pour les demandeurs d'emploi distants, est déjà en cours. Si les managers peuvent avoir une idée des émotions de leurs subordonnés de l'entretien à l'évaluation, la prise de décision concernant d'autres questions d'emploi telles que les augmentations, les promotions ou les affectations pourraient finir par être influencées par cette information. Mais il existe de nombreuses autres façons d'utiliser cette technologie.

Pourquoi l'inquiétude

Ces types de systèmes sont presque toujours équitables, responsabilité, la transparence et les défauts éthiques (« FATE ») sont intégrés à leur correspondance de motifs. Par exemple, une étude a révélé que les algorithmes de reconnaissance faciale considéraient les visages des Noirs comme plus en colère que les visages blancs, même quand ils souriaient.

De nombreux groupes de recherche s'attaquent à ce problème mais il semble clair à ce stade que le problème ne peut pas être résolu exclusivement au niveau technologique. Les problèmes concernant le FATE dans l'IA nécessiteront un effort continu et concerté de la part de ceux qui utilisent la technologie pour être conscients de ces problèmes et les résoudre. Comme le souligne le rapport AI Now :« Malgré l'augmentation du contenu éthique de l'IA, les principes et déclarations éthiques se concentrent rarement sur la manière dont l'éthique de l'IA peut être mise en œuvre et sur son efficacité. » Il note que de telles déclarations d'éthique de l'IA ignorent largement les questions de comment, où, et qui mettra ces directives en œuvre. En réalité, il est probable que tout le monde doit être conscient des types de biais et de faiblesses que présentent ces systèmes, semblable à la façon dont nous devons être conscients de nos propres préjugés et de ceux des autres.

Le problème des interdictions générales de technologie

Une plus grande précision et facilité dans la surveillance persistante entraînent d'autres préoccupations au-delà de l'éthique. Il existe également une foule de problèmes généraux de confidentialité liés à la technologie, allant de la prolifération des caméras qui servent de sources policières à l'anonymisation potentielle des données sensibles.

Avec ces préoccupations éthiques et de confidentialité, une réaction naturelle pourrait être d'appeler à l'interdiction de ces techniques. Certainement, appliquer l'IA aux résultats des entretiens d'embauche ou aux procédures de condamnation pénale semble dangereux si les systèmes apprennent des préjugés ou ne sont pas fiables. Il existe cependant des applications utiles, par exemple, en aidant à repérer les signes avant-coureurs pour prévenir le suicide des jeunes et détecter les conducteurs ivres. C'est l'une des raisons pour lesquelles même les chercheurs concernés, les régulateurs et les citoyens ont généralement cessé d'appeler à des interdictions générales des technologies liées à l'IA.

Combiner IA et jugement humain

Finalement, les concepteurs de technologies et la société dans son ensemble doivent examiner attentivement la manière dont les informations provenant des systèmes d'IA sont injectées dans les processus de prise de décision. Ces systèmes peuvent donner des résultats incorrects comme n'importe quelle autre forme d'intelligence. Ils sont également notoirement mauvais pour évaluer leur propre confiance, un peu comme les humains, même dans des tâches plus simples comme la capacité de reconnaître des objets. Il reste également des défis techniques importants dans la lecture des émotions, notamment en considérant le contexte pour déduire les émotions.

Si les gens se fient à un système qui n'est pas précis pour prendre des décisions, les utilisateurs de ce système sont moins bien lotis. Il est également bien connu que les humains ont tendance à faire plus confiance à ces systèmes qu'aux autres figures d'autorité. À la lumière de cela, nous, en tant que société, devons examiner attentivement l'équité de ces systèmes, responsabilité, transparence et éthique tant lors de la conception que de l'application, en gardant toujours un humain comme décideur final.

Cet article est republié à partir de The Conversation sous une licence Creative Commons. Lire l'article original.