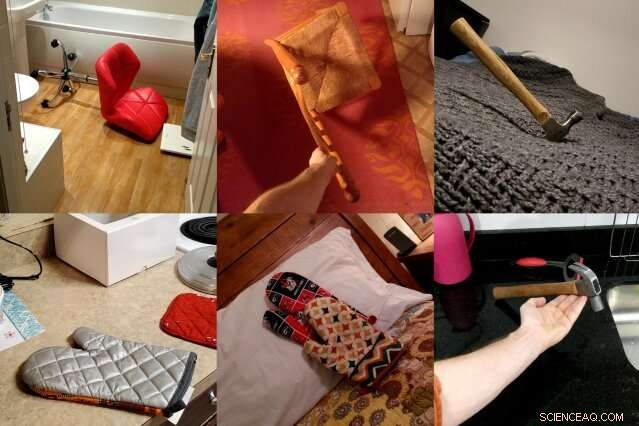

ObjectNet, un jeu de données de photos créé par les chercheurs du MIT et d'IBM, montre des objets sous des angles impairs, dans de multiples orientations, et sur des arrière-plans variés pour mieux représenter la complexité des objets 3D. Les chercheurs espèrent que l'ensemble de données conduira à de nouvelles techniques de vision par ordinateur plus performantes dans la vie réelle. Crédit :Massachusetts Institute of Technology

Les modèles de vision par ordinateur ont appris à identifier les objets sur les photos avec une telle précision que certains peuvent surpasser les humains sur certains ensembles de données. Mais quand ces mêmes détecteurs d'objets sont lâchés dans le monde réel, leurs performances baissent sensiblement, créant des problèmes de fiabilité pour les voitures autonomes et autres systèmes critiques pour la sécurité qui utilisent la vision industrielle.

Afin de combler cet écart de performance, une équipe de chercheurs du MIT et d'IBM a entrepris de créer un type très différent d'ensemble de données de reconnaissance d'objets. Il s'appelle ObjectNet, un jeu sur ImageNet, la base de données participative de photos responsable du lancement d'une grande partie du boom moderne de l'intelligence artificielle.

Contrairement à ImageNet, qui présente des photos prises sur Flickr et d'autres sites de médias sociaux, ObjectNet présente des photos prises par des pigistes rémunérés. Les objets sont représentés inclinés sur le côté, tourné à des angles étranges, et affichés dans des pièces encombrées. Lorsque les principaux modèles de détection d'objets ont été testés sur ObjectNet, leurs taux de précision sont passés d'un maximum de 97 % sur ImageNet à seulement 50 à 55 %.

"Nous avons créé cet ensemble de données pour dire aux gens que le problème de reconnaissance d'objets continue d'être un problème difficile, " dit Boris Katz, chercheur au Laboratoire d'informatique et d'intelligence artificielle (CSAIL) et au Center for Brains du MIT, Esprits et Machines (CBMM). "Nous avons besoin de mieux, algorithmes plus intelligents." Katz et ses collègues présenteront ObjectNet et leurs résultats à la Conférence sur les systèmes de traitement de l'information neuronale (NeurIPS).

L'apprentissage en profondeur, la technique à l'origine d'une grande partie des progrès récents de l'IA, utilise des couches de « neurones » artificiels pour trouver des modèles dans de grandes quantités de données brutes. Il apprend à choisir, dire, la chaise sur une photo après une formation sur des centaines à des milliers d'exemples. Mais même les ensembles de données avec des millions d'images ne peuvent pas montrer chaque objet dans toutes ses orientations et paramètres possibles, créant des problèmes lorsque les modèles rencontrent ces objets dans la vie réelle.

ObjectNet est différent des ensembles de données d'images conventionnels d'une autre manière importante :il ne contient aucune image d'apprentissage. La plupart des ensembles de données sont divisés en données pour entraîner les modèles et tester leurs performances. Mais l'ensemble d'apprentissage partage souvent de subtiles similitudes avec l'ensemble de test, en effet, donnant aux modèles un avant-goût du test.

A première vue, ImageNet, à 14 millions d'images, semble énorme. Mais lorsque son ensemble d'entraînement est exclu, sa taille est comparable à ObjectNet, à 50 ans, 000 photos.

« Si nous voulons savoir dans quelle mesure les algorithmes fonctionneront dans le monde réel, nous devrions les tester sur des images impartiales et qu'ils n'ont jamais vues auparavant, " déclare Andrei Barbu, co-auteur de l'étude, chercheur au CSAIL et au CBMM.

Un ensemble de données qui essaie de capturer la complexité des objets du monde réel

Peu de gens penseraient à partager les photos d'ObjectNet avec leurs amis, et c'est le but. Les chercheurs ont embauché des pigistes d'Amazon Mechanical Turk pour prendre des photos de centaines d'objets ménagers posés au hasard. Les travailleurs ont reçu des missions de photo sur une application, avec des instructions animées leur indiquant comment orienter l'objet assigné, sous quel angle tirer, et s'il faut poser l'objet dans la cuisine, salle de bains, chambre, ou salon.

Ils voulaient éliminer trois biais communs :les objets montrés de face, dans des positions emblématiques, et dans des contextes fortement corrélés, par exemple, assiettes empilées dans la cuisine.

Il a fallu trois ans pour concevoir l'ensemble de données et concevoir une application qui normaliserait le processus de collecte de données. « Découvrir comment collecter des données de manière à contrôler divers biais était incroyablement délicat, " déclare le co-auteur de l'étude David Mayo, un étudiant diplômé du département de génie électrique et informatique du MIT. "Nous avons également dû mener des expériences pour nous assurer que nos instructions étaient claires et que les travailleurs savaient exactement ce qu'on leur demandait."

Il a fallu une autre année pour recueillir les données réelles, et à la fin, la moitié de toutes les photos soumises par les pigistes ont dû être rejetées car elles ne répondaient pas aux spécifications des chercheurs. Dans une tentative d'être utile, certains ouvriers ont ajouté des étiquettes à leurs objets, les a mis en scène sur des fonds blancs, ou essayé d'améliorer l'esthétique des photos qu'ils ont été chargés de prendre.

La plupart des photos ont été prises en dehors des États-Unis, Et ainsi, certains objets peuvent sembler inconnus. Les oranges mûres sont vertes, les bananes sont de tailles différentes, et les vêtements apparaissent dans une variété de formes et de textures.

Object Net vs ImageNet :comment se comparent les principaux modèles de reconnaissance d'objets

Lorsque les chercheurs ont testé des modèles de vision par ordinateur de pointe sur ObjectNet, ils ont constaté une baisse des performances de 40 à 45 points de pourcentage d'ImageNet. Les résultats montrent que les détecteurs d'objets ont encore du mal à comprendre que les objets sont tridimensionnels et peuvent être tournés et déplacés dans de nouveaux contextes, disent les chercheurs. "Ces notions ne sont pas intégrées dans l'architecture des détecteurs d'objets modernes, " déclare le co-auteur de l'étude Dan Gutfreund, un chercheur chez IBM.

Pour montrer qu'ObjectNet est difficile précisément à cause de la façon dont les objets sont visualisés et positionnés, les chercheurs ont permis aux modèles de s'entraîner sur la moitié des données ObjectNet avant de les tester sur la moitié restante. L'entraînement et les tests sur le même ensemble de données améliorent généralement les performances, mais ici les modèles ne se sont que légèrement améliorés, suggérant que les détecteurs d'objets n'ont pas encore pleinement compris comment les objets existent dans le monde réel.

Les modèles de vision par ordinateur se sont progressivement améliorés depuis 2012, lorsqu'un détecteur d'objets appelé AlexNet a écrasé la compétition lors du concours annuel ImageNet. Au fur et à mesure que les ensembles de données sont devenus plus gros, les performances se sont également améliorées.

Mais en concevant des versions plus grandes d'ObjectNet, avec ses angles de vision et ses orientations supplémentaires, ne mènera pas nécessairement à de meilleurs résultats, avertissent les chercheurs. L'objectif d'ObjectNet est de motiver les chercheurs à proposer la prochaine vague de techniques révolutionnaires, tout comme le lancement initial du défi ImageNet.

"Les gens alimentent ces détecteurs d'énormes quantités de données, mais il y a des rendements décroissants, " dit Katz. " Vous ne pouvez pas voir un objet sous tous les angles et dans tous les contextes. Notre espoir est que ce nouvel ensemble de données se traduira par une vision par ordinateur robuste sans échecs surprenants dans le monde réel."

Cette histoire est republiée avec l'aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l'actualité de la recherche du MIT, innovation et enseignement.