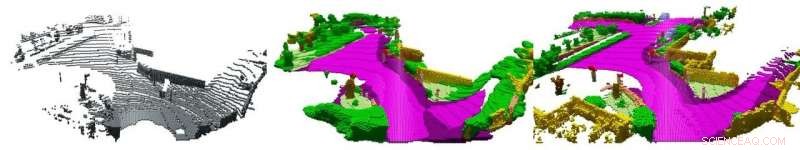

Balayage LiDAR unique (à gauche), les données superposées (à droite) avec les descriptions (couleurs) fournies par un observateur humain et le résultat du logiciel (au centre). Crédit :AG Computer Vision der Universität Bonn

Les bons conducteurs anticipent les situations dangereuses et adaptent leur conduite avant que les choses ne deviennent risquées. Les chercheurs de l'Université de Bonn souhaitent désormais également enseigner cette compétence aux voitures autonomes. Ils présenteront un algorithme correspondant à la Conférence internationale sur la vision par ordinateur qui se tiendra le vendredi, 1er novembre, à Séoul. Ils présenteront également un ensemble de données qu'ils ont utilisé pour former et tester leur approche. Il sera beaucoup plus facile de développer et d'améliorer de tels processus à l'avenir.

Une rue vide, une rangée de voitures garées sur le côté :rien n'indique qu'il faille faire attention. Mais attendez :n'y a-t-il pas une rue latérale devant vous, à moitié couvert par les voitures en stationnement ? Peut-être que je ferais mieux de retirer mon pied de l'accélérateur – qui sait si quelqu'un vient de côté. Nous rencontrons constamment des situations comme celles-ci lorsque nous conduisons. Les interpréter correctement et tirer les bonnes conclusions demande beaucoup d'expérience. En revanche, les voitures autonomes se comportent parfois comme un apprenti conducteur lors de sa première leçon. "Notre objectif est de leur apprendre un style de conduite plus anticipatif, " explique Prof. Dr. Jürgen Gall, informaticien. " Cela leur permettrait alors de réagir beaucoup plus rapidement aux situations dangereuses. "

Gall préside le groupe de travail "Computer Vision" à l'Université de Bonn, lequel, en coopération avec ses collègues universitaires de l'Institut de photogrammétrie et du groupe de travail "Systèmes intelligents autonomes", recherche une solution à ce problème. Les scientifiques présentent maintenant une première étape sur la voie de cet objectif lors du principal symposium de la discipline de Gall, la Conférence internationale sur la vision par ordinateur à Séoul. "Nous avons affiné un algorithme qui complète et interprète les données dites LiDAR, " explique-t-il. " Cela permet à la voiture d'anticiper les dangers potentiels à un stade précoce. "

Problème :trop peu de données

Le LiDAR est un laser rotatif monté sur le toit de la plupart des voitures autonomes. Le faisceau laser est réfléchi par l'environnement. Le système LiDAR mesure quand la lumière réfléchie tombe sur le capteur et utilise ce temps pour calculer la distance. "Le système détecte la distance à environ 120, 000 points autour du véhicule par tour, " dit Gall.

Le problème avec ceci :les points de mesure deviennent "dilués" à mesure que la distance augmente - l'écart entre eux s'élargit. C'est comme peindre un visage sur un ballon :lorsque vous le gonflez, les yeux s'éloignent de plus en plus. Même pour un être humain, il est donc presque impossible d'obtenir une compréhension correcte de l'environnement à partir d'un seul scan LiDAR (c'est-à-dire les mesures de distance d'un seul tour). "Il y a quelques années, l'Université de Karlsruhe (KIT) a enregistré de grandes quantités de données LiDAR, un total de 43, 000 numérisations, " explique le Dr Jens Behley de l'Institut de photogrammétrie. " Nous avons maintenant pris des séquences de plusieurs dizaines de scans et les avons superposées. " Les données ainsi obtenues contiennent également des points que le capteur n'avait enregistrés que lorsque la voiture avait déjà roulé quelques des dizaines de mètres plus loin sur la route. ils montrent non seulement le présent, mais aussi l'avenir.

"Ces nuages de points superposés contiennent des informations importantes telles que la géométrie de la scène et les dimensions spatiales des objets qu'elle contient, qui ne sont pas disponibles en une seule analyse, " souligne Martin Garbade, qui fait actuellement son doctorat à l'Institut d'informatique. "En outre, nous avons étiqueté chaque point en eux, par exemple :il y a un trottoir, il y a un piéton et derrière il y a un motocycliste." Les scientifiques ont alimenté leur logiciel avec une paire de données :un seul scan LiDAR en entrée et les données de superposition associées, y compris des informations sémantiques en sortie souhaitée. Ils ont répété ce processus pour plusieurs milliers de ces paires.

« Au cours de cette phase de formation, l'algorithme appris pour compléter et interpréter les analyses individuelles, " explique le professeur Gall. " Cela signifiait qu'il pouvait vraisemblablement ajouter des mesures manquantes et interpréter ce qui a été vu dans les scans. " L'achèvement de la scène fonctionne déjà relativement bien :le processus peut compléter correctement environ la moitié des données manquantes. L'interprétation sémantique, c'est-à-dire déduire quels objets sont cachés derrière les points de mesure, ne fonctionne pas aussi bien :Ici, l'ordinateur atteint une précision maximale de 18 pour cent.

Cependant, les scientifiques considèrent que cette branche de la recherche en est encore à ses balbutiements. "Jusqu'à maintenant, il y a simplement eu un manque d'ensembles de données complets avec lesquels former les méthodes d'intelligence artificielle correspondantes, " souligne Gall. " Nous comblons ici une lacune avec notre travail. Je suis optimiste que nous serons en mesure d'augmenter considérablement le taux de précision de l'interprétation sémantique dans les années à venir. ce qui pourrait avoir une énorme influence sur la qualité de la conduite autonome.