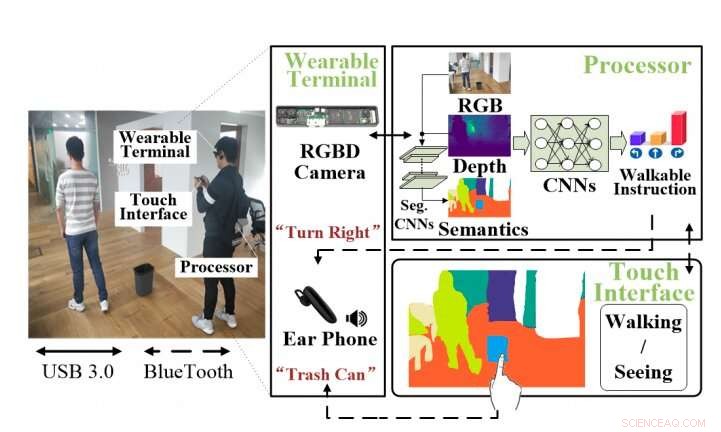

Un aperçu du système d'assistance VI. Le système comprend un terminal portable composé d'une caméra RGBD et d'un écouteur, un processeur et une interface tactile qui offre des instructions accessibles et des descriptions de scènes. Crédit :Lin et al.

Les nouvelles avancées technologiques pourraient avoir des implications importantes pour les personnes handicapées, offrant une aide précieuse tout au long de leur vie quotidienne. Un exemple clé en est l'orientation que les outils technologiques pourraient fournir aux malvoyants (VI), personnes partiellement ou totalement aveugles.

Avec ça en tête, chercheurs de CloudMinds Technologies Inc., en Chine, ont récemment créé un nouveau système d'assistance portable basé sur l'apprentissage en profondeur pour les personnes VI. Ce système, présenté dans un article pré-publié sur arXiv, se compose d'un terminal portable, un processeur puissant et un smartphone. Le terminal portable a deux composants clés, une caméra RGBD et un écouteur.

« Nous présentons un système portable basé sur l'apprentissage en profondeur pour améliorer la qualité de vie du VI, ", ont écrit les chercheurs dans leur article. "Le système est conçu pour une navigation sûre et une perception complète de la scène en temps réel."

Le système développé par l'équipe de CloudMinds collecte essentiellement des données de l'environnement d'un utilisateur via la caméra RGBD. Ces données sont transmises à un réseau de neurones convolutifs (CNN) qui les analyse et prédit les stratégies d'évitement et de navigation les plus efficaces. Ces stratégies, ainsi que d'autres informations sur l'environnement environnant, sont alors communiquées à l'utilisateur via un écouteur.

Lors de la construction de ce système, les premiers chercheurs ont développé un système basé sur les données, réseau convolutif (CNN) de bout en bout pouvant générer des instructions sans collision au fur et à mesure que l'utilisateur avance, la gauche, ou et à droite sur la base des données RGBD et des cartes sémantiques associées. En outre, ils ont conçu une série d'interactions faciles à adopter pour les individus VI, afin de leur fournir un retour fiable, comme des instructions de marche pour éviter les obstacles et des informations sur leur environnement environnant.

"Notre moteur d'évitement d'obstacles, qui apprend de RGBD, carte sémantique et saisie des choix d'action des pilotes, est capable de fournir des informations sûres sur les obstacles et l'espace libre entourant le VI. En utilisant la carte sémantique, nous introduisons également un schéma d'interaction efficace mis en œuvre pour aider le VI à percevoir les environnements 3D via un smartphone."

Les chercheurs ont testé les performances de leur système dans une série d'expériences d'évitement d'obstacles dans le monde réel. Remarquablement, leur système a surpassé les approches existantes dans plusieurs scénarios intérieurs et extérieurs. Les résultats qu'ils ont recueillis au cours de ces tests suggèrent que le système améliore également les performances de mobilité des utilisateurs et les capacités de perception de l'environnement dans les tâches du monde réel, par exemple, les aider à comprendre l'agencement d'une pièce donnée, les aider à retrouver un objet perdu, ou véhiculant les conditions de circulation à proximité.

Dans le cadre de leur étude, les chercheurs ont collecté des ensembles de données d'épisodes d'évitement d'obstacles qui contiennent à la fois des instructions pour éviter les obstacles à proximité tout en marchant et d'autres informations pour percevoir les environnements 3D environnants. Ces ensembles de données pourraient aider les équipes de recherche à former d'autres outils basés sur l'apprentissage en profondeur pour les individus VI.

À l'avenir, le nouveau système portable développé dans cette étude pourrait fournir une assistance plus efficace et plus approfondie aux personnes VI. L'équipe prévoit maintenant d'intégrer un sonar ou un capteur de choc qui améliorerait la sécurité des utilisateurs lorsqu'ils naviguent dans des environnements plus difficiles ou dangereux.

© 2019 Réseau Science X