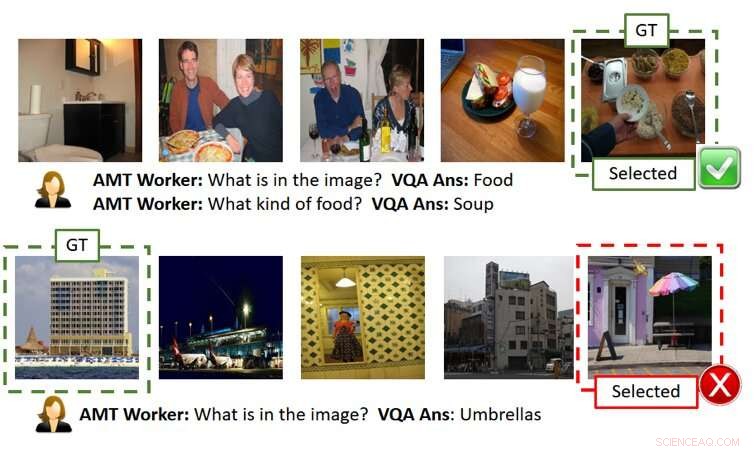

La figure ci-dessus montre deux parties de jeu sans explication (chaque ligne est un exemple de partie). Comme indiqué dans la rangée du haut, l'utilisateur (c'est-à-dire AMT Worker depuis que nous avons utilisé Amazon Mechanical Turk pour une évaluation à grande échelle basée sur la foule) est capable de comprendre correctement l'image secrète à partir de réponses précises de l'IA. Cependant, comme indiqué dans la rangée du bas, l'utilisateur peut échouer même lorsque les réponses de l'IA sont raisonnables mais légèrement erronées (c'est-à-dire, il y a une structure en forme de parapluie à côté du bâtiment bien qu'elle ne soit pas au centre de l'image de la vérité sur le terrain). GT signifie Ground Truth (c'est-à-dire l'image secrète), L'image sélectionnée est l'image sélectionnée par l'utilisateur après avoir posé les questions et obtenu les réponses et/ou les explications. Crédit :Ray et al.

Dans les années récentes, les chercheurs ont essayé de rendre l'intelligence artificielle (IA) plus transparente en développant des algorithmes qui peuvent expliquer leurs actions et leur comportement, car cela pourrait encourager une plus grande confiance dans les machines et améliorer les interactions homme-IA. Malgré leurs efforts, Jusqu'à présent, très peu d'études ont évalué de manière tangible l'impact des explications de l'IA sur les performances obtenues dans les tâches impliquant une collaboration homme-IA.

Pour combler cette lacune dans la littérature existante, une équipe de chercheurs de SRI International a créé un jeu de devinettes d'images humaines-IA inspiré du jeu populaire 20 Questions (20Q), qui peut être utilisé pour évaluer l'utilité des explications de la machine. Leur papier, récemment publié sur arXiv, est parmi les premiers à explorer les effets du développement d'une IA plus «explicable».

"L'idée est venue alors que nous travaillions sur un projet DARPA, " Arijit Ray, un informaticien de SRI International qui a réalisé l'étude, a dit TechXolore. "Dans ce projet, nous développons des systèmes d'IA explicables, qui génèrent non seulement la sortie souhaitée (par exemple, détection d'objet, réponses aux questions, etc.) mais aussi des explications sur la façon dont ils sont arrivés à cette sortie. Nous avions besoin d'un mécanisme pour évaluer si les explications supplémentaires fournies par les IA étaient utiles à l'utilisateur pour mieux comprendre les systèmes d'IA. À cette fin, nous avons créé une tâche collaborative homme-IA interactive, GuessWhich assisté par explication (ExAG), qui est une adaptation du célèbre jeu 20Q, pour démontrer l'efficacité des différentes techniques d'explication machine que nous développons."

Le jeu de devinettes d'images développé par Ray et ses collègues ressemble beaucoup au jeu populaire 20 Questions, qui implique généralement deux joueurs. En 20Q, un joueur pense à quelque chose et le deuxième joueur essaie de deviner ce que c'est en posant 20 questions fermées (c'est-à-dire, questions auxquelles on ne peut répondre que par « oui » ou « non »).

Dans ExAG, l'adaptation du jeu imaginé par Ray et ses collègues, un utilisateur voit cinq images, dont l'un a été choisi par le système d'IA comme « image secrète ». Essentiellement, l'utilisateur doit déterminer laquelle parmi les images qu'il a vues est « l'image secrète ; ' en posant des questions en langage naturel à ce sujet.

Contrairement au jeu traditionnel 20Q, dans ExAG, les utilisateurs humains peuvent poser des questions fermées et ouvertes. Par exemple, ils pourraient demander 'qu'est-ce qu'il y a dans l'image ?, « Où a été prise l'image ? » etc. Le système d'IA répond aux questions d'un utilisateur une par une et peut éventuellement expliquer ses réponses.

Sur la base de ces réponses, l'utilisateur essaiera alors de deviner l'image que l'IA avait initialement sélectionnée. Le but général du jeu est d'identifier correctement « l'image secrète » en posant le moins de questions possible.

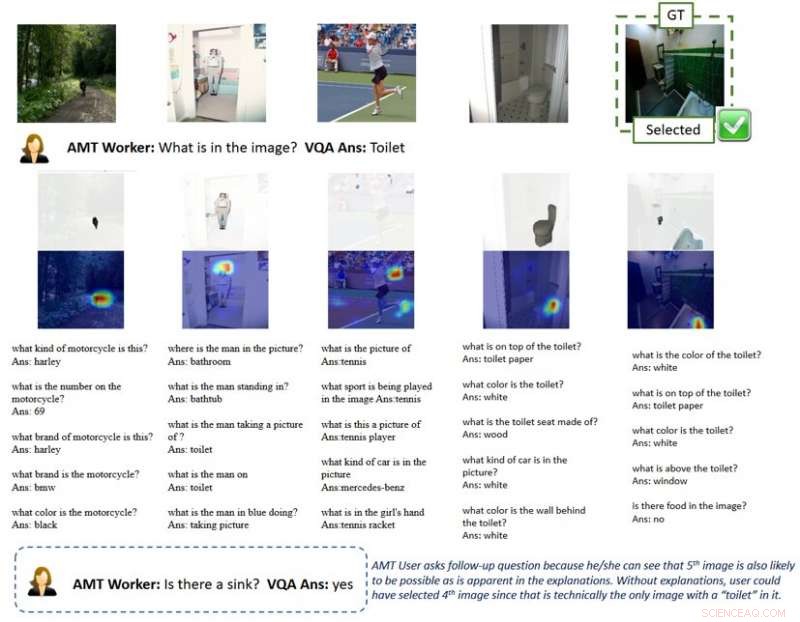

"Le système d'IA fournit deux modes d'explications, visuel et textuel, " expliqua Ray. " Pour des explications visuelles, le système d'IA génère des cartes thermiques mettant en évidence les régions qui soutiennent ses réponses. Par exemple, si un utilisateur demande ce qu'il y a dans l'image, et on dirait un chien, l'IA mettra en évidence la région du chien et dira que c'est ce qui conduit à la réponse « c'est un chien ». Pour des explications textuelles, d'autre part, le système d'IA fournit des réponses aux questions connexes pour chacune des images. Donc, si vous demandez ce qu'une personne fait et que la réponse est en train de surfer, par exemple, il répondra également à des questions connexes telles que « qu'est-ce que je vois dans l'image ? Un surfeur.' « Où est prise la photo ? Une plage.'

En raison de la nature du jeu de devinettes d'images, la qualité des réponses et des explications fournies par l'IA peut affecter de manière significative le succès et les performances d'un utilisateur humain. Il convient de noter que les performances de pointe actuelles en matière de réponse visuelle aux questions sont d'environ 65 %, ce qui signifie que le système d'IA génère des réponses correctes 65% du temps.

Ray et ses collègues ont observé que les utilisateurs réussissaient généralement dans ExAG en tirant parti des explications de l'IA, surtout quand les réponses elles-mêmes étaient fausses. Par exemple, si "l'image secrète" représente un chien, mais l'IA répond 'c'est un surfeur, ' une explication visuelle pourrait aider un utilisateur humain à réaliser l'erreur de l'IA. Selon les chercheurs, cela prouve que leur jeu est un outil adapté pour évaluer l'utilité des explications de l'IA.

La figure ci-dessus montre un gameplay avec des explications. L'explication visuelle de la carte thermique met en évidence les régions des images qui mènent aux réponses de l'IA. Avec une telle explication, les utilisateurs comprennent que les systèmes d'IA peuvent capter des objets qui ne sont pas l'objet principal de l'image du point de vue humain lorsqu'ils répondent à une question générale comme « qu'est-ce qu'il y a dans l'image ». Cela incite l'utilisateur à poser des questions de suivi et enfin à sélectionner correctement l'image secrète. GT signifie Ground Truth (c'est-à-dire l'image secrète), L'image sélectionnée est l'image sélectionnée par l'utilisateur après avoir posé les questions et obtenu les réponses et/ou les explications. Crédit :Ray et al.

"À mon avis, le résultat le plus intéressant de notre étude est que les utilisateurs peuvent utiliser quelques bonnes explications pour gagner des jeux lorsque les réponses de l'IA sont pour la plupart fausses, " dit Ray. " En revanche, pour les jeux avec une précision de réponse similaire mais sans explications, les utilisateurs font aveuglément confiance aux réponses générées par l'IA et perdent la partie. Cela confirme l'importance de quelques bonnes explications pour un système collaboratif homme-IA, surtout lorsque le système d'IA est imparfait, ce qui est le cas dans la plupart des cas de nos jours."

Pour mieux expliquer cette idée, Ray donne l'exemple des véhicules autonomes. Au cours des dernières années, il y a eu beaucoup de débats sur leur sécurité, également en raison d'accidents survenus pendant les essais des véhicules. Selon Ray, des explications efficaces de l'IA pourraient encourager une plus grande confiance dans la sécurité des véhicules autonomes, car ils permettraient aux conducteurs humains d'identifier les problèmes à l'avance et de prévenir les accidents.

"Par exemple, supposons que le système d'IA éprouve des difficultés à détecter les voies de manière fiable, " Dit Ray. " Puisque la route est actuellement droite, sans informations supplémentaires, l'utilisateur serait incapable de dire si l'IA échoue. Même s'il/elle avait des doutes, il ne ferait probablement rien jusqu'au dernier moment, quand la voiture doit faire demi-tour, pas, et s'écrase, ce qui serait trop tard. En revanche, si un écran dans la voiture montrait des explications sur la façon dont l'IA perçoit l'environnement, comme les cartes thermiques, l'utilisateur serait en mesure de détecter la défaillance latente de l'IA et de prendre le contrôle de la roue à l'avance."

Les chercheurs ont découvert que des explications utiles affectaient positivement les performances des utilisateurs humains dans le jeu de devinette d'images. Leurs résultats suggèrent qu'avoir au moins une explication « correcte » était significativement utile, en particulier dans les cas où les réponses de l'IA aux questions des utilisateurs étaient « bruyantes » ou mal définies. De façon intéressante, les joueurs ont développé une préférence pour les explications par rapport aux réponses et ont souvent évalué les explications de l'IA comme « utiles ».

"Je pense que même si plusieurs lignes de travail ont essayé de fournir des explications sur les résultats ou les actions d'un système d'IA, la nôtre est la première étude à introduire une tâche de collaboration homme-machine pour évaluer l'efficacité des explications de l'IA ; Donc, cela a apporté beaucoup d'informations sur la façon dont les explications de l'IA pourraient améliorer les interactions homme-robot, " Yi Yao, un responsable technique senior de SRI International qui a participé à l'étude, a déclaré TechXplore.

L'étude menée par Ray et ses collègues est l'une des premières à fournir des preuves tangibles de l'utilité des explications de l'IA. Les chercheurs espèrent que leurs recherches éclaireront à terme le développement de systèmes d'IA capables d'agir de manière rationnelle dans la société, ainsi se connecter et se rapporter mieux avec les humains.

Selon Ray, Des systèmes d'IA capables d'expliquer clairement le raisonnement et les processus derrière leurs actions constitueraient un pas en avant significatif dans le développement de machines intelligentes. En répondant efficacement aux questions et en rationalisant leurs décisions, ces systèmes pourraient favoriser un plus grand sentiment de confiance dans l'IA, ainsi qu'une relation plus profonde avec elle.

"Beaucoup d'autres entreprises, des groupes et des groupes de recherche se sont penchés sur l'IA explicable, et il y a eu de nombreuses propositions sur la façon d'étendre les modèles et systèmes d'IA existants pour fournir des explications aux utilisateurs, " dit Giedrius Burachas, informaticien senior chez SRI International et chercheur principal à l'origine de l'étude DARPA qui a conduit au développement du jeu Guess Which. « Bien qu'il y ait eu beaucoup d'idées générées, la preuve que ces idées fonctionnent manquait, donc l'un des points forts de notre recherche est qu'elle fournit des preuves indiscutables que certains types d'explications sont vraiment très efficaces pour améliorer la collaboration avec les systèmes d'IA, mais aussi pour instaurer la confiance en eux."

Jusqu'à maintenant, le travail de Ray et de ses collègues s'est principalement concentré sur les tâches de réponse visuelle aux questions (VQA), où les utilisateurs posent des questions sur les images et une IA répond. Ils envisagent maintenant de poursuivre leurs recherches sur les techniques d'explication de l'IA, appliquer ces techniques à un plus large éventail de tâches d'IA.

« Nous continuerons également à développer des protocoles pour évaluer l'efficacité des explications générées par l'IA avec une granularité plus fine (par exemple, quelle explication est la plus efficace dans quels scénarios ?) et sous différents angles (par exemple, les explications aident-elles les utilisateurs à construire le modèle mental ?), " Ray a dit. " Pour boucler la boucle, nous utiliserons les enseignements tirés de ces évaluations pour développer des méthodes d'explication plus efficaces. Nous pensons que le Saint Graal de l'IA explicable est de concevoir des explications qui non seulement informent les utilisateurs, mais améliorent également les performances de la machine en améliorant sa capacité de raisonnement."

En plus d'explorer les effets des explications de l'IA sur les performances et les perceptions des utilisateurs humains, donc, les chercheurs aimeraient étudier leur impact sur les systèmes d'IA eux-mêmes. Ils pensent que les explications de l'IA pourraient également améliorer les systèmes d'IA par nature, car ils acquerraient progressivement des capacités de raisonnement et de rationalisation.

© 2019 Réseau Science X