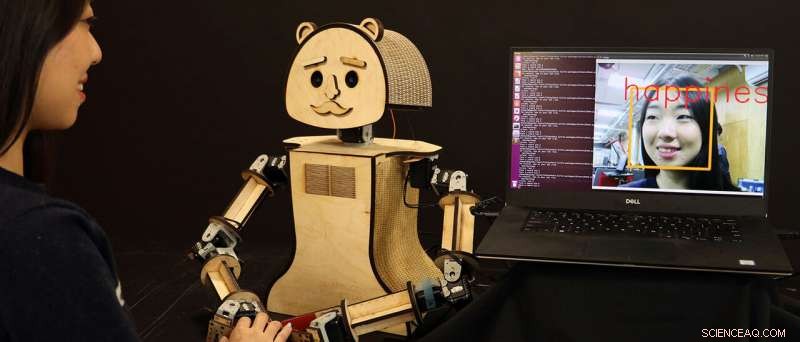

"Boisé, " un robot social low-cost, lit les émotions sur le visage de l'humain, basé sur les algorithmes développés par la chercheuse Kiju Lee et son équipe de la Case Western Reserve University. Crédit:Case Western Reserve University

Les robots deviennent de plus en plus intelligents - et plus rapides - pour savoir ce que les humains ressentent et pensent simplement en "regardant" leurs visages, un développement qui pourrait un jour permettre à des machines plus perceptives émotionnellement de détecter les changements dans la santé ou l'état mental d'une personne.

Des chercheurs de la Case Western Reserve University affirment qu'ils améliorent l'intelligence artificielle (IA) qui alimente désormais les jeux vidéo interactifs et qui améliorera bientôt la prochaine génération de robots personnalisés susceptibles de coexister avec les humains.

Et les robots Case Western Reserve le font en temps réel.

De nouvelles machines développées par Kiju Lee, le Nord Distinguished Assistant Professor en génie mécanique et aérospatial à la Case School of Engineering, et étudiant diplômé Xiao Liu, identifient correctement les émotions humaines à partir des expressions faciales 98% du temps, presque instantanément. Les résultats précédents d'autres chercheurs avaient obtenu des résultats similaires, mais les robots répondaient souvent trop lentement.

"Même une pause de trois secondes peut être gênante, " Lee a déclaré. "Il est déjà assez difficile pour les humains - et encore plus difficile pour les robots - de comprendre ce que ressent une personne en se basant uniquement sur ses expressions faciales ou son langage corporel. « Toutes les couches et les couches de technologie, y compris la capture vidéo, ralentissent également malheureusement la réponse. »

Lee et Liu ont accéléré le temps de réponse en combinant deux filtres vidéo de prétraitement à une autre paire de programmes existants pour aider le robot à classer les émotions sur la base de plus de 3, 500 variations dans l'expression du visage humain.

Mais ce n'est guère l'étendue de notre variation faciale :les humains peuvent enregistrer plus de 10, 000 expressions, et chacun a également une façon unique de révéler bon nombre de ces émotions, dit Lee.

Mais les ordinateurs "d'apprentissage en profondeur" peuvent traiter de grandes quantités d'informations une fois que ces données sont entrées dans le logiciel et classées.

Et, heureusement, les traits expressifs les plus courants chez les humains sont facilement divisés en sept émotions :neutre, joie, colère, tristesse, dégoûter, la surprise et la peur, même en tenant compte des variations entre les différentes origines et cultures.

Applications actuelles et futures

Ce travail récent de Lee et Liu, dévoilé aux Jeux IEEE 2018, Divertissement, et conférence de presse, pourrait conduire à une multitude d'applications lorsqu'elles sont combinées aux avancées de dizaines d'autres chercheurs dans le domaine de l'IA, dit Lee.

Les deux travaillent également maintenant sur une autre approche basée sur l'apprentissage automatique pour la reconnaissance des émotions faciales, qui jusqu'à présent a atteint plus de 99% de précision avec une efficacité de calcul encore plus élevée.

Un jour, un robot personnel peut être capable de remarquer avec précision des changements importants chez une personne grâce à une interaction quotidienne, même au point de détecter les premiers signes de dépression, par exemple.

"Le robot pourrait être programmé pour l'attraper tôt et aider avec des interventions simples, comme la musique et la vidéo, pour les personnes ayant besoin de thérapies sociales, " Lee a déclaré. "Cela pourrait être très utile pour les personnes âgées qui pourraient souffrir de dépression ou de changements de personnalité associés au vieillissement."

Lee envisage d'explorer l'utilisation potentielle des robots sociaux pour l'intervention sociale et émotionnelle chez les personnes âgées en collaboration avec Ohio Living Breckenridge Village. On s'attend à ce que les résidents âgés interagissent avec un robot socialement interactif et aider à tester la précision et la fiabilité des algorithmes intégrés.

Autre possibilité future :un robot social qui apprend les changements faciaux plus subtils chez une personne sur le spectre de l'autisme et qui aide à « enseigner » aux humains à reconnaître avec précision les émotions les uns chez les autres.

"Ces robots sociaux mettront un certain temps à s'attraper aux États-Unis, " dit Lee. " Mais dans des endroits comme le Japon, où il y a une forte culture autour des robots, cela commence déjà à se produire. Dans tous les cas, notre avenir sera côte à côte avec des robots émotionnellement intelligents."