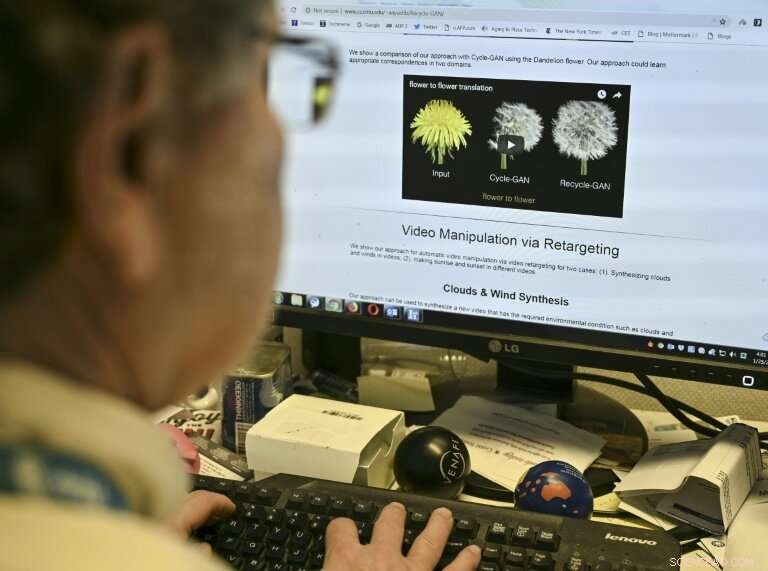

Paul Scharre du Center for a New American Security regarde une vidéo "deepfake" de l'ancien président américain Barack Obama manipulée pour lui montrer les paroles de l'acteur Jordan Peele le 24 janvier. 2019, à Washington

Si vous voyez une vidéo d'un politicien prononçant des mots qu'il ne prononcerait jamais, ou une star d'Hollywood apparaissant de manière improbable dans un film pour adultes bon marché, n'ajustez pas votre téléviseur, vous êtes peut-être en train d'assister à l'avenir des « fausses nouvelles ».

Les vidéos "Deepfake" qui manipulent la réalité deviennent de plus en plus sophistiquées grâce aux avancées de l'intelligence artificielle, créant le potentiel de nouveaux types de désinformation avec des conséquences dévastatrices.

Au fur et à mesure que la technologie avance, les inquiétudes grandissent quant à la façon dont les deepfakes peuvent être utilisés à des fins néfastes par des pirates ou des acteurs étatiques.

"Nous n'en sommes pas tout à fait au stade où nous voyons des deepfakes armés, mais ce moment arrive, " Robert Chesney, un professeur de droit de l'Université du Texas qui a fait des recherches sur le sujet, dit à l'AFP.

Chesney soutient que les deepfakes pourraient ajouter à la tourmente actuelle au sujet des opérations de désinformation et d'influence.

"Un deepfake ou une série de deepfakes bien chronométrés et soigneusement scénarisés pourrait faire basculer une élection, déclencher des violences dans une ville en proie à des troubles civils, renforcer les récits des insurgés sur les atrocités supposées d'un ennemi, ou exacerber les divisions politiques dans une société, ", a déclaré Danielle Citron, professeur à Chesney et à l'Université du Maryland, dans un article de blog pour le Council on Foreign Relations.

Paul Scharre, chercheur principal au Center for a New American Security, un think tank spécialisé sur les questions d'IA et de sécurité, a déclaré qu'il était presque inévitable que des deepfakes soient utilisés lors des prochaines élections.

La manipulation numérique peut être bonne pour Hollywood, mais de nouvelles techniques de "deepfake" pourraient créer un nouveau type de désinformation, selon les chercheurs

Une fausse vidéo pourrait être déployée pour salir un candidat, Scharre a dit, ou pour permettre aux gens de nier des événements réels capturés sur une vidéo authentique.

Avec de fausses vidéos crédibles en circulation, il ajouta, "les gens peuvent choisir de croire n'importe quelle version ou récit qu'ils veulent, et c'est une vraie préoccupation."

Le retour de Chaplin ?

La manipulation vidéo existe depuis des décennies et peut être inoffensive ou même divertissante, comme dans l'apparition assistée numériquement de Peter Cushing dans "Rogue One:A Star Wars Story, en 2016, " 22 ans après sa mort.

L'année dernière, des chercheurs de l'Université Carnegie Mellon ont révélé des techniques qui facilitent la production de deepfakes via l'apprentissage automatique pour déduire les données manquantes.

Dans l'industrie du cinéma, " l'espoir est que nous puissions faire revenir de vieilles stars de cinéma comme Charlie Chaplin, " a déclaré Aayush Bansal.

Les experts disent qu'un moyen important de traiter les deepfakes est de sensibiliser le public, rendre les gens plus sceptiques quant à ce qui était autrefois considéré comme une preuve irréfutable

La vulgarisation d'applications qui produisent de fausses vidéos réalistes menace de saper la notion de vérité dans les médias d'information, les procès pénaux et bien d'autres domaines, soulignent les chercheurs.

"Si nous pouvons mettre des mots dans la bouche de n'importe qui, c'est assez effrayant, " dit Siwei Lyu, professeur d'informatique à l'Université d'État de New York à Albany, qui recherche la détection de deepfake.

"Cela brouille la frontière entre ce qui est vrai et ce qui est faux. Si nous ne pouvons pas vraiment faire confiance aux informations pour qu'elles soient authentiques, ce n'est pas mieux que de n'avoir aucune information du tout."

Le représentant Adam Schiff et deux autres législateurs ont récemment envoyé une lettre au directeur du renseignement national, Dan Coats, demandant des informations sur ce que fait le gouvernement pour lutter contre les deepfakes.

"Vidéos forgées, les images ou le son pourraient être utilisés pour cibler des individus à des fins de chantage ou à d'autres fins malveillantes, ", ont écrit les législateurs.

« Plus soucieux de la sécurité nationale, ils pourraient également être utilisés par des acteurs étrangers ou nationaux pour diffuser de la désinformation. »

Les producteurs de « Rogue One :A Star Wars Story, " Les acteurs recréés numériquement Peter Cushing et Carrie Fisher après leur mort en utilisant des techniques similaires à celles utilisées pour les vidéos "deepfake"

Séparer le faux du réel

Les chercheurs travaillent depuis un certain temps sur de meilleures méthodes de détection, avec le soutien d'entreprises privées telles que Google et d'entités gouvernementales comme la Defense Advanced Research Projects Agency (DARPA) du Pentagone, qui a lancé une initiative de criminalistique des médias en 2015.

Les recherches de Lyu se sont concentrées sur la détection des contrefaçons, en partie en analysant le taux de clignement des yeux d'un individu.

Mais il reconnaît que même détecter les contrefaçons peut ne pas suffire, si une vidéo devient virale et mène au chaos.

"Il est plus important de perturber le processus que d'analyser les vidéos, " dit Lyu.

Alors que les deepfakes évoluent depuis plusieurs années, le sujet s'est focalisé avec la création en avril dernier d'une vidéo semblant montrer l'ancien président Barack Obama utilisant un juron pour décrire son successeur Donald Trump, une cascade coordonnée du cinéaste Jordan Peele et de BuzzFeed.

Un journaliste de l'AFP visionne un exemple de vidéo "deepfake" manipulée grâce à l'intelligence artificielle, par des chercheurs de l'Université Carnegie Mellon

Toujours en 2018, une prolifération de vidéos porno "face swap" qui utilisaient des images d'Emma Watson, Scarlett Johansson et d'autres célébrités ont provoqué l'interdiction des deepfakes par Reddit, Twitter et Pornhub, bien qu'il ne soit pas clair s'ils pourraient appliquer les politiques.

Scharre said there is "an arms race between those who are creating these videos and security researchers who are trying to build effective tools of detection."

But he said an important way to deal with deepfakes is to increase public awareness, making people more skeptical of what used to be considered incontrovertible proof.

"After a video has gone viral it may be too late for the social harm it has caused, " il a dit.

© 2019 AFP