Crédit :CC0 Domaine public

Une nouvelle recherche SFI remet en question une conception populaire de la façon dont les algorithmes d'apprentissage automatique « pensent » à certaines tâches.

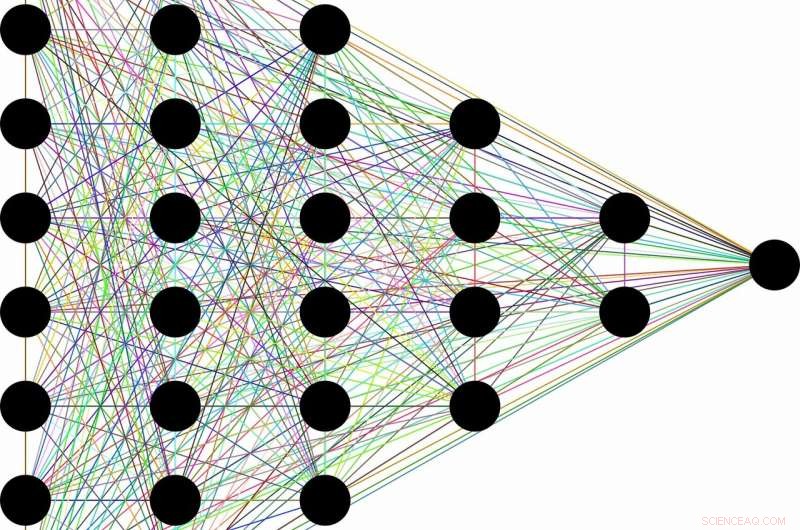

La conception va quelque chose comme ceci :en raison de leur capacité à rejeter les informations inutiles, une classe d'algorithmes d'apprentissage automatique appelés réseaux de neurones profonds peut apprendre des concepts généraux à partir de données brutes, comme l'identification de chats généralement après avoir rencontré des dizaines de milliers d'images de chats différents dans différentes situations. Cette capacité apparemment humaine apparaîtrait comme un sous-produit de l'architecture en couches des réseaux. Les premières couches codent l'étiquette "chat" ainsi que toutes les informations brutes nécessaires à la prédiction. Les couches suivantes compressent ensuite les informations, comme à travers un goulot d'étranglement. Données non pertinentes, comme la couleur du pelage du chat, ou la soucoupe de lait à côté, est oublié, ne laissant que des caractéristiques générales. La théorie de l'information fournit des limites sur l'optimalité de chaque couche, en termes de capacité à équilibrer les demandes concurrentes de compression et de prédiction.

"Souvent, lorsque vous avez un réseau de neurones et qu'il apprend à mapper les visages aux noms, ou des images en chiffres numériques, ou des choses étonnantes comme le texte français vers le texte anglais, il a beaucoup de couches cachées intermédiaires à travers lesquelles les informations circulent, " dit Artemy Kolchinsky, un boursier postdoctoral SFI et l'auteur principal de l'étude. « Il y a donc cette idée de longue date selon laquelle, à mesure que les intrants bruts se transforment en ces représentations intermédiaires, le système échange la prédiction contre la compression, et la construction de concepts de niveau supérieur à travers ce goulot d'étranglement de l'information."

Cependant, Kolchinsky et ses collaborateurs Brendan Tracey (SFI, MIT) et Steven Van Kuyk (Université de Wellington) ont découvert une faiblesse surprenante lorsqu'ils ont appliqué cette explication à des problèmes de classification courants, où chaque entrée a une sortie correcte (par exemple, dans laquelle chaque image peut être soit d'un chat, soit d'un chien). Dans ces cas, ils ont constaté que les classificateurs avec de nombreuses couches n'abandonnent généralement pas certaines prédictions pour une compression améliorée. Ils ont également constaté qu'il existe de nombreuses représentations « triviales » des intrants qui sont, du point de vue de la théorie de l'information, optimale en termes d'équilibre entre prédiction et compression.

« Nous avons constaté que cette mesure du goulot d'étranglement de l'information ne perçoit pas la compression de la même manière que vous ou moi le ferions. Étant donné le choix, il est tout aussi heureux de regrouper les « verres à martini » avec les « Labradors », comme c'est pour les regrouper avec des « flûtes à champagne, "" explique Tracey. "Cela signifie que nous devons continuer à rechercher des mesures de compression qui correspondent mieux à nos notions de compression."

Bien que l'idée de compresser les entrées puisse encore jouer un rôle utile dans l'apprentissage automatique, cette recherche suggère qu'elle n'est pas suffisante pour évaluer les représentations internes utilisées par différents algorithmes d'apprentissage automatique.

À la fois, Kolchinsky dit que le concept de compromis entre la compression et la prédiction sera toujours valable pour les tâches moins déterministes, comme prédire la météo à partir d'un ensemble de données bruyant. "Nous ne disons pas que le goulot d'étranglement de l'information est inutile pour l'apprentissage [machine] supervisé, " insiste Kolchinsky. " Ce que nous montrons ici, c'est qu'il se comporte de manière contre-intuitive sur de nombreux problèmes courants d'apprentissage automatique, et c'est quelque chose dont les membres de la communauté de l'apprentissage automatique devraient être conscients."