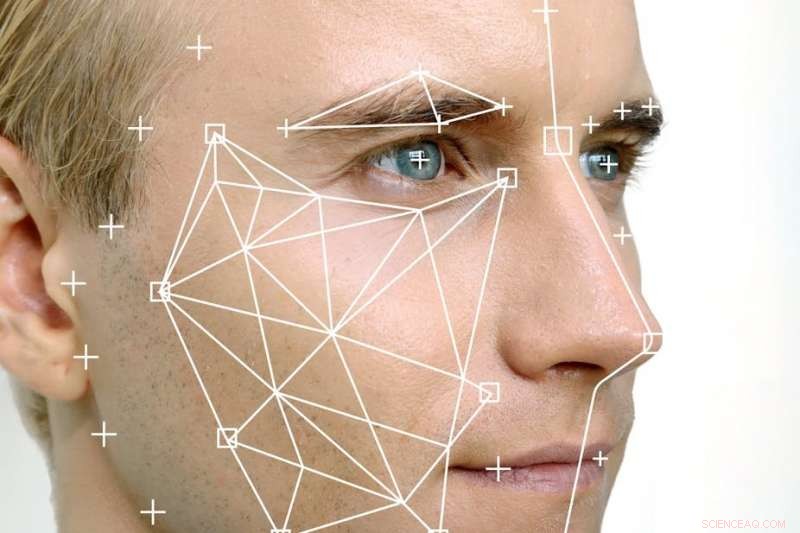

Il existe de nombreuses questions sur la manière dont la technologie de reconnaissance faciale peut empiéter sur les droits à la vie privée des personnes et si elle aggravera la discrimination dans les pratiques policières. Crédit :Shutterstock

L'utilisation de la technologie de reconnaissance faciale automatisée (FRT) est de plus en plus courante dans le monde, notamment en Chine, le Royaume-Uni et maintenant l'Australie.

FRT signifie que nous pouvons identifier des individus sur la base d'une analyse de leurs caractéristiques faciales géométriques, faire une comparaison entre un algorithme créé à partir de l'image capturée et un déjà stocké, comme un permis de conduire, image de garde ou compte de médias sociaux.

FRT dispose de nombreuses applications privées et publiques lorsqu'une vérification d'identité est nécessaire. Il s'agit notamment d'accéder à une zone sécurisée, déverrouiller un appareil mobile ou monter à bord d'un avion. Il est également capable de reconnaître les humeurs des gens, réactions et, Apparemment, sexualité.

Et il est plus précieux pour la police que les caméras de vidéosurveillance ordinaires, car il peut identifier des individus en temps réel et les relier aux images stockées. Ceci est d'une immense valeur pour l'État dans les enquêtes criminelles, les opérations de lutte contre le terrorisme et le contrôle des frontières.

Comment cela empiète sur les droits à la vie privée

Mais le déploiement de FRT, qui est déjà utilisé par l'AFP et les forces de l'ordre et par des entreprises privées ailleurs (aéroports, sites sportifs, banques et centres commerciaux), est sous-réglementé et basé sur des algorithmes douteux qui ne sont pas publiquement transparents.

Cette technologie a des implications majeures pour les droits à la vie privée des personnes, et son utilisation peut aggraver les préjugés et la discrimination existants dans les pratiques policières.

L'utilisation de FRT empiète sur les droits à la vie privée en créant un algorithme de caractéristiques personnelles uniques. Cela réduit à son tour les caractéristiques des personnes à des données et permet leur suivi et leur surveillance. Ces données et images seront également stockées pendant un certain temps, ouvrant la possibilité de piratage ou de fraude.

En outre, FRT peut exposer les gens à une discrimination potentielle de deux manières. D'abord, les agences étatiques peuvent abuser des technologies par rapport à certains groupes démographiques, que ce soit intentionnellement ou non.

Et deuxièmement, la recherche indique que les minorités ethniques, les personnes de couleur et les femmes sont mal identifiées par FRT à des taux plus élevés que le reste de la population. Cette inexactitude peut conduire à ce que les membres de certains groupes soient soumis à des mesures de police ou de sécurité sévères et que leurs données soient conservées de manière inappropriée.

Ceci est particulièrement pertinent en ce qui concerne les communautés qui sont déjà ciblées de manière disproportionnée en Australie.

Ce que les législateurs essaient de faire

Le Parlement a rédigé un projet de loi pour tenter de réguler cet espace, mais cela laisse beaucoup à désirer. Le projet de loi est actuellement en deuxième lecture; aucune date n'a été fixée pour un vote.

Si passé, le projet de loi permettrait l'échange d'informations d'identité entre le gouvernement du Commonwealth, les gouvernements des États et des territoires et les « entités non gouvernementales » (qui n'ont pas été spécifiées) à travers la création d'un hub central appelé « The Capability », ainsi que la solution de reconnaissance faciale du permis de conduire national, une base de données d'informations contenues dans les documents d'identité gouvernementaux, comme les permis de conduire.

Le projet de loi autoriserait également le ministère de l'Intérieur à percevoir, utiliser et partager des informations d'identification en relation avec une gamme d'activités, comme la prévention de la fraude, forces de l'ordre, sécurité communautaire, et la sécurité routière.

Il serait de loin préférable qu'une telle législation n'autorise le partage d'identité que pour un nombre limité d'infractions graves. Comme écrit, ce projet de loi concerne les personnes qui n'ont été condamnées pour aucune infraction criminelle - et, En réalité, ne doit être soupçonné d'aucune infraction.

Aussi, le peuple australien n'a pas consenti à ce que ses données soient partagées de cette manière. Un tel partage aurait un effet disproportionné sur notre droit à la vie privée.

Surtout, la violation du droit à la vie privée est aggravée par le fait que le projet de loi permettrait au secteur privé d'accéder aux services d'appariement d'identité. Bien que le secteur privé utilise déjà dans une certaine mesure des technologies de comparaison et de vérification d'images, comme par les banques cherchant à détecter le blanchiment d'argent par exemple, le projet de loi étendrait cela. Le projet de loi ne prévoit pas de garanties ou de sanctions suffisantes pour les entités privées si elles utilisent le hub ou les données des personnes de manière inappropriée.

La prévalence des faux positifs dans les correspondances d'identité

Dans un sens pratique, il y a aussi des inquiétudes concernant la fiabilité et la précision du FRT, qui se développe rapidement mais n'est pas sans problèmes majeurs. Reste à savoir si ces problèmes ne sont que des bugs ou une fonctionnalité de FRT.

L'expérience du Royaume-Uni illustre clairement ces problèmes. Police du sud du Pays de Galles, le leader national britannique sur la technologie de reconnaissance faciale, utilisé le système développé par une société australienne privée appelée Neoface lors de 18 rassemblements publics entre mai 2017 et mars 2018. Il a constaté que 91% des correspondances, ou 2, 451 occurrences, identifié à tort des membres innocents du public comme étant sur une liste de surveillance. La surveillance manuelle du programme a révélé que les correspondances étaient des faux positifs.

La police métropolitaine de Londres dirige également un projet pilote FRT. Il a enregistré des chiffres un peu meilleurs, mais avait toujours un taux d'identification de faux négatifs de 30 % au carnaval de Notting Hill et de 22 % au jour du Souvenir, les deux en 2017.

Le rôle central des entreprises privées dans le développement de cette technologie est également important à souligner. Les algorithmes FRT sont brevetés, et il n'y a aucune indication publiquement disponible de la mesure ou de l'étalon qui représente une « correspondance » d'identité.

Légiférer dans un mouvement rapide, l'espace axé sur la technologie n'est pas une tâche enviable. Il y a certains avantages à un certain degré de flexibilité dans les définitions et les règles juridiques afin que la loi ne devienne pas trop tôt statique et redondante. Mais même l'interprétation la plus généreuse du projet de loi admettrait qu'il s'agit d'une façon imparfaite de réglementer l'utilisation d'une technologie puissante et problématique qui est là pour rester, que vous l'aimiez ou non.

Cet article est republié à partir de The Conversation sous une licence Creative Commons. Lire l'article original.