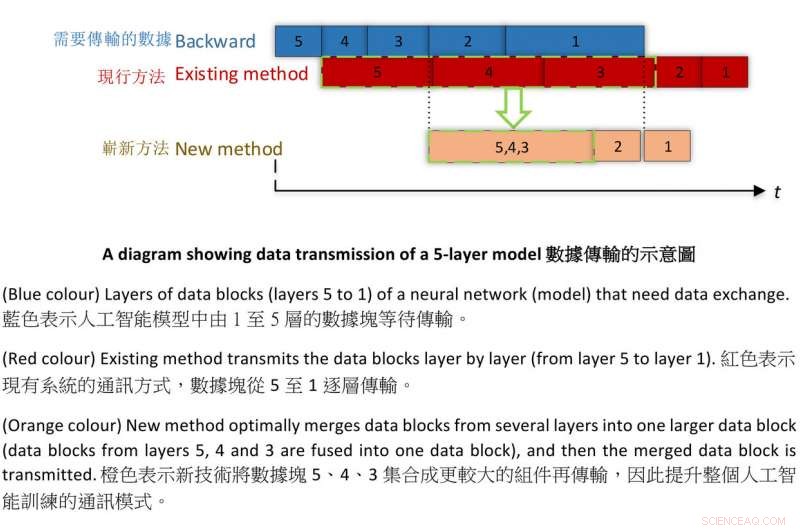

Diagramme montrant la transmission de données d'un modèle à 5 couches. Crédit :HKBU

Des chercheurs de l'Université baptiste de Hong Kong (HKBU) se sont associés à une équipe de Tencent Machine Learning pour créer une nouvelle technique permettant d'entraîner des machines d'intelligence artificielle (IA) plus rapidement que jamais tout en maintenant la précision.

Au cours de l'expérimentation, l'équipe a formé deux réseaux de neurones profonds populaires appelés AlexNet et ResNet-50 en seulement quatre minutes et 6,6 minutes respectivement. Précédemment, le temps de formation le plus rapide était de 11 minutes pour AlexNet et de 15 minutes pour ResNet-50.

AlexNet et ResNet-50 sont des réseaux de neurones profonds construits sur ImageNet, un ensemble de données à grande échelle pour la reconnaissance visuelle. Une fois formé, le système a pu reconnaître et étiqueter un objet sur une photo donnée. Le résultat est nettement plus rapide que les records précédents et surpasse tous les autres systèmes existants.

L'apprentissage automatique est un ensemble d'approches mathématiques qui permettent aux ordinateurs d'apprendre à partir de données sans être explicitement programmés par des humains. Les algorithmes résultants peuvent ensuite être appliqués à une variété de données et de tâches de reconnaissance visuelle utilisées dans l'IA.

L'équipe de la HKBU comprend le professeur Chu Xiaowen et le doctorat. étudiant Shi Shaohuai du Département d'informatique. Le professeur Chu a dit :"Nous avons proposé une nouvelle méthode d'entraînement optimisée qui améliore considérablement le meilleur rendement sans perdre en précision. Dans l'entraînement à l'IA, les chercheurs s'efforcent de former leurs réseaux plus rapidement, mais cela peut conduire à une diminution de la précision. Par conséquent, entraîner des modèles d'apprentissage automatique à grande vitesse tout en maintenant l'exactitude et la précision est un objectif vital pour les scientifiques. »

Le professeur Chu a déclaré que le temps nécessaire pour former des machines d'IA est affecté à la fois par le temps de calcul et le temps de communication. L'équipe de recherche a réalisé des percées dans les deux aspects pour créer cette réalisation record.

Cela comprenait l'adoption d'une méthode de calcul plus simple connue sous le nom de FP16 pour remplacer la plus traditionnelle, FP32, rendre le calcul beaucoup plus rapide sans perdre en précision. Comme le temps de communication est affecté par la taille des blocs de données, l'équipe a mis au point une technique de communication nommée « fusion tensorielle, " qui combine de plus petits morceaux de données en plus grands, optimisant le modèle de transmission et améliorant ainsi l'efficacité de la communication pendant la formation à l'IA.

Cette nouvelle technique peut être adoptée dans la classification d'images à grande échelle, et il peut également être appliqué à d'autres applications d'IA, y compris la traduction automatique ; traitement du langage naturel (NLP) pour améliorer les interactions entre le langage humain et les ordinateurs ; analyse d'imagerie médicale; et des jeux de combat multijoueurs en ligne.