Crédit :Zimmer, Boniface, et Dutech.

Des chercheurs de l'Université de Lorraine ont récemment mis au point un nouveau type d'apprentissage par transfert basé sur l'apprentissage par renforcement profond sans modèle avec élargissement continu de l'espace sensorimoteur. Leur approche, présenté dans un article publié lors de la huitième conférence internationale conjointe de l'IEEE sur le développement et l'apprentissage et sur la robotique épigénétique, et en libre accès sur HAL archives-ouvertes, s'inspire du développement de l'enfant, en particulier par la croissance de l'espace sensorimoteur qui se produit lorsque l'enfant acquiert de nouvelles stratégies utiles.

« Le cadre formel de l'apprentissage par renforcement peut être utilisé pour modéliser un large éventail de problèmes, " a déclaré Matthieu Zimmer, l'un des chercheurs qui ont mené l'étude. « Dans ce cadre, un agent utilise une méthode d'essais et d'erreurs pour apprendre lentement quelle séquence d'actions est la plus appropriée pour atteindre un objectif souhaité. Si certaines conditions sont remplies, alors la théorie nous dit que nous avons des algorithmes que l'agent peut utiliser pour trouver la solution optimale au problème, pourtant cela peut prendre de longues périodes de temps. Pour accélérer ce processus, nous avons exploré les moyens pour un agent d'atteindre de bonnes performances en moins d'essais, même s'il n'a pratiquement aucune connaissance de la tâche qu'il devra résoudre."

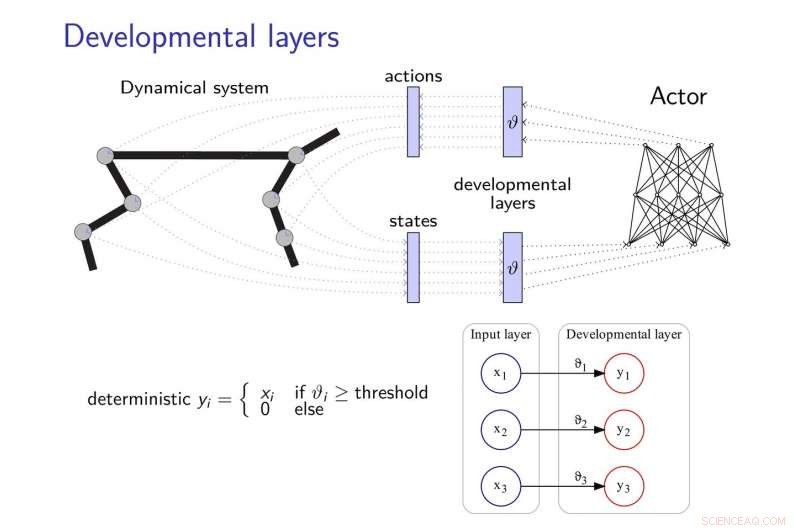

La méthode d'apprentissage par transfert proposée par Zimmer et ses collègues ajoute des couches de développement aux réseaux de neurones, leur permettant de développer de nouvelles stratégies pour accomplir des tâches, surtout lorsque ces tâches sont liées d'une manière ou d'une autre. Ces couches développementales découvrent progressivement certaines dimensions de l'espace sensorimoteur, suivant une heuristique de motivation intrinsèque.

Pour atténuer les effets de « l'oubli catastrophique, " un problème commun dans le développement des réseaux de neurones, les chercheurs se sont inspirés de la théorie de la consolidation élastique du poids, l'utiliser pour réguler l'apprentissage du contrôleur neuronal.

Crédit :Zimmer, Boniface, et Dutech.

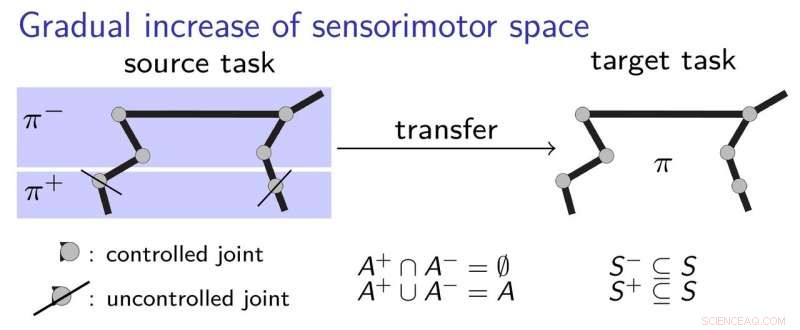

"L'idée de base de notre travail est que l'agent commence avec des capacités de perception et d'action très limitées, puis les développe de manière développementale, inspiré par la façon dont un enfant apprend, " a déclaré Alain Dutech, un autre chercheur qui a mené l'étude. « L'espace dans lequel l'agent cherche une solution est ainsi réduit, et cette solution, bien qu'à un problème dégradé, peut être trouvé plus facilement. Ensuite, nous augmentons les capacités de l'agent, en profitant de la solution précédente trouvée."

Pour mieux expliquer le fonctionnement de leur approche d'apprentissage par transfert, les chercheurs utilisent l'exemple d'un enfant apprenant à saisir un stylo. Initialement, l'enfant pourrait n'utiliser que son coude et son épaule, apprendre à toucher le stylo. Successivement, elle pourrait décider de commencer à utiliser la main et les doigts, avoir compris les bases de la meilleure façon d'établir un premier contact avec le stylo. Cela implique un processus d'apprentissage progressif, où l'enfant acquiert pas à pas des stratégies sensorimotrices, sans avoir à apprendre trop de choses à la fois.

Les chercheurs ont validé leur nouvelle approche à l'aide de deux algorithmes d'apprentissage en profondeur de pointe, à savoir DDPG et NFAC, testé sur Demi-guépard et Humanoïde, deux repères environnementaux de grande dimension. Leurs résultats suggèrent que la recherche d'une solution sous-optimale dans un sous-ensemble de l'espace des paramètres avant de considérer l'espace complet est une technique utile pour amorcer les algorithmes d'apprentissage, obtenir de meilleures performances avec un entraînement plus court.

« Dans le domaine très actif et stimulant de l'apprentissage par renforcement, nous avons montré que des méthodes de développement comme la nôtre, ainsi que d'autres similaires explorés par d'autres chercheurs, pourrait être combiné avec des méthodes d'apprentissage en profondeur pour permettre un apprentissage à partir de zéro, avec peu de connaissances préalables, " a déclaré Zimmer.

Malgré ses résultats prometteurs, l'étude menée par Zimmer et ses collègues a également mis en évidence l'écart qui existe encore entre les capacités des réseaux de neurones profonds et les êtres humains. En réalité, même en utilisant l'apprentissage par renforcement du développement, la plupart des agents existants sont encore beaucoup moins polyvalents et efficaces que les humains.

"Parfois, les humains peuvent apprendre en un seul essai, pourtant, même l'apprentissage artificiel le plus efficace nécessitera une combinaison complexe de différents algorithmes pour apprendre, estimation, mémoriser, comparer, et optimiser, " dit Zimmer. " De plus, certains de ces algorithmes ne sont toujours pas clairement définis."

Dutech et ses collègues explorent maintenant de nouveaux horizons dans le domaine de l'IA et de l'apprentissage en profondeur. Par exemple, ils aimeraient développer de nouvelles façons pour un agent d'apprentissage de catégoriser correctement les stimuli qu'il perçoit.

"L'apprentissage est beaucoup plus efficace lorsque l'agent peut interpréter ce qui est 'voit' ou 'sent', " expliqua Dutech. " Aujourd'hui, la tendance est d'utiliser l'apprentissage en profondeur et les réseaux de neurones pour ce faire. Nous explorons maintenant d'autres méthodes pour extraire des informations pertinentes et utiles de la perception brute des agents artificiels, qui dépendent moins d'un énorme corpus d'exemples ; comme l'apprentissage non supervisé et l'auto-organisation."

© 2018 Tech Xplore