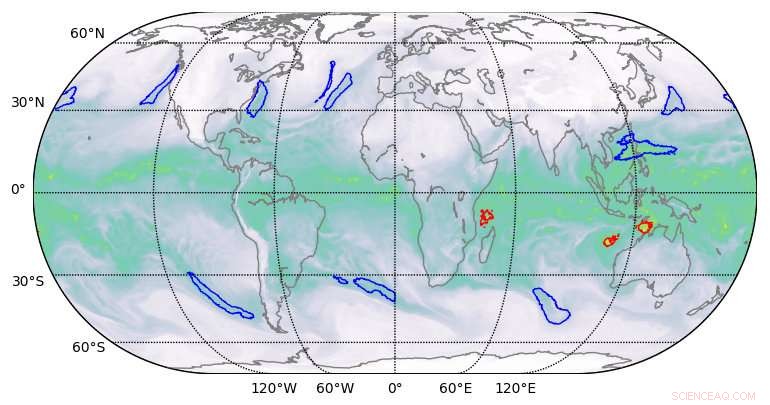

Résultats de segmentation de haute qualité produits par l'apprentissage en profondeur sur des ensembles de données climatiques. Crédit :Berkeley Lab

Une équipe de scientifiques informatiques du Lawrence Berkeley National Laboratory (Berkeley Lab) et du Oak Ridge National Laboratory (ORNL) et d'ingénieurs de NVIDIA a, pour la première fois, a démontré une application d'apprentissage en profondeur de classe exascale qui a brisé la barrière de l'exaop.

À l'aide d'un ensemble de données climatiques du Berkeley Lab sur le système Summit de l'ORNL à l'Oak Ridge Leadership Computing Facility (OLCF), ils ont formé un réseau de neurones profonds pour identifier les modèles météorologiques extrêmes à partir de simulations climatiques à haute résolution. Summit est un supercalculateur IBM Power Systems AC922 alimenté par plus de 9, 000 processeurs IBM POWER9 et 27, 000 GPU NVIDIA Tesla V100 Tensor Core. En exploitant les cœurs NVIDIA Tensor spécialisés intégrés aux GPU à grande échelle, les chercheurs ont atteint une performance maximale de 1,13 exaops et une performance soutenue de 0,999 - l'algorithme d'apprentissage en profondeur le plus rapide signalé à ce jour et une réalisation qui leur a valu une place sur la liste des finalistes de cette année pour le prix Gordon Bell.

« Cette collaboration a produit un certain nombre de réalisations uniques, " dit Prabhat, qui dirige l'équipe des services de données et d'analyse au Centre national de calcul scientifique de la recherche énergétique de Berkeley Lab et est co-auteur de la soumission de Gordon Bell. "C'est le premier exemple d'architecture d'apprentissage en profondeur qui a pu résoudre des problèmes de segmentation en science du climat, et dans le domaine de l'apprentissage profond, c'est le premier exemple d'une application réelle qui a brisé la barrière exascale."

Ces réalisations ont été rendues possibles grâce à un mélange innovant de capacités matérielles et logicielles. Côté matériel, Summit a été conçu pour fournir 200 pétaflops de performances informatiques de haute précision et a récemment été nommé ordinateur le plus rapide au monde, capable d'effectuer plus de trois exaops (3 milliards de milliards de calculs) par seconde. Le système présente une architecture hybride; chacun de ses 4, 608 nœuds de calcul contiennent deux processeurs IBM POWER9 et six GPU NVIDIA Volta Tensor Core, tous connectés via l'interconnexion haute vitesse NVIDIA NVLink. Les GPU NVIDIA sont un facteur clé des performances de Summit, permettant des téraflops de pointe jusqu'à 12 fois plus élevés pour l'entraînement et des téraflops de pointe 6 fois plus élevés pour l'inférence dans les applications d'apprentissage en profondeur par rapport à son prédécesseur, la Tesla P100.

"Notre partenariat avec Berkeley Lab et Oak Ridge National Laboratory a montré le véritable potentiel des GPU NVIDIA Tensor Core pour les applications IA et HPC, " a déclaré Michael Houston, ingénieur senior distingué de l'apprentissage en profondeur chez NVIDIA. "Pour faire de l'exascale une réalité, notre équipe a exploité les capacités multi-précision contenues dans les milliers de GPU NVIDIA Volta Tensor Core sur Summit pour atteindre des performances optimales en matière d'entraînement et d'inférence dans les applications d'apprentissage en profondeur. »

Évolutivité et communication améliorées

Côté logiciel, en plus de fournir l'ensemble de données climatiques, l'équipe du Berkeley Lab a développé des algorithmes de reconnaissance de modèles pour entraîner le réseau de neurones DeepLabv3+ afin d'extraire des classifications au niveau des pixels des modèles météorologiques extrêmes, ce qui pourrait aider à prévoir l'évolution des événements météorologiques extrêmes à mesure que le climat se réchauffe. Selon Thorsten Kurth, un spécialiste de la performance applicative au NERSC qui a mené ce projet, l'équipe a apporté des modifications à DeepLabv3+ qui ont amélioré l'évolutivité et les capacités de communication du réseau et ont rendu possible la réalisation d'exaops. Cela incluait de peaufiner le réseau pour l'entraîner à extraire des caractéristiques au niveau des pixels et une classification par pixel et à améliorer la communication de nœud à nœud.

"Ce qui est impressionnant dans cet effort, c'est que nous avons pu faire évoluer un framework à haute productivité comme TensorFlow, qui est techniquement conçu pour le prototypage rapide à petite et moyenne échelle, à 4, 560 nœuds sur Summit, ", a-t-il déclaré. "Avec un certain nombre d'améliorations des performances, nous avons pu faire fonctionner le framework sur la quasi-totalité du supercalculateur et atteindre des performances de niveau exaop, qui, à ma connaissance, est le mieux réalisé jusqu'à présent dans une application étroitement couplée."

Parmi les autres innovations, citons la mise en place de données parallèles à grande vitesse, un pipeline d'ingestion de données optimisé et une segmentation multicanal. Les tâches de segmentation d'image traditionnelles fonctionnent sur des images rouge/bleu/vert à trois canaux. Mais les ensembles de données scientifiques comprennent souvent de nombreux canaux; en climat, par exemple, ceux-ci peuvent inclure la température, vitesses du vent, valeurs de pression et d'humidité. En exécutant le réseau de neurones optimisé sur Summit, les capacités de calcul supplémentaires ont permis l'utilisation des 16 canaux disponibles, ce qui a considérablement amélioré la précision des modèles.

« Nous avons montré que nous pouvons appliquer des méthodes d'apprentissage en profondeur pour la segmentation au niveau des pixels sur les données climatiques, et potentiellement sur d'autres domaines scientifiques, " dit Prabhat. " Plus généralement, notre projet a jeté les bases d'un apprentissage en profondeur exascale pour la science, ainsi que des applications commerciales."