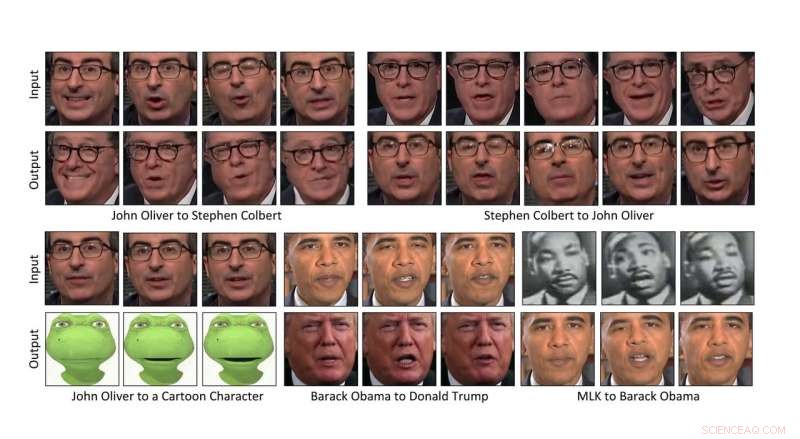

Des chercheurs de l'Université Carnegie Mellon ont mis au point un moyen de transformer automatiquement le contenu d'une vidéo dans le style d'une autre, permettant de transférer les expressions faciales d'une personne sur la vidéo d'une autre personne, ou même un personnage de dessin animé. Crédit :Université Carnegie Mellon

Des chercheurs de l'Université Carnegie Mellon ont mis au point un moyen de transformer automatiquement le contenu d'une vidéo dans le style d'une autre, permettant de transférer les expressions faciales du comédien John Oliver à celles d'un personnage de dessin animé, ou faire fleurir une jonquille de la même manière qu'un hibiscus le ferait.

Parce que la méthode basée sur les données ne nécessite pas d'intervention humaine, il peut transformer rapidement de grandes quantités de vidéo, ce qui en fait une aubaine pour la production cinématographique. Il peut également être utilisé pour convertir des films noir et blanc en couleur et pour créer du contenu pour des expériences de réalité virtuelle.

"Je pense qu'il y a beaucoup d'histoires à raconter, " dit Aayush Bansal, un doctorat étudiant à l'Institut de Robotique de la CMU. La production cinématographique a été sa principale motivation pour aider à concevoir la méthode, il expliqua, permettant de produire des films plus rapidement et à moindre coût. "C'est un outil pour l'artiste qui lui donne un premier modèle qu'il peut ensuite améliorer, " il ajouta.

La technologie a également le potentiel d'être utilisée pour les « contrefaçons profondes, " des vidéos dans lesquelles l'image d'une personne est insérée sans autorisation, faire croire que la personne a fait ou dit des choses qui ne lui correspondent pas, Bansal reconnu.

« Ce fut une révélation pour nous tous sur le terrain que de tels faux seraient créés et auraient un tel impact, " a-t-il dit. " Trouver des moyens de les détecter sera important pour aller de l'avant. "

Bansal présentera la méthode aujourd'hui à l'ECCV 2018, la Conférence européenne sur la vision par ordinateur, à Munich. Ses co-auteurs incluent Deva Ramanan, Maître de conférences CMU de robotique.

Le transfert de contenu d'une vidéo au style d'une autre repose sur l'intelligence artificielle. En particulier, une classe d'algorithmes appelés réseaux contradictoires génératifs (GAN) a permis aux ordinateurs de comprendre plus facilement comment appliquer le style d'une image à une autre, en particulier lorsqu'ils n'ont pas été soigneusement appariés.

Dans un GAN, deux modèles sont créés :un discriminateur qui apprend à détecter ce qui est cohérent avec le style d'une image ou d'une vidéo, et un générateur qui apprend à créer des images ou des vidéos qui correspondent à un certain style. Lorsque les deux fonctionnent de manière compétitive - le générateur essayant de tromper le discriminateur et le discriminateur notant l'efficacité du générateur - le système apprend finalement comment le contenu peut être transformé en un certain style.

Une variante, appelé cycle-GAN, boucle la boucle, un peu comme traduire un discours anglais en espagnol, puis de nouveau l'espagnol en anglais, puis évaluer si le discours traduit deux fois a toujours un sens. L'utilisation de cycle-GAN pour analyser les caractéristiques spatiales des images s'est avérée efficace pour transformer une image dans le style d'une autre.

Cette méthode spatiale laisse encore à désirer pour la vidéo, avec des artefacts et des imperfections indésirables surgissant dans le cycle complet des traductions. Pour atténuer le problème, les chercheurs ont développé une technique, appelé Recycle-GAN, qui intègre non seulement l'espace, mais des informations temporelles. Ces informations supplémentaires, tenir compte des changements dans le temps, limite davantage le processus et produit de meilleurs résultats.

Les chercheurs ont montré que Recycle-GAN peut être utilisé pour transformer la vidéo d'Oliver en ce qui semble être le comédien Stephen Colbert et de nouveau en Oliver. Ou la vidéo du visage de John Oliver peut être transformée en personnage de dessin animé. Recycle-GAN permet non seulement de copier les expressions faciales, mais aussi les mouvements et la cadence de la performance.

Les effets ne se limitent pas aux visages, voire des corps. Les chercheurs ont démontré que la vidéo d'une fleur épanouie peut être utilisée pour manipuler l'image d'autres types de fleurs. Ou les nuages qui traversent le ciel rapidement par une journée venteuse peuvent être ralentis pour donner l'apparence d'un temps plus calme.

De tels effets pourraient être utiles pour développer des voitures autonomes capables de naviguer la nuit ou par mauvais temps, dit Bansal. Obtenir des vidéos de scènes nocturnes ou de temps orageux dans lesquelles des objets peuvent être identifiés et étiquetés peut être difficile, il expliqua. Recycler-GAN, d'autre part, peut transformer des scènes diurnes facilement obtenues et étiquetées en scènes nocturnes ou orageuses, fournissant des images qui peuvent être utilisées pour entraîner les voitures à fonctionner dans ces conditions.