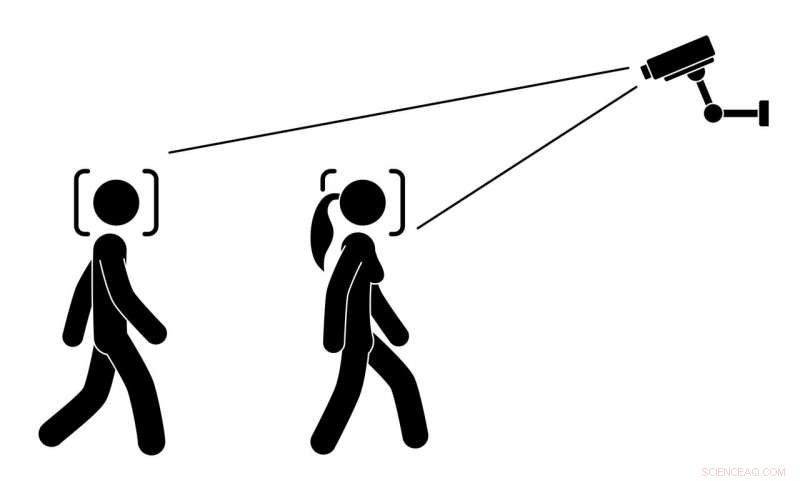

Un algorithme devrait-il essayer de deviner le sexe des gens par leur apparence ? Crédit :all_is_magic/Shutterstock.com

Imaginez marcher dans la rue et voir des écrans publicitaires changer leur contenu en fonction de votre façon de marcher, comment tu parles, ou même la forme de votre poitrine. Ces écrans reposent sur des caméras cachées, des microphones et des ordinateurs pour deviner si vous êtes un homme ou une femme. Cela peut sembler futuriste, mais les clients d'une pizzeria norvégienne ont découvert que c'était exactement ce qui se passait :les femmes voyaient des publicités pour la salade et les hommes voyaient des publicités pour les options de viande. Le logiciel exécutant un panneau publicitaire numérique a renversé les haricots lorsqu'il s'est écrasé et a affiché son code sous-jacent. La motivation derrière l'utilisation de cette technologie pourrait avoir été d'améliorer la qualité de la publicité ou l'expérience utilisateur. Néanmoins, de nombreux clients en ont été désagréablement surpris.

Ce genre de situation n'est pas seulement effrayant et envahissant. C'est pire :les efforts de reconnaissance automatique du genre - en utilisant des algorithmes pour deviner le sexe d'une personne sur la base d'images, vidéo ou audio – soulèvent d'importantes préoccupations sociales et éthiques qui ne sont pas encore pleinement explorées. La plupart des recherches actuelles sur les technologies de reconnaissance automatique du genre se concentrent plutôt sur les détails technologiques.

Nos recherches récentes ont révélé que les personnes ayant des identités de genre diverses, y compris ceux qui s'identifient comme transgenres ou de genre non binaire, sont particulièrement préoccupés par le fait que ces systèmes pourraient les classer de manière erronée. Les personnes qui expriment leur genre différemment des normes masculines et féminines stéréotypées subissent déjà de la discrimination et des préjudices en raison d'une mauvaise catégorisation ou d'une incompréhension. Idéalement, les concepteurs de technologies devraient développer des systèmes pour rendre ces problèmes moins courants, pas plus.

Utiliser des algorithmes pour classer les personnes

À mesure que les technologies numériques deviennent plus puissantes et sophistiquées, leurs concepteurs essaient de les utiliser pour identifier et catégoriser des caractéristiques humaines complexes, comme l'orientation sexuelle, genre et ethnie. L'idée est qu'avec une formation suffisante sur les données utilisateur abondantes, les algorithmes peuvent apprendre à analyser l'apparence et le comportement des gens - et peut-être un jour caractériser les gens ainsi que, ou même mieux que, d'autres humains le font.

Le genre est un sujet difficile à gérer pour les gens. C'est un concept complexe avec des rôles importants à la fois en tant que construction culturelle et aspect central de l'identité d'un individu. Des chercheurs, les universitaires et les militants révèlent de plus en plus la diversité, aspects fluides et multiformes du genre. Dans le processus, ils constatent qu'ignorer cette diversité peut conduire à la fois à des expériences néfastes et à l'injustice sociale. Par exemple, selon l'Enquête nationale sur les transgenres de 2016, 47 % des participants transgenres ont déclaré avoir subi une forme de discrimination sur leur lieu de travail en raison de leur identité de genre. Plus de la moitié des personnes transgenres qui ont été harcelées, agressés ou expulsés en raison de leur identité de genre avaient tenté de se suicider.

Beaucoup de gens ont, à un moment ou un autre, été surpris, ou confus ou même en colère de se trouver pris pour une personne d'un autre sexe. Lorsque cela arrive à quelqu'un qui est transgenre - comme environ 0,6% des Américains, soit 1,4 million de personnes, sont – cela peut causer un stress et une anxiété considérables.

Effets de la reconnaissance automatique du genre

Dans nos récentes recherches, nous avons interrogé 13 personnes transgenres et de genre non conforme, sur leurs impressions générales sur la technologie de reconnaissance automatique du genre. Nous leur avons également demandé de décrire leurs réponses à des scénarios futurs imaginaires où ils pourraient le rencontrer. Les 13 participants étaient inquiets à propos de cette technologie et doutaient qu'elle puisse offrir des avantages à leur communauté.

La perspective d'être malmené par cela était particulièrement préoccupante; dans leur expérience, le genre est en grande partie interne, caractéristique subjective, pas quelque chose qui est nécessairement ou entièrement exprimé extérieurement. Par conséquent, ni les humains ni les algorithmes ne peuvent lire avec précision le genre à travers les caractéristiques physiques, comme le visage, corps ou voix.

Ils ont décrit comment le fait d'être mal genré par des algorithmes pourrait potentiellement se sentir pire que si les humains le faisaient. La technologie est souvent perçue ou considérée comme objective et impartiale, ainsi, être catégorisé à tort par un algorithme soulignerait l'idée fausse qu'une identité transgenre est inauthentique. Un participant a décrit à quel point il se sentirait blessé si un « logiciel d'un million de dollars développé par autant de personnes » décidait qu'il n'est pas celui qu'il croit être.

Confidentialité et transparence

Les personnes que nous avons interrogées partageaient la préoccupation commune du public selon laquelle des caméras automatisées pourraient être utilisées à des fins de surveillance sans leur consentement ou sans qu'elles le sachent; pendant des années, des chercheurs et des militants ont soulevé des signaux d'alarme concernant les menaces croissantes pour la vie privée dans un monde peuplé de capteurs et de caméras.

Mais nos participants ont décrit comment les effets de ces technologies pourraient être plus importants pour les personnes transgenres. Par exemple, ils peuvent être considérés comme inhabituels parce qu'ils ont une apparence ou un comportement différent de ce à quoi les algorithmes sous-jacents s'attendent. Certains participants craignaient même que les systèmes puissent déterminer à tort qu'ils essaient d'être quelqu'un d'autre et tromper le système.

Leurs préoccupations s'étendaient également aux personnes cisgenres qui pourraient avoir une apparence ou un comportement différent de la majorité, comme des personnes de races différentes, les personnes que les algorithmes perçoivent comme androgynes, et les personnes avec des structures faciales uniques. Cela arrive déjà aux personnes issues de minorités raciales et ethniques, qui sont régulièrement mal identifiés par la technologie de reconnaissance faciale. Par exemple, la technologie de reconnaissance faciale existante dans certaines caméras ne parvient pas à détecter correctement les visages des utilisateurs asiatiques et à envoyer des messages pour qu'ils arrêtent de cligner des yeux ou qu'ils ouvrent les yeux.

Nos personnes interrogées voulaient en savoir plus sur le fonctionnement des systèmes de reconnaissance automatique du genre et à quoi ils servent. Ils ne voulaient pas connaître les détails techniques approfondis, mais voulait s'assurer que la technologie ne compromettrait pas leur vie privée ou leur identité. Ils voulaient également que davantage de personnes transgenres soient impliquées dans les premières étapes de la conception et du développement de ces systèmes, bien avant leur déploiement.

Créer des systèmes automatiques inclusifs

Nos résultats démontrent comment les concepteurs de technologies de catégorisation automatique peuvent causer des dommages par inadvertance en faisant des hypothèses sur la simplicité et la prévisibilité des caractéristiques humaines. Notre recherche s'ajoute à un corpus croissant de travaux qui tentent d'intégrer de manière plus réfléchie le genre dans la technologie.

Les minorités ont historiquement été exclues des conversations sur le déploiement de technologies à grande échelle, y compris les minorités ethniques et les personnes handicapées. Encore, les scientifiques et les concepteurs savent que l'inclusion de la contribution des groupes minoritaires au cours du processus de conception peut conduire à des innovations techniques qui profitent à tous. Nous plaidons en faveur d'une approche de l'automatisation plus inclusive et centrée sur l'humain qui intègre diverses perspectives.

À mesure que les technologies numériques se développent et mûrissent, ils peuvent conduire à des innovations impressionnantes. Mais comme les humains dirigent ce travail, ils doivent éviter d'amplifier les préjugés humains négatifs et limitatifs. Dans le cas de la reconnaissance automatique du genre, nous ne concluons pas nécessairement que ces algorithmes doivent être abandonnés. Plutôt, les concepteurs de ces systèmes devraient inclure, et sensible à, la diversité et la complexité de l'identité humaine.

Cet article a été initialement publié sur The Conversation. Lire l'article original.