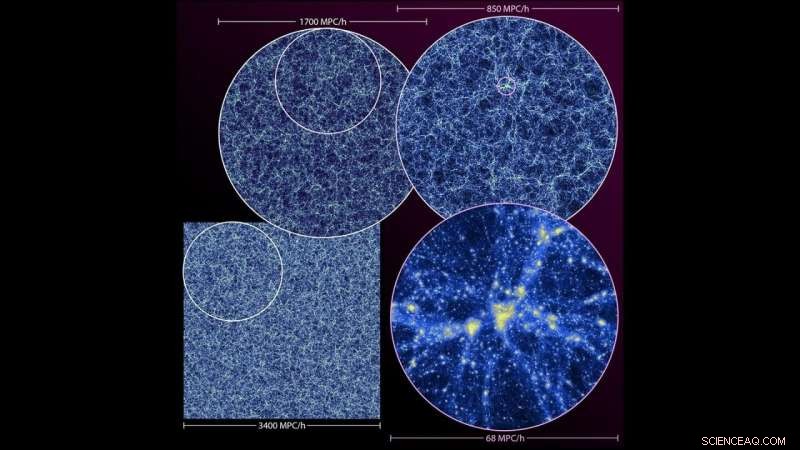

Visualisation de la simulation du dernier voyage. La structure à grande échelle de l'univers est illustrée sous la forme d'une fine tranche à travers la simulation complète (en bas à gauche) et des zooms à différents niveaux. Le panneau inférieur droit montre l'une des plus grandes structures de la simulation. Crédit :Laboratoire National d'Argonne.

Une équipe de physiciens et d'informaticiens du laboratoire national d'Argonne du département américain de l'Énergie (DOE) a effectué l'une des cinq plus grandes simulations cosmologiques jamais réalisées. Les données de la simulation éclaireront les cartes du ciel pour aider à mener des expériences cosmologiques à grande échelle.

La simulation, appelé le dernier voyage, suit la distribution de la masse à travers l'univers au fil du temps - en d'autres termes, comment la gravité fait qu'une mystérieuse substance invisible appelée "matière noire" s'agglutine pour former des structures à plus grande échelle appelées halos, au sein de laquelle les galaxies se forment et évoluent.

"Nous avons beaucoup appris et adapté au cours de la vie de Mira, et c'est une opportunité intéressante de regarder en arrière et de regarder vers l'avenir en même temps."—Adrian Pope, Physicien d'Argonne

Les scientifiques ont effectué la simulation sur le supercalculateur Mira d'Argonne. La même équipe de scientifiques a exécuté une simulation cosmologique précédente appelée la bordure extérieure en 2013, quelques jours seulement après l'allumage de Mira. Après avoir exécuté des simulations sur la machine tout au long de sa durée de vie de sept ans, l'équipe a marqué la retraite de Mira avec la simulation Last Journey.

The Last Journey montre à quel point la technologie d'observation et de calcul a progressé en seulement sept ans, et il apportera des données et des informations à des expériences telles que l'expérience de fond cosmique micro-ondes au sol Stage-4 (CMB-S4), le Legacy Survey of Space and Time (réalisé par l'Observatoire Rubin au Chili), l'instrument spectroscopique à énergie noire et deux missions de la NASA, le télescope spatial romain et SPHEREx.

"Nous avons travaillé avec un énorme volume de l'univers, et nous nous intéressions aux structures à grande échelle, comme des régions de milliers ou de millions de galaxies, mais nous avons également considéré la dynamique à plus petite échelle, " a déclaré Katrin Heitmann, directeur adjoint de division pour la division Physique des hautes énergies (HEP) d'Argonne.

Le code qui a construit le cosmos

La période de six mois pour la simulation Last Journey et les principales tâches d'analyse ont présenté des défis uniques pour le développement de logiciels et le flux de travail. L'équipe a adapté une partie du code utilisé pour la simulation de la bordure extérieure de 2013 avec quelques mises à jour importantes pour utiliser Mira de manière efficace, un système IBM Blue Gene/Q hébergé à l'Argonne Leadership Computing Facility (ALCF), une installation utilisateur du DOE Office of Science.

Spécifiquement, les scientifiques ont utilisé le Hardware/Hybrid Accelerated Cosmology Code (HACC) et son cadre d'analyse, CosmoTools, pour permettre l'extraction incrémentielle des informations pertinentes en même temps que la simulation était en cours.

"L'exécution de la machine complète est difficile car la lecture de la quantité massive de données produites par la simulation est coûteuse en termes de calcul, il faut donc faire beaucoup d'analyses à la volée, " dit Heitmann. " C'est intimidant, car si vous faites une erreur avec les paramètres d'analyse, vous n'avez pas le temps de le refaire."

L'équipe a adopté une approche intégrée pour exécuter le flux de travail pendant la simulation. HACC ferait avancer la simulation dans le temps, déterminer l'effet de la gravité sur la matière pendant de grandes parties de l'histoire de l'univers. Une fois que HACC a déterminé les positions de milliers de milliards de particules informatiques représentant la distribution globale de la matière, CosmoTools interviendrait pour enregistrer les informations pertinentes, telles que la recherche des milliards de halos qui hébergent les galaxies, à utiliser pour l'analyse lors du post-traitement.

"Quand on sait où se trouvent les particules à un moment donné, nous caractérisons les structures qui se sont formées à l'aide de CosmoTools et stockons un sous-ensemble de données pour les utiliser ultérieurement, " a déclaré Adrian Pope, physicien et développeur core HACC et CosmoTools dans la division Computational Science (CPS) d'Argonne. "Si nous trouvons un amas dense de particules, qui indique l'emplacement d'un halo de matière noire, et des galaxies peuvent se former à l'intérieur de ces halos de matière noire."

Le supercalculateur Mira d'Argonne a été récemment mis à la retraite après sept ans d'activité scientifique révolutionnaire. Crédit :Laboratoire National d'Argonne.

Les scientifiques ont répété ce processus imbriqué - où HACC déplace les particules et CosmoTools analyse et enregistre des données spécifiques - jusqu'à la fin de la simulation. L'équipe a ensuite utilisé les fonctionnalités de CosmoTools pour déterminer quels amas de particules étaient susceptibles d'héberger des galaxies. Pour référence, environ 100 à 1, 000 particules représentent des galaxies uniques dans la simulation.

"Nous déplacerions des particules, faire des analyses, déplacer des particules, faire des analyses, " dit Pope. " A la fin, nous reviendrions dans les sous-ensembles de données que nous avions soigneusement choisis pour stocker et exécuter des analyses supplémentaires pour mieux comprendre la dynamique de la formation des structures, tels que les halos qui se sont fusionnés et qui ont fini par se mettre en orbite."

En utilisant le flux de travail optimisé avec HACC et CosmoTools, l'équipe a exécuté la simulation dans la moitié du temps prévu.

Contribution communautaire

La simulation Last Journey fournira les données nécessaires à d'autres expériences cosmologiques majeures à utiliser pour comparer des observations ou tirer des conclusions sur une multitude de sujets. Ces idées pourraient éclairer des sujets allant des mystères cosmologiques, comme le rôle de la matière noire et de l'énergie noire dans l'évolution de l'univers, à l'astrophysique de la formation des galaxies à travers l'univers.

"Cet énorme ensemble de données qu'ils construisent alimentera de nombreux efforts différents, " a déclaré Katherine Riley, directeur scientifique de l'ALCF. "À la fin, c'est notre mission principale :aider la science à fort impact à se faire. Lorsque vous êtes capable non seulement de faire quelque chose de cool, mais pour nourrir toute une communauté, c'est une contribution énorme qui aura un impact pendant de nombreuses années."

La simulation de l'équipe abordera de nombreuses questions fondamentales en cosmologie et est essentielle pour permettre le raffinement des modèles existants et le développement de nouveaux, impact sur les études cosmologiques en cours et à venir.

"Nous n'essayons pas de faire correspondre des structures spécifiques dans l'univers réel, " dit Pope. " Plutôt, nous faisons des structures statistiquement équivalentes, ce qui signifie que si nous regardions nos données, nous pourrions trouver des endroits où vivraient des galaxies de la taille de la Voie lactée. Mais nous pouvons également utiliser un univers simulé comme outil de comparaison pour trouver des tensions entre notre compréhension théorique actuelle de la cosmologie et ce que nous avons observé."

Vous cherchez à exascale

"En repensant à l'époque où nous avons exécuté la simulation de la bordure extérieure, vous pouvez vraiment voir jusqu'où sont allées ces applications scientifiques, " dit Heitmann, qui a joué Outer Rim en 2013 avec l'équipe HACC et Salman Habib, Directeur de division CPS et Argonne Distinguished Fellow. "C'était génial de gérer quelque chose de beaucoup plus gros et plus complexe qui apportera tellement à la communauté."

Alors qu'Argonne travaille à l'arrivée d'Aurora, le futur supercalculateur exascale de l'ALCF, les scientifiques se préparent à des simulations cosmologiques encore plus poussées. Les systèmes informatiques Exascale seront capables d'effectuer un milliard de milliards de calculs par seconde, soit 50 fois plus rapidement que la plupart des supercalculateurs les plus puissants fonctionnant aujourd'hui.

"Nous avons beaucoup appris et adapté au cours de la vie de Mira, et c'est une occasion intéressante de regarder en arrière et de regarder en avant en même temps, " a déclaré Pope. " Lors de la préparation des simulations sur les machines exascale et d'une nouvelle décennie de progrès, nous affinons notre code et nos outils d'analyse, et nous pouvons nous demander ce que nous ne faisions pas à cause des limitations que nous avons eues jusqu'à présent."

The Last Journey était une simulation de gravité uniquement, ce qui signifie qu'il n'a pas pris en compte les interactions telles que la dynamique des gaz et la physique de la formation des étoiles. La gravité est l'acteur majeur de la cosmologie à grande échelle, mais les scientifiques espèrent incorporer d'autres physiques dans les simulations futures pour observer les différences qu'ils font dans la façon dont la matière se déplace et se distribue dans l'univers au fil du temps.

"De plus en plus, nous trouvons des relations étroitement couplées dans le monde physique, et pour simuler ces interactions, les scientifiques doivent développer des workflows créatifs pour le traitement et l'analyse, " dit Riley. " Avec ces itérations, vous êtes en mesure d'arriver à vos réponses et à vos avancées encore plus rapidement."

Un article sur la simulation, intitulé "The Last Journey. I. Une simulation à grande échelle sur le supercalculateur Mira, " a été publié le 27 janvier dans le Série de suppléments de revues astrophysiques . Les scientifiques préparent actuellement des articles de suivi pour générer des catalogues synthétiques détaillés du ciel.