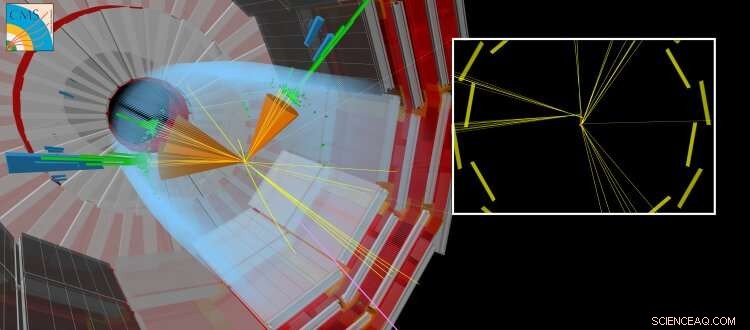

Une collision CMS simulée où une particule à vie longue est produite avec d'autres jets « réguliers ». La particule à vie longue parcourt une courte distance avant de se désintégrer, créant des particules qui semblent déplacées à partir du point où les faisceaux du LHC sont entrés en collision. Crédit :CERN

De nos jours, Les réseaux de neurones artificiels ont un impact sur de nombreux domaines de notre vie quotidienne. Ils sont utilisés pour une grande variété de tâches complexes, comme conduire des voitures, effectuer une reconnaissance vocale (par exemple, Siri, Cortana, Alexa), proposer des articles et tendances shopping, ou améliorer les effets visuels dans les films (par exemple, personnages animés tels que Thanos du film Guerre de l'infini par Marvel).

Traditionnellement, les algorithmes sont fabriqués à la main pour résoudre des tâches complexes. Cela nécessite que les experts consacrent beaucoup de temps à identifier les stratégies optimales pour diverses situations. Les réseaux de neurones artificiels, inspirés des neurones interconnectés du cerveau, peuvent automatiquement apprendre à partir des données une solution presque optimale pour l'objectif donné. Souvent, l'apprentissage automatisé ou « formation » nécessaire à l'obtention de ces solutions est « encadré » grâce à l'utilisation d'informations complémentaires fournies par un expert. D'autres approches sont « non supervisées » et peuvent identifier des modèles dans les données. La théorie mathématique derrière les réseaux de neurones artificiels a évolué sur plusieurs décennies, pourtant, ce n'est que récemment que nous avons développé notre compréhension de la façon de les former efficacement. Les calculs requis sont très similaires à ceux effectués par les cartes graphiques vidéo standard (qui contiennent une unité de traitement graphique ou GPU) lors du rendu de scènes en trois dimensions dans les jeux vidéo. La capacité de former des réseaux de neurones artificiels dans un laps de temps relativement court est rendue possible en exploitant les capacités de calcul massivement parallèles des GPU à usage général. L'industrie florissante du jeu vidéo a entraîné le développement des GPU. Cette avancée, ainsi que les progrès significatifs de la théorie de l'apprentissage automatique et le volume toujours croissant d'informations numérisées, a contribué à inaugurer l'ère de l'intelligence artificielle et du « deep learning ».

Dans le domaine de la physique des hautes énergies, l'utilisation de techniques d'apprentissage automatique, tels que des réseaux de neurones simples ou des arbres de décision, sont utilisés depuis plusieurs décennies. Plus récemment, les communautés théoriques et expérimentales se tournent de plus en plus vers les techniques de pointe, telles que les architectures de réseaux de neurones « profonds », pour nous aider à comprendre la nature fondamentale de notre Univers. Le modèle standard de la physique des particules est un ensemble cohérent de lois physiques - exprimées dans le langage des mathématiques - qui régissent les particules et les forces fondamentales, qui à leur tour expliquent la nature de notre Univers visible. Au CERN LHC, de nombreux résultats scientifiques se concentrent sur la recherche de nouvelles particules « exotiques » qui ne sont pas prédites par le modèle standard. Ces particules hypothétiques sont les manifestations de nouvelles théories qui visent à répondre à des questions telles que :pourquoi l'Univers est-il principalement composé de matière plutôt que d'antimatière, ou quelle est la nature de la matière noire ?

Figure 1 :Schéma de l'architecture du réseau. Les sections supérieures (orange et bleu) du diagramme illustrent les composants du réseau qui sont utilisés pour distinguer les jets produits dans les désintégrations de particules à vie longue des jets produits par d'autres moyens, entraînés avec des données simulées. La partie inférieure (verte) du diagramme montre les composants qui sont entraînés à l'aide de données de collision réelles. Crédit :CERN

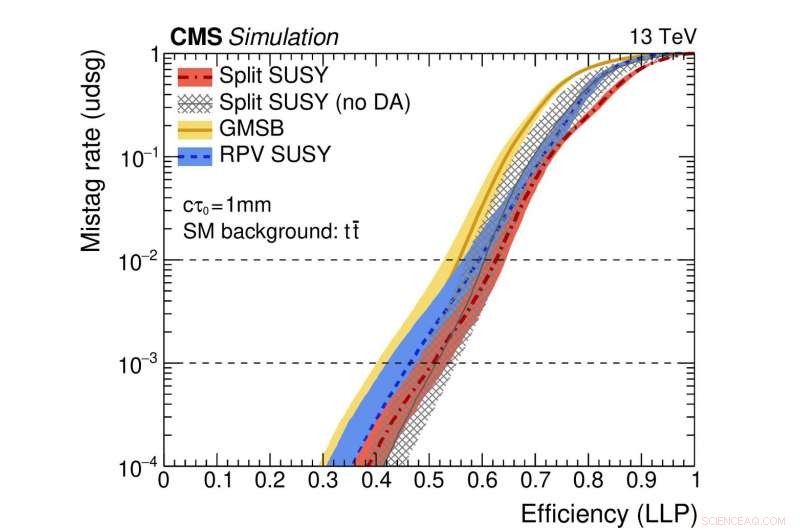

Figure 2 :Une illustration des performances du réseau. Les courbes colorées représentent les performances de différents modèles théoriques supersymétriques. L'axe horizontal donne l'efficacité pour identifier correctement une désintégration de particules à longue durée de vie (c'est-à-dire le taux de vrais positifs). L'axe vertical montre le taux de faux positifs correspondant, qui est la fraction des jets standards identifiés à tort comme provenant de la désintégration d'une particule à vie longue. Par exemple, nous utilisons un point de la courbe rouge où la fraction de véritables particules à vie longue correctement identifiées est de 0,5 (c'est-à-dire 50%). Cette méthode identifie à tort un seul jet régulier sur mille comme provenant d'une désintégration de particules à longue durée de vie. Crédit :CERN

Récemment, les recherches de nouvelles particules qui existent pendant plus d'un instant avant de se désintégrer en particules ordinaires ont fait l'objet d'une attention particulière. Ces particules "à vie longue" peuvent parcourir des distances mesurables (fractions de millimètres ou plus) à partir du point de collision proton-proton dans chaque expérience LHC avant de se désintégrer. Souvent, les prédictions théoriques supposent que la particule à vie longue est indétectable. Dans ce cas, seules les particules issues de la désintégration de la particule non découverte laisseront des traces dans les systèmes de détection, conduisant à la signature expérimentale plutôt atypique de particules apparaissant apparemment de nulle part et déplacées du point de collision.

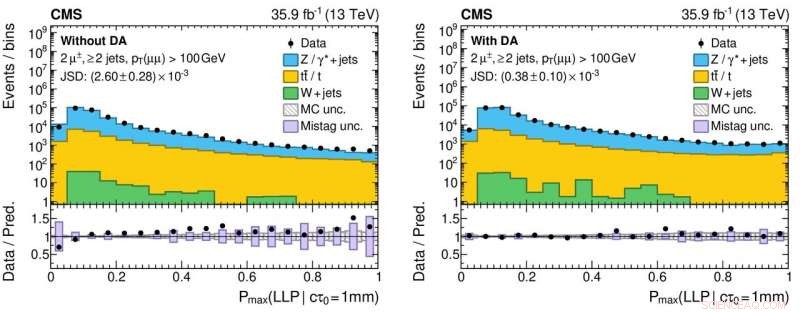

Un aspect nouveau de cette étude implique l'utilisation de données provenant d'événements réels de collision, ainsi que des événements simulés, pour former le réseau. Cette approche est utilisée car la simulation, bien que très sophistiquée, ne reproduit pas de manière exhaustive tous les détails des données réelles de collision. En particulier, les jets résultant des désintégrations de particules à longue durée de vie sont difficiles à simuler avec précision. L'effet de l'application de cette technique, surnommé "adaptation de domaine, " est que les informations fournies par le réseau de neurones conviennent à un haut niveau de précision pour les données de collision réelles et simulées. Ce comportement est un trait crucial pour les algorithmes qui seront utilisés par les recherches de processus rares de nouvelle physique, car les algorithmes doivent démontrer la robustesse et la fiabilité lorsqu'ils sont appliqués aux données.

Figure 3 :Histogrammes des valeurs de sortie du réseau de neurones pour les données de collision proton-proton réelles (marqueurs circulaires noirs) et simulées (histogrammes colorés) sans (panneau de gauche) et avec (panneau de droite) l'application de l'adaptation de domaine. Les panneaux inférieurs affichent les rapports entre les nombres de données réelles et d'événements simulés obtenus à partir de chaque case d'histogramme. Les ratios sont nettement plus proches de l'unité pour le panneau de droite, ce qui indique une meilleure compréhension des performances du réseau neuronal pour les données de collision réelles, ce qui est crucial pour réduire les résultats scientifiques faux positifs (et faux négatifs !) lors de la recherche de nouvelles particules exotiques. Crédit :CERN

La Collaboration CMS déploiera ce nouvel outil dans le cadre de sa recherche permanente d'exotisme, particules à vie longue. Cette étude fait partie d'un plus grand, efforts coordonnés dans toutes les expériences LHC pour utiliser les techniques modernes des machines afin d'améliorer la façon dont les grands échantillons de données sont enregistrés par les détecteurs et l'analyse des données qui s'ensuit. Par exemple, l'utilisation de l'adaptation de domaine peut faciliter le déploiement de modèles robustes appris par machine dans le cadre des résultats futurs. L'expérience acquise grâce à ces types d'études augmentera le potentiel de physique au cours de l'essai 3, à partir de 2021, et au-delà avec le LHC à haute luminosité.