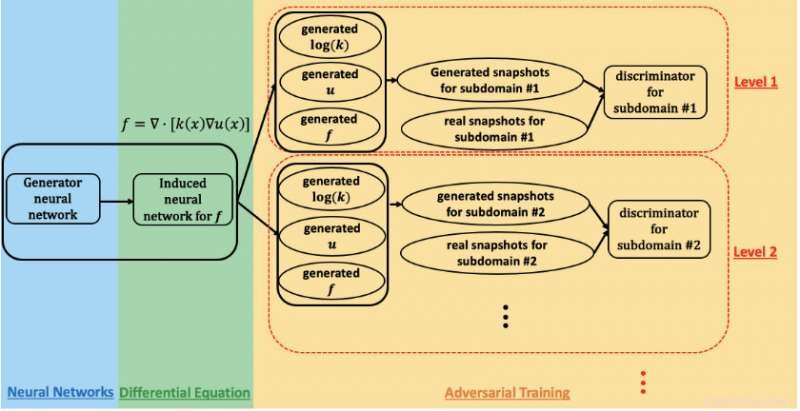

Un schéma du réseau contradictoire génératif basé sur la physique utilisé pour estimer les paramètres et quantifier l'incertitude dans l'écoulement souterrain sur le site de Hanford. Crédit :Prabhat, Laboratoire national Lawrence Berkeley

Une collaboration de recherche entre Lawrence Berkeley National Laboratory (Berkeley Lab), Laboratoire national du nord-ouest du Pacifique (PNNL), Université Brown, et NVIDIA a atteint des performances exaflopiques sur le supercalculateur Summit avec une application d'apprentissage en profondeur utilisée pour modéliser l'écoulement souterrain dans l'étude de la dépollution des déchets nucléaires. Leur réalisation, qui sera présenté lors de l'atelier "Deep Learning on Supercomputers" au SC19, démontre la promesse des réseaux antagonistes génératifs (GAN) éclairés par la physique pour l'analyse de complexes, problèmes scientifiques à grande échelle.

« En science, nous connaissons les lois de la physique et les principes d'observation :masse, élan, énergie, etc., " a déclaré George Karniadakis, professeur de mathématiques appliquées à Brown et co-auteur de l'article de l'atelier SC19. "Le concept des GAN informés par la physique est d'encoder des informations préalables de la physique dans le réseau de neurones. Cela vous permet d'aller bien au-delà du domaine de la formation, ce qui est très important dans les applications où les conditions peuvent changer."

Les GAN ont été appliqués pour modéliser l'apparence du visage humain avec une précision remarquable, a noté Prabhat, un co-auteur de l'article SC19 qui dirige l'équipe des services de données et d'analyse au Centre national de calcul scientifique de la recherche énergétique de Berkeley Lab. "Dans la science, Berkeley Lab a exploré l'application des GAN vanille pour créer des univers synthétiques et des expériences de physique des particules; l'un des défis ouverts jusqu'à présent a été l'incorporation de contraintes physiques dans les prédictions, ", a-t-il déclaré. "George et son groupe à Brown ont été les pionniers de l'approche consistant à incorporer la physique dans les GAN et à les utiliser pour synthétiser des données - dans ce cas, champs d'écoulement souterrains."

Pour cette étude, les chercheurs se sont concentrés sur le site de Hanford, créé en 1943 dans le cadre du projet Manhattan pour produire du plutonium pour les armes nucléaires et finalement abriter le premier réacteur de production de plutonium à grande échelle au monde, huit autres réacteurs nucléaires, et cinq complexes de traitement du plutonium. Lorsque la production de plutonium a pris fin en 1989, il reste des dizaines de millions de gallons de déchets radioactifs et chimiques dans de grands réservoirs souterrains et plus de 100 milles carrés d'eaux souterraines contaminées résultant de l'élimination d'environ 450 milliards de gallons de liquides dans des sites d'élimination des sols. Ainsi, au cours des 30 dernières années, le département américain de l'Énergie a travaillé avec l'Environmental Protection Agency et le Washington State Department of Ecology pour nettoyer Hanford, qui est situé sur 580 miles carrés (près de 500, 000 acres) dans le centre-sud de Washington, des parties entières adjacentes au fleuve Columbia, le plus grand fleuve du nord-ouest du Pacifique et une artère essentielle pour l'industrie et la faune.

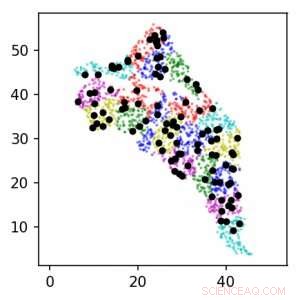

En utilisant des GAN basés sur la physique sur le supercalculateur Summit, l'équipe de recherche a pu estimer les paramètres et quantifier l'incertitude dans l'écoulement souterrain. Cette image montre les emplacements des capteurs autour du site de Hanford pour les niveaux 1 (noir) et 2 (couleur). Les unités sont en km. Crédit :Lawrence Berkeley National Laboratory

Pour suivre l'effort de nettoyage, les travailleurs se sont appuyés sur le forage de puits sur le site de Hanford et sur l'installation de capteurs dans ces puits pour recueillir des données sur les propriétés géologiques et l'écoulement des eaux souterraines et observer la progression des contaminants. Les environnements souterrains comme le site de Hanford sont très hétérogènes avec des propriétés spatiales variables, a expliqué Alex Tartakovsky, mathématicien computationnel au PNNL et co-auteur de l'article SC19. « Estimer les propriétés du site de Hanford à partir de données uniquement nécessiterait plus d'un million de mesures, et en pratique, nous en avons peut-être un millier. Les lois de la physique nous aident à compenser le manque de données."

« L'approche standard d'estimation des paramètres consiste à supposer que les paramètres peuvent prendre de nombreuses formes différentes, et ensuite, pour chaque forme, vous devez résoudre des équations d'écoulement souterrain peut-être des millions de fois pour déterminer les paramètres correspondant le mieux aux observations, " a ajouté Tartakovsky. Mais pour cette étude, l'équipe de recherche a adopté une approche différente :utiliser un GAN basé sur la physique et un calcul haute performance pour estimer les paramètres et quantifier l'incertitude dans l'écoulement souterrain.

Pour ce travail de validation précoce, les chercheurs ont choisi d'utiliser des données synthétiques, des données générées par un modèle calculé basé sur les connaissances d'experts sur le site de Hanford. Cela leur a permis de créer une représentation virtuelle du site qu'ils pouvaient ensuite manipuler au besoin en fonction des paramètres qu'ils souhaitaient mesurer, principalement la conductivité hydraulique et la charge hydraulique, ces deux éléments sont essentiels à la modélisation de l'emplacement des contaminants. Les études futures intégreront des données de capteurs réels et des conditions réelles.

"Le but initial de ce projet était d'estimer la précision des méthodes, nous avons donc utilisé des données synthétiques au lieu de mesures réelles, " a déclaré Tartakovsky. "Cela nous a permis d'estimer les performances du GANS basé sur la physique en fonction du nombre de mesures."

En formant le GAN sur le supercalculateur Summit à l'Oak Ridge Leadership Computing Facility OLCF, l'équipe a pu atteindre un pic de 1,2 exaflop et des performances soutenues, le premier exemple d'une architecture GAN à grande échelle appliquée aux SPDE. L'étendue géographique, hétérogénéité spatiale, et les échelles de longueur de corrélation multiples du site de Hanford ont nécessité la formation du modèle GAN à des milliers de dimensions, l'équipe a donc développé une implémentation hautement optimisée qui est passée à 27, 504 GPU NVIDIA V100 Tensor Core et 4, 584 nœuds sur Summit avec une efficacité de mise à l'échelle de 93,1 %.

« Atteindre une échelle et des performances aussi massives nécessitait une optimisation complète de la pile et plusieurs stratégies pour extraire un parallélisme maximal, " a déclaré Mike Houston, qui dirige l'équipe AI Systems chez NVIDIA. "Au niveau de la puce, nous avons optimisé la structure et la conception du réseau de neurones pour maximiser l'utilisation de Tensor Core via la prise en charge de cuDNN dans TensorFlow. Au niveau du nœud, nous avons utilisé NCCL et NVLink pour l'échange de données à haute vitesse. Et au niveau du système, nous avons optimisé Horovod et MPI non seulement pour combiner les données et les modèles, mais aussi pour gérer les stratégies parallèles de l'adversaire. Pour maximiser l'utilisation de nos GPU, nous avons dû fragmenter les données, puis les distribuer pour les aligner sur la technique de parallélisation."

« C'est un nouveau record pour les architectures GAN, " a déclaré Prabhat. " Nous voulions créer un substitut peu coûteux pour une simulation très coûteuse, et ce que nous avons pu montrer ici, c'est qu'une architecture GAN contrainte par la physique peut produire des champs spatiaux cohérents avec notre connaissance de la physique. En outre, ce projet exemplaire a réuni des experts de la modélisation du sous-sol, mathématiques appliquées, l'apprentissage en profondeur, et HPC. Alors que le DOE envisage des applications plus larges de l'apprentissage en profondeur - et, en particulier, GAN — aux problèmes de simulation, Je m'attends à ce que plusieurs équipes de recherche soient inspirées par ces résultats."

Le papier, "Très évolutif, GAN éclairés par la physique pour les solutions d'apprentissage des EDP stochastiques, " sera présenté à l'atelier SC19 Deep Learning on Supercomputers. I