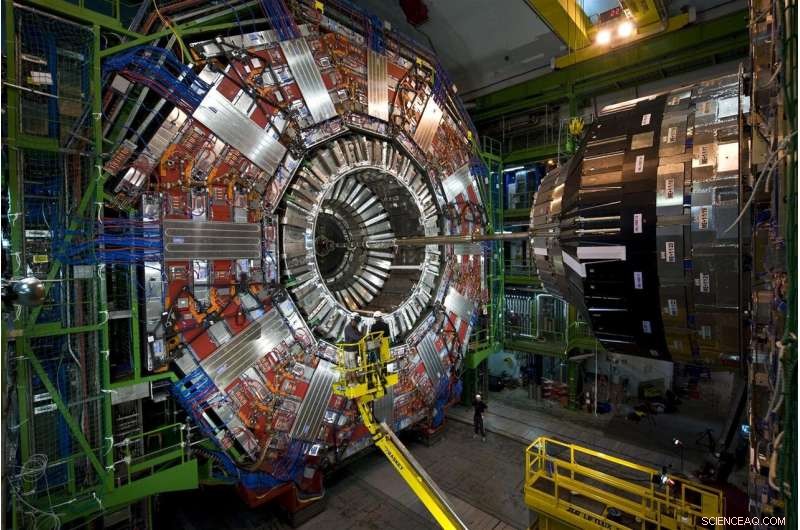

Les particules émergeant des collisions de protons au Grand collisionneur de hadrons du CERN traversent cette hauteur, instrument à plusieurs niveaux, le détecteur CMS. En 2026, le LHC produira 20 fois plus de données qu'il ne le fait actuellement, et CMS est actuellement en cours de mise à niveau pour lire et traiter le déluge de données. Crédit :Maximilien Brice, CERN

Chaque collision de protons au Large Hadron Collider est différente, mais seuls quelques-uns sont spéciaux. Les collisions spéciales génèrent des particules dans des motifs inhabituels, manifestations possibles de nouvelles, physique qui brise les règles ou aide à compléter notre image incomplète de l'univers.

Trouver ces collisions est plus difficile que la recherche proverbiale de l'aiguille dans la botte de foin. Mais une aide qui change la donne est en route. Les scientifiques du Fermilab et d'autres collaborateurs ont testé avec succès un prototype de technologie d'apprentissage automatique qui accélère le traitement de 30 à 175 fois par rapport aux méthodes traditionnelles.

Face à 40 millions de collisions chaque seconde, les scientifiques du LHC utilisent de puissants, des ordinateurs agiles pour cueillir les pierres précieuses - qu'il s'agisse d'une particule de Higgs ou d'indices de matière noire - de la vaste statique des collisions ordinaires.

En parcourant les données de collisions simulées du LHC, la technologie d'apprentissage automatique a appris avec succès à identifier un modèle de post-collision particulier - un jet particulier de particules volant à travers un détecteur - alors qu'il parcourait 600 images par seconde. Les méthodes traditionnelles traitent moins d'une image par seconde.

La technologie pourrait même être proposée en tant que service sur des ordinateurs externes. L'utilisation de ce modèle de déchargement permettrait aux chercheurs d'analyser plus de données plus rapidement et de laisser plus d'espace de calcul au LHC disponible pour effectuer d'autres travaux.

C'est un aperçu prometteur de la façon dont les services d'apprentissage automatique prennent en charge un domaine dans lequel des quantités déjà énormes de données ne feront qu'augmenter.

Le défi :plus de données, plus de puissance de calcul

Les chercheurs améliorent actuellement le LHC pour écraser des protons à cinq fois son taux actuel. D'ici 2026, la machine souterraine circulaire de 17 milles du laboratoire européen CERN produira 20 fois plus de données qu'aujourd'hui.

CMS est l'un des détecteurs de particules du Grand collisionneur de hadrons, et les collaborateurs CMS sont au milieu de leurs propres mises à niveau, permettant le complexe, instrument haut de gamme pour prendre des photos plus sophistiquées des collisions de particules du LHC. Le Fermilab est le laboratoire américain principal pour l'expérience CMS.

Si les scientifiques du LHC voulaient sauvegarder toutes les données brutes de collision qu'ils recueilleraient en un an à partir du LHC à haute luminosité, ils devraient trouver un moyen de stocker environ 1 exaoctet (environ 1 000 milliards de disques durs externes personnels), dont seul un éclat peut dévoiler de nouveaux phénomènes. Les ordinateurs du LHC sont programmés pour sélectionner cette petite fraction, prendre des décisions en une fraction de seconde sur les données qui sont suffisamment précieuses pour être envoyées en aval pour une étude plus approfondie.

Actuellement, le système informatique du LHC en conserve environ un sur 100, 000 événements de particules. Mais les protocoles de stockage actuels ne seront pas en mesure de faire face à la future inondation de données, qui s'accumuleront au fil des décennies de prise de données. Et les images à plus haute résolution capturées par le détecteur CMS amélioré ne faciliteront pas le travail. Tout cela se traduit par un besoin en ressources de calcul 10 fois supérieur à celui dont dispose actuellement le LHC.

Les physiciens des particules explorent l'utilisation d'ordinateurs dotés de capacités d'apprentissage automatique pour le traitement d'images de collisions de particules à CMS, leur apprendre à identifier rapidement divers modèles de collision. Crédit :Eamonn Maguire/Antarctique Design

Le récent test du prototype montre que, avec les avancées du machine learning et du matériel informatique, les chercheurs espèrent pouvoir exploiter les données issues du prochain LHC à haute luminosité lorsqu'il sera mis en ligne.

"L'espoir ici est que vous puissiez faire des choses très sophistiquées avec l'apprentissage automatique et les faire aussi plus rapidement, " dit Nhan Tran, un scientifique du Fermilab sur l'expérience CMS et l'un des responsables du récent test. "C'est important, car nos données deviendront de plus en plus complexes avec des détecteurs améliorés et des environnements de collision plus fréquentés."

L'apprentissage automatique à la rescousse :la différence d'inférence

L'apprentissage automatique en physique des particules n'est pas nouveau. Les physiciens utilisent l'apprentissage automatique pour chaque étape du traitement des données dans une expérience de collisionneur.

Mais avec la technologie d'apprentissage automatique qui peut analyser les données du LHC jusqu'à 175 fois plus rapidement que les méthodes traditionnelles, les physiciens des particules franchissent une étape décisive dans la voie du calcul de collision.

Les taux rapides sont grâce à un matériel intelligemment conçu dans la plate-forme, Azure ML de Microsoft, ce qui accélère un processus appelé inférence.

Pour comprendre l'inférence, Considérons un algorithme qui a été formé pour reconnaître l'image d'une moto :l'objet a deux roues et deux poignées qui sont attachées à un corps métallique plus grand. L'algorithme est assez intelligent pour savoir qu'une brouette, qui a des attributs similaires, n'est pas une moto. Au fur et à mesure que le système scanne de nouvelles images d'autres deux-roues, objets à deux poignées, il prédit ou déduit quelles sont les motos. Et comme les erreurs de prédiction de l'algorithme sont corrigées, il devient assez habile pour les identifier. Un milliard de scans plus tard, c'est sur son jeu d'inférence.

La plupart des plates-formes d'apprentissage automatique sont conçues pour comprendre comment classer les images, mais pas d'images spécifiques à la physique. Les physiciens doivent leur apprendre la partie physique, comme la reconnaissance des traces créées par le boson de Higgs ou la recherche d'indices de matière noire.

Chercheurs du Fermilab, CERN, MIT, l'Université de Washington et d'autres collaborateurs ont formé Azure ML pour identifier des images de quarks top - une particule élémentaire à courte durée de vie qui est environ 180 fois plus lourde qu'un proton - à partir de données CMS simulées. Spécifiquement, Azure devait rechercher des images de jets de quarks supérieurs, nuages de particules extraits du vide par un seul quark top s'éloignant de la collision.

"Nous lui avons envoyé les images, l'entraîner sur des données physiques, " a déclaré le scientifique du Fermilab Burt Holzman, un chef de file sur le projet. "Et il présentait des performances de pointe. Il était très rapide. Cela signifie que nous pouvons pipeliner un grand nombre de ces choses. En général, ces techniques sont plutôt bonnes."

L'une des techniques derrière l'accélération d'inférence est de combiner des processeurs traditionnels avec des processeurs spécialisés, un mariage connu sous le nom d'architecture informatique hétérogène.

Les données des expériences de physique des particules sont stockées dans des fermes informatiques comme celle-ci, le Grid Computing Center du Laboratoire Fermi. Des organisations extérieures proposent leurs fermes de calcul au service d'expériences de physique des particules, rendre plus d'espace disponible sur les serveurs des expériences. Crédit :Reidar Hahn

Différentes plates-formes utilisent différentes architectures. Les processeurs traditionnels sont des CPU (unités centrales de traitement). Les processeurs spécialisés les plus connus sont les GPU (graphics processing units) et les FPGA (field programmable gate arrays). Azure ML combine des CPU et des FPGA.

"La raison pour laquelle ces processus doivent être accélérés est que ce sont de gros calculs. Vous parlez de 25 milliards d'opérations, " dit Tran. " En l'installant sur un FPGA, mapper cela sur, et le faire dans un laps de temps raisonnable est un véritable exploit."

Et ça commence à être proposé en tant que service, trop. Le test était la première fois que quelqu'un démontrait comment ce genre d'hétérogénéité, L'architecture en tant que service peut être utilisée pour la physique fondamentale.

Dans le monde informatique, utiliser quelque chose "en tant que service" a une signification spécifique. Une organisation externe fournit des ressources (machine learning ou matériel) en tant que service, et les utilisateurs, les scientifiques, puisent dans ces ressources en cas de besoin. C'est similaire à la façon dont votre entreprise de streaming vidéo fournit des heures de binge-watching TV en tant que service. Vous n'avez pas besoin de posséder vos propres DVD et lecteur DVD. Vous utilisez plutôt leur bibliothèque et leur interface.

Les données du Grand collisionneur de hadrons sont généralement stockées et traitées sur des serveurs informatiques au CERN et dans des institutions partenaires telles que le Fermilab. Avec l'apprentissage automatique offert aussi facilement que n'importe quel autre service Web, des calculs intensifs peuvent être effectués partout où le service est offert, y compris hors site. Cela renforce les capacités des laboratoires avec une puissance de calcul et des ressources supplémentaires tout en leur évitant d'avoir à fournir leurs propres serveurs.

"L'idée de faire de l'informatique accélérée existe depuis des décennies, mais le modèle traditionnel consistait à acheter un cluster informatique avec des GPU et à l'installer localement au labo, " a déclaré Holzman. " L'idée de décharger le travail vers une ferme hors site avec du matériel spécialisé, fournir l'apprentissage automatique en tant que service, qui a fonctionné comme annoncé."

La batterie de serveurs Azure ML se trouve en Virginie. Cela ne prend que 100 millisecondes pour les ordinateurs du Fermilab près de Chicago, Illinois, d'envoyer une image d'un événement particule vers le cloud Azure, traiter, et le retourner. C'est un 2, 500 kilomètres, voyage riche en données en un clin d'œil.

"La plomberie qui va avec tout ça est une autre réalisation, " Tran dit. " Le concept d'abstraire ces données comme une chose que vous venez d'envoyer ailleurs, et ça revient juste, était la chose la plus agréablement surprenante de ce projet. Nous n'avons pas à tout remplacer dans notre propre centre informatique par tout un tas de nouveautés. On garde tout, envoyez les calculs difficiles et faites-le revenir plus tard."

Les scientifiques sont impatients de faire évoluer la technologie pour relever d'autres défis liés aux mégadonnées au LHC. Ils prévoient également de tester d'autres plateformes, comme Amazon AWS, Google Cloud et IBM Cloud, alors qu'ils explorent ce qui peut être accompli d'autre grâce à l'apprentissage automatique, qui a connu une évolution rapide au cours des dernières années.

« Les modèles qui étaient à la pointe de la technologie pour 2015 sont aujourd'hui de série, " dit Tran.

Comme un outil, L'apprentissage automatique continue de donner à la physique des particules de nouvelles façons d'entrevoir l'univers. C'est aussi impressionnant en soi.

"Que nous pouvons prendre quelque chose qui est entraîné pour faire la distinction entre les images d'animaux et de personnes, faire un calcul de montant modeste, et qu'il me dise la différence entre un jet de quark top et un arrière-plan ?", a déclaré Holzman. « C'est quelque chose qui m'épate. »