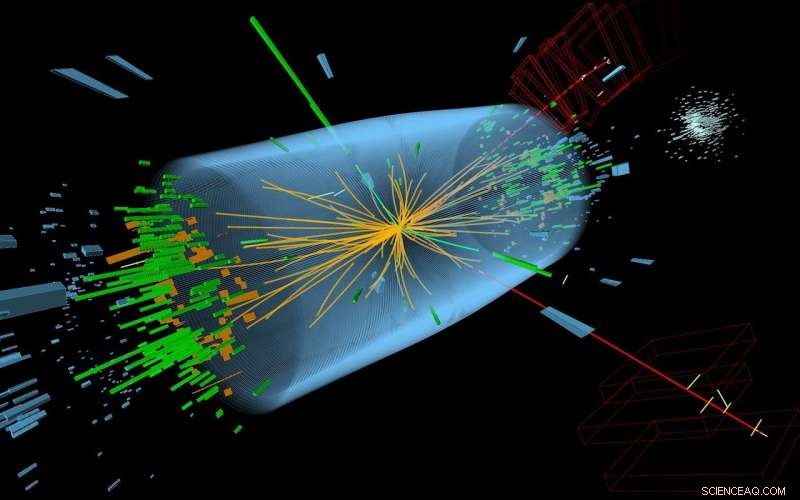

Pour démontrer que DEFT peut être appliqué à une variété de petits ensembles de données, Les scientifiques du CSHL l'ont utilisé pour analyser les données du détecteur CMS Higgs Boson. Sur 60 empreintes particulaires, DEFT a estimé que jusqu'à six provenaient d'événements réels. (Sur la photo :une perspective 3D d'un événement du boson de Higgs enregistré en 2012. Les impressions sont caractérisées par des tours vertes et des lignes rouges.) Crédit :McCauley, T ; Taylor, L ; CERN

Le Big Data est à la mode aujourd'hui, mais Small Data compte aussi ! Tirer des conclusions fiables à partir de petits ensembles de données, comme ceux issus d'essais cliniques de maladies rares ou d'études sur des espèces menacées, reste l'un des obstacles les plus délicats en statistique. Maintenant, Les chercheurs du Cold Spring Harbor Laboratory (CSHL) ont développé une nouvelle façon d'analyser de petites données, une inspirée des méthodes avancées de la physique théorique, mais disponible en tant que logiciel facile à utiliser.

« Traiter de petits ensembles de données est une partie fondamentale de la science, " Le professeur adjoint du CSHL, Justin Kinney, a expliqué. Le défi est que, avec très peu de données, ce n'est pas seulement difficile d'arriver à une conclusion; il est également difficile de déterminer le degré de certitude de vos conclusions.

"Il est important non seulement de produire la meilleure estimation de ce qui se passe, mais aussi dire, 'Cette supposition est probablement correcte, '", a déclaré Kinney.

Les essais cliniques de médicaments en sont un bon exemple.

"Lorsque chaque point de données est un patient, vous aurez toujours affaire à de petits ensembles de données, et pour de très bonnes raisons, " Il a dit. " Vous ne voulez pas tester un traitement sur plus de personnes que nécessaire avant de déterminer si le médicament est sûr et efficace. Il est vraiment important de pouvoir prendre ces décisions avec le moins de données possible."

Il a été difficile de quantifier cette certitude en raison des hypothèses formulées par les méthodes statistiques courantes. Ces hypothèses étaient nécessaires à l'époque où les méthodes standard ont été développées, avant l'ère informatique. Mais ces approximations, Kinney note, « peut être catastrophique » sur de petits ensembles de données.

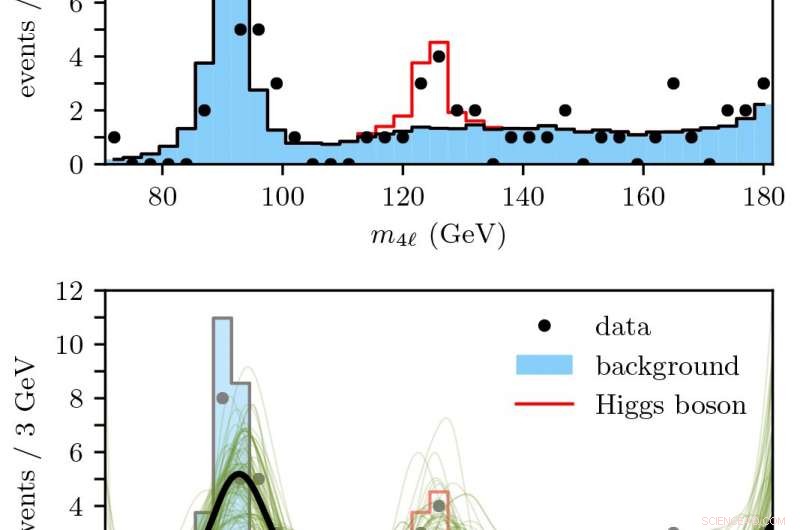

En haut :nombre d'événements de particules du boson de Higgs attendus sur la base des simulations du modèle standard.

En bas :DEFT a été utilisé pour prédire en douceur (noir) combien d'événements de désintégration de 4 leptons étaient des indicateurs d'un véritable événement du boson de Higgs dans une marge d'incertitude (vert). Crédit :Kinney Lab/CSHL

Maintenant, Le laboratoire de Kinney a conçu une approche informatique moderne appelée Density Estimation using Field Theory, ou DEFT, qui corrige ces lacunes. DEFT est disponible gratuitement via un package open source appelé SUFTware.

Dans leur récent article, Publié dans Lettres d'examen physique , Le laboratoire de Kinney démontre la DEFT sur deux ensembles de données :les statistiques nationales sur la santé compilées par l'Organisation mondiale de la santé, et des traces de particules subatomiques utilisées par les physiciens du Grand collisionneur de hadrons pour révéler l'existence de la particule du boson de Higgs.

Kinney dit que la possibilité d'appliquer DEFT à des situations « du monde réel » aussi radicalement diverses – malgré ses calculs inspirés de la physique théorique – est ce qui rend la nouvelle approche si puissante.

"La flexibilité est une très bonne chose... Nous adaptons maintenant DEFT aux problèmes d'analyse de survie, le type de statistiques utilisées dans les essais cliniques, " a déclaré Kinney. " Ces nouvelles fonctionnalités vont être ajoutées à SUFTware alors que nous continuons à développer cette nouvelle approche des statistiques. "