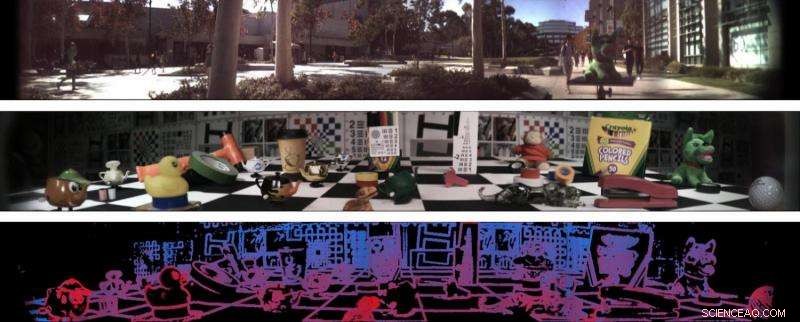

Deux panoramas de champ lumineux à 138 degrés (en haut et au centre) et une estimation de la profondeur du deuxième panorama (en bas). Crédit:Stanford Computational Imaging Lab et Photonic Systems Integration Laboratory à UC San Diego

Des ingénieurs de l'Université de Stanford et de l'Université de Californie à San Diego ont développé une caméra qui génère des images en quatre dimensions et peut capturer 138 degrés d'informations. Le nouvel appareil photo, le tout premier objectif unique, large champ de vision, caméra de champ lumineux - pourrait générer des images et des trames vidéo riches en informations qui permettront aux robots de mieux naviguer dans le monde et de comprendre certains aspects de leur environnement, telles que la distance de l'objet et la texture de la surface.

Les chercheurs voient également cette technologie être utilisée dans les véhicules autonomes et les technologies de réalité augmentée et virtuelle. Les chercheurs ont présenté leur nouvelle technologie lors de la conférence sur la vision par ordinateur CVPR 2017 en juillet.

« Nous voulons déterminer quelle serait la bonne caméra pour un robot qui conduit ou livre des colis par voie aérienne. Nous sommes excellents pour fabriquer des caméras pour les humains, mais les robots ont-ils besoin de voir la façon dont les humains le font ? Probablement pas, " a déclaré Donald Dansereau, un boursier postdoctoral en génie électrique à Stanford et le premier auteur de l'article.

Le projet est une collaboration entre les laboratoires des professeurs de génie électrique Gordon Wetzstein à Stanford et Joseph Ford à UC San Diego.

Les chercheurs de l'UC San Diego ont conçu un objectif sphérique qui offre à la caméra un champ de vision extrêmement large, englobant près d'un tiers du cercle autour de la caméra. Le groupe de Ford avait précédemment développé les lentilles sphériques dans le cadre du programme DARPA "SCENICC" (Soldier CENTric Imaging with Computational Cameras) pour construire une caméra vidéo compacte qui capture des images à 360 degrés en haute résolution, avec 125 mégapixels dans chaque image vidéo. Dans ce projet, la caméra vidéo utilisait des faisceaux de fibres optiques pour coupler les images sphériques à des plans focaux plats conventionnels, fournir des performances élevées mais à un coût élevé.

La nouvelle caméra utilise une version des lentilles sphériques qui élimine les faisceaux de fibres grâce à une combinaison de petites lentilles et de traitement du signal numérique. La combinaison de l'expertise matérielle de conception optique et d'intégration de système du laboratoire de Ford et de l'expertise en traitement du signal et algorithmique du laboratoire de Wetzstein a abouti à une solution numérique qui non seulement conduit à la création de ces images extra-larges, mais les améliore.

Le nouvel appareil photo repose également sur une technologie développée à Stanford appelée photographie en champ lumineux, c'est ce qui ajoute une quatrième dimension à cette caméra :elle capture la direction sur deux axes de la lumière frappant l'objectif et combine ces informations avec l'image 2D. Une autre caractéristique remarquable de la photographie en champ lumineux est qu'elle permet aux utilisateurs de recentrer les images après leur prise, car les images contiennent des informations sur la position et la direction de la lumière. Les robots pourraient utiliser cette technologie pour voir à travers la pluie et d'autres choses qui pourraient obscurcir leur vision.

"L'une des choses que vous réalisez lorsque vous travaillez avec une caméra omnidirectionnelle est qu'il est impossible de faire la mise au point dans toutes les directions à la fois - quelque chose est toujours proche de la caméra, tandis que d'autres choses sont loin, " Ford a déclaré. " L'imagerie par champ lumineux permet de recentrer la vidéo capturée pendant la relecture, ainsi que la cartographie de profondeur à ouverture unique de la scène. Ces capacités ouvrent toutes sortes d'applications en VR et en robotique."

« Cela pourrait permettre à divers types de technologies artificiellement intelligentes de comprendre à quelle distance se trouvent les objets, s'ils bougent et de quoi ils sont faits, " a déclaré Wetzstein. " Ce système pourrait être utile dans n'importe quelle situation où vous avez un espace limité et vous voulez que l'ordinateur comprenne le monde entier qui l'entoure. "

Et bien que cette caméra puisse fonctionner comme une caméra conventionnelle à de grandes distances, il est également conçu pour améliorer les images en gros plan. Des exemples où cela serait particulièrement utile incluent les robots qui doivent naviguer dans de petites zones, drones d'atterrissage et voitures autonomes. Dans le cadre d'un système de réalité augmentée ou virtuelle, ses informations de profondeur pourraient entraîner des rendus plus homogènes de scènes réelles et prendre en charge une meilleure intégration entre ces scènes et les composants virtuels.

La caméra est actuellement au stade de la validation de principe et l'équipe envisage de créer un prototype compact à tester sur un robot.