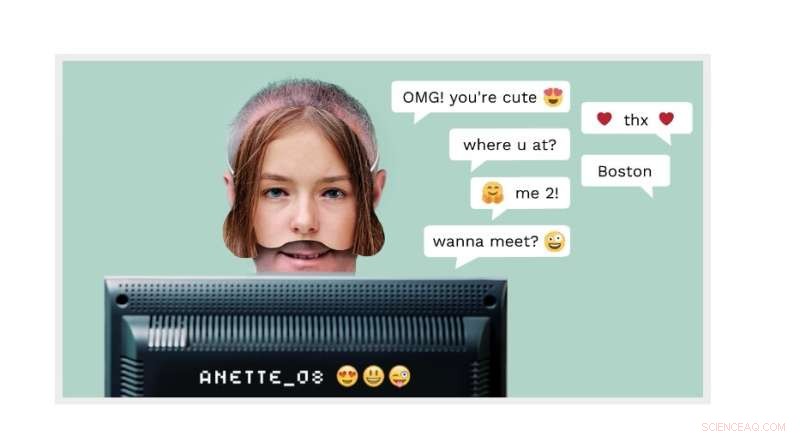

Cybergrooming :Un homme adulte peut se faire passer pour un garçon de 14 ans en ligne. Désormais, la technologie de détection NTNU utilisée dans une spin-off commerciale appelée AiBA peut détecter l'auteur. Crédit :page d'accueil AiBA

Des millions d'enfants se connectent chaque jour à des forums de discussion pour parler avec d'autres enfants. L'un de ces "enfants" pourrait bien être un homme prétendant être une fille de 12 ans avec des intentions bien plus sinistres que de discuter des épisodes de "My Little Pony".

L'inventeur et professeur NTNU Patrick Bours de l'AiBA s'efforce de prévenir ce type de comportement prédateur. AiBA, un modérateur numérique basé sur l'IA que Bours a aidé à trouver, peut proposer un outil basé sur la biométrie comportementale et des algorithmes qui détectent les agresseurs sexuels dans les chats en ligne avec des enfants.

Et maintenant, comme l'a récemment rapporté Dagens Næringsliv, un journal financier national, la société a levé un capital de 7,5 NOK. millions, avec des investisseurs tels que Firda et Wiski Capital, deux sociétés basées en Norvège.

Dans ses efforts les plus récents, la société travaille avec 50 millions de lignes de chat pour développer un outil qui trouvera des conversations à haut risque où les agresseurs essaient d'entrer en contact avec des enfants. L'objectif est d'identifier les caractéristiques distinctives de ce que les agresseurs laissent derrière eux sur les plateformes de jeux et sur les réseaux sociaux.

"Nous ciblons les principaux producteurs de jeux et espérons obtenir quelques centaines de jeux sur la plate-forme", a déclaré Hege Tokerud, co-fondateur et directeur général, à Dagens Næringsliv.

Le cybergrooming est un problème croissant

Le cybergrooming, c'est quand des adultes se lient d'amitié avec des enfants en ligne, souvent en utilisant un faux profil.

Cependant, "certains prédateurs sexuels viennent tout de suite et demandent si l'enfant est intéressé à discuter avec une personne plus âgée, donc il n'y a pas besoin d'une fausse identité", a déclaré Bours.

Le but de l'agresseur est souvent d'attirer les enfants sur une chaîne privée afin que les enfants puissent envoyer des photos d'eux-mêmes, avec et sans vêtements, et peut-être éventuellement prendre rendez-vous avec le jeune.

Les auteurs ne se soucient pas autant d'envoyer des photos d'eux-mêmes, a déclaré Bours. "L'exhibitionnisme n'est qu'une petite partie de leur motivation", a-t-il déclaré. "Obtenir des images est beaucoup plus intéressant pour eux, et pas seulement des images fixes, mais des images en direct via une webcam."

"Superviser toutes ces conversations pour empêcher les abus est impossible pour les modérateurs qui surveillent le système manuellement. Ce qu'il faut, c'est une automatisation qui avertit les modérateurs de la conversation en cours", déclare Bours.

AiBA a développé un système utilisant plusieurs algorithmes qui offre aux grandes entreprises de chat un outil capable de discerner si des adultes ou des enfants discutent. C'est là qu'intervient la biométrie comportementale.

Un homme adulte peut prétendre être un garçon de 14 ans en ligne. Mais sa façon d'écrire, comme son rythme de frappe ou son choix de mots, peut révéler qu'il est un homme adulte.

Clé d'apprentissage automatique

L'outil AiBA utilise des méthodes d'apprentissage automatique pour analyser tous les chats et évaluer le risque en fonction de certains critères. Le niveau de risque peut monter et descendre un peu pendant la conversation au fur et à mesure que le système évalue chaque message. Le symbole d'avertissement rouge illumine le chat si le niveau de risque devient trop élevé, informant le modérateur qui peut alors regarder la conversation et l'évaluer plus avant.

De cette façon, les algorithmes peuvent détecter les conversations qui doivent être vérifiées pendant qu'elles sont en cours, plutôt qu'après, lorsque les dommages ou l'abus pourraient déjà s'être produits. Les algorithmes servent alors de signal d'alerte.

Froid et cynique

Bours a analysé de nombreuses conversations de chat à partir d'anciens journaux pour développer l'algorithme.

"En analysant ces conversations, nous apprenons comment de tels hommes "soignent" les destinataires avec des compliments, des cadeaux et autres flatteries, de sorte qu'ils en révèlent de plus en plus. C'est froid, cynique et soigneusement planifié", dit-il. "L'examen des chats fait également partie du processus d'apprentissage, de sorte que nous pouvons améliorer l'IA et la faire mieux réagir à l'avenir."

"Le danger que ce type de contact se termine par une agression est élevé, surtout si l'agresseur envoie le destinataire sur d'autres plates-formes avec vidéo, par exemple. Dans une situation en direct, l'algorithme marquerait ce chat comme celui qui doit être surveillé ."

Analyse en temps réel

"L'objectif est d'exposer un agresseur le plus rapidement possible", explique Bours.

"Si nous attendons la fin de toute la conversation et que les interlocuteurs ont déjà conclu un accord, il pourrait être trop tard. Le moniteur peut également dire à l'enfant dans le chat qu'il parle à un adulte et non à un autre enfant."

AiBA a collaboré avec des sociétés de jeux pour installer l'algorithme et travaille avec une plateforme de jeu et de chat danoise appelée MoviestarPlanet, qui s'adresse aux enfants et compte 100 millions de joueurs.

En développant les algorithmes, le chercheur a découvert que les utilisateurs écrivaient différemment sur différentes plateformes telles que Snapchat et TikTok.

"Nous devons tenir compte de ces distinctions lorsque nous formons l'algorithme. Il en va de même pour le langage. Le service doit être développé pour tous les types de langage", explique Bours.

Examiner les modèles de chat

Plus récemment, Bours et ses collègues ont examiné les modèles de chat pour voir quels modèles s'écartent de ce qui serait considéré comme normal.

"Nous avons analysé les modèles de chat (et non les textes) de 2,5 millions de chats, et avons pu trouver plusieurs cas de toilettage qui n'auraient pas été détectés autrement", a déclaré Bours.

"Cette recherche initiale a examiné les données rétrospectivement, mais nous étudions actuellement comment nous pouvons les utiliser dans un système qui suit directement ces modèles de chat et peut prendre des décisions immédiates pour signaler un utilisateur à un modérateur", a-t-il déclaré. Microsoft cherche à détecter les prédateurs sexuels dans les chats de jeux vidéo