Crédit :Tautkutè &Trzcinski

Des chercheurs de l'Académie polono-japonaise des technologies de l'information et de l'Université de technologie de Varsovie ont développé un modèle de réseau d'alignement profond (DAN) pour classer et visualiser les émotions. Leur méthode s'est avérée surpasser les méthodes de classification des émotions de pointe sur deux ensembles de données de référence.

Développer des modèles capables de reconnaître et de classer les émotions humaines est un défi majeur dans le domaine de l'apprentissage automatique et de la vision par ordinateur. La plupart des outils de reconnaissance des émotions existants utilisent des réseaux convolutifs multicouches, qui n'impliquent pas explicitement les traits du visage dans la phase de classification.

Ivona Tautkute et Tomasz Trzcinski, les chercheurs qui ont mené la récente étude, travaillaient initialement sur un système pour une startup californienne qui pourrait être intégré dans des voitures autonomes. Ce système a pu compter les passagers sur la base des données extraites d'une seule caméra vidéo montée à l'intérieur de la voiture.

À un stade ultérieur, les deux chercheurs ont commencé à explorer des modèles qui pourraient faire plus que cela, créer des statistiques plus larges sur les passagers en estimant leur âge et leur sexe. Une extension évidente de ce système était pour lui de détecter les expressions faciales et les émotions, également.

"Comme le système devait être utilisé avec des passagers âgés, il était important de capturer les émotions négatives et positives associées au désengagement du conducteur, " a expliqué Tautkute. " Les approches existantes pour la reconnaissance des émotions sont loin d'être parfaites, nous avons donc commencé à chercher de nouvelles façons intéressantes de nous améliorer. Une idée nous est venue après une discussion avec un collègue chercheur en vision par ordinateur, Marek Kowalski, qui travaillait sur l'alignement facial avec le réseau d'alignement profond (DAN). L'emplacement des repères faciaux est directement lié à l'émotion exprimée, nous étions donc curieux de savoir si nous pouvions construire un système qui combinerait ces deux tâches. »

ÉmotionnelDAN, le modèle imaginé par Tautkute et Trzcinski, est une adaptation du modèle DAN de Kowalski, qui comprend un terme lié aux traits du visage. Grâce à cette modification, leur modèle apprend simultanément l'emplacement des deux repères faciaux et l'émotion exprimée.

Crédit :Tautkutè &Trzcinski

Crédit :Tautkutè &Trzcinski

Crédit :Tautkutè &Trzcinski

Crédit :Tautkutè &Trzcinski

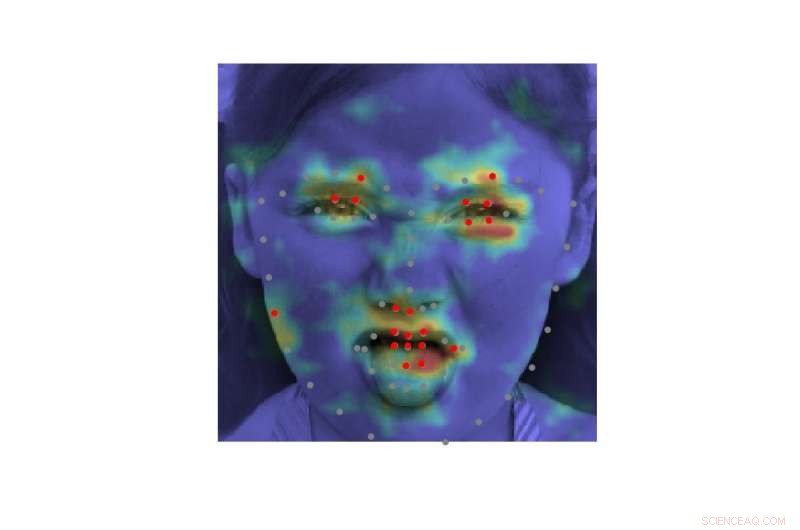

"Nous y sommes parvenus en étendant la fonction de perte du DAN d'origine par un terme responsable de la classification des émotions, " a déclaré Tautkute. " Le réseau de neurones est formé en étapes consécutives qui permettent d'affiner les repères faciaux et les émotions apprises. Il y a aussi un transfert d'informations entre les étapes, qui garde une trace de l'entrée de visage normalisée, la carte des caractéristiques et la carte thermique des points de repère."

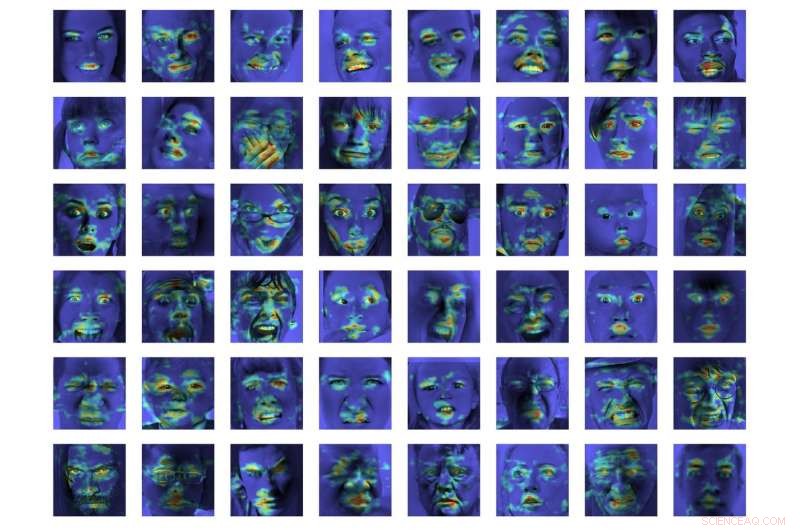

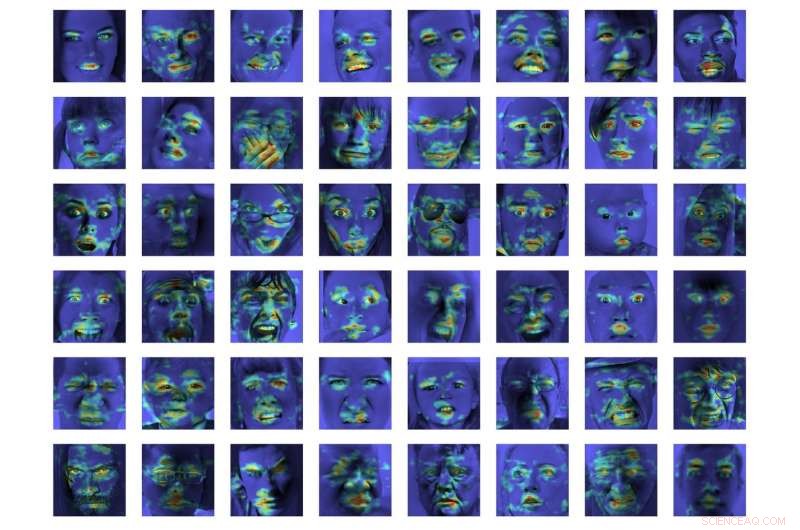

Dans une première évaluation, EmotionalDAN a surpassé les méthodes de classification de pointe de 5 % sur deux ensembles de données de référence, à savoir CK+ et ISDE. Les chercheurs ont également pu visualiser les régions d'images analysées par leur modèle lors de la prise de décision. Leurs observations ont révélé qu'EmotionalDAN pouvait identifier correctement les repères faciaux associés à l'expression des émotions chez les humains.

« Ce qui est vraiment intéressant dans notre étude, c'est que même si nous ne transmettons aucune information spatiale liée aux émotions au réseau, le modèle est capable d'apprendre par lui-même quelles régions du visage doivent être examinées en essayant de comprendre les expressions faciales, " a déclaré Tautkute. "Nous, les humains, regardons intuitivement les yeux et la bouche d'une personne pour remarquer des sourires ou de la tristesse, mais le réseau de neurones ne voit qu'une matrice de pixels. Vérifier quelles régions d'image sont activées pour une décision de classification donnée nous rapproche un peu plus de la compréhension du modèle et de la façon dont il prend des décisions."

Crédit :Tautkutè &Trzcinski.

Malgré les résultats très prometteurs obtenus par EmotionalDAN et d'autres outils de reconnaissance des émotions, comprendre les émotions humaines reste une tâche très complexe. Alors que les systèmes existants ont obtenu des résultats remarquables, ils ont surtout pu le faire lorsque les émotions sont exprimées à un degré significatif.

Dans des situations réelles, cependant, les signaux émotionnels exprimés par les humains sont souvent beaucoup plus subtils. Par exemple, le bonheur d'une personne peut ne pas toujours être exprimé en montrant toutes les dents dans un large sourire, mais pourrait simplement impliquer un léger mouvement des coins des lèvres.

"Il serait vraiment intéressant de comprendre des aspects plus subjectifs de l'émotion et comment leur expression diffère entre les individus, " dit Tautkute. " Pour aller plus loin, on pourrait essayer de distinguer les fausses émotions des vraies. Par exemple, les neurologues affirment que différents muscles faciaux sont impliqués dans les vrais et faux sourires. En particulier, les muscles oculaires ne se contractent pas dans l'expression forcée. Il serait intéressant de découvrir des relations similaires en utilisant les informations tirées des données. »

© 2018 Réseau Science X