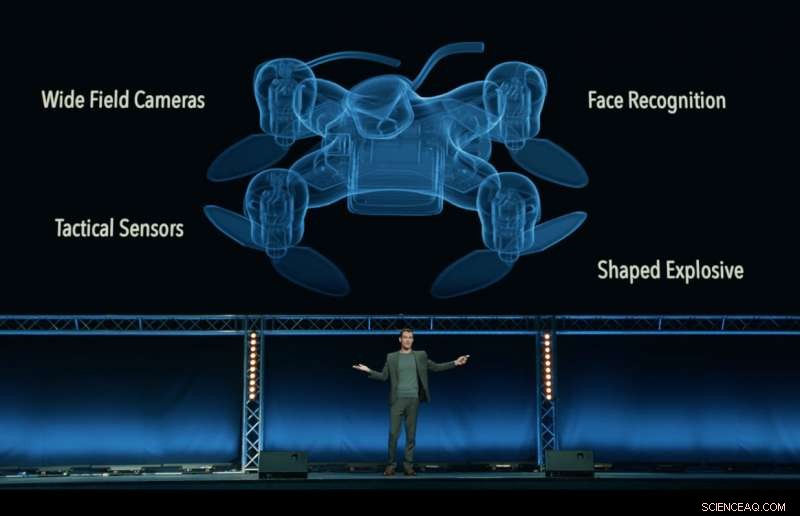

Toujours de la vidéo 'Slaughterbots', produit par le Future of Life Institute, qui montre un avenir dystopique fictif de drones tueurs envahissant le monde. Crédit:Future of Life Institute

Un who's who des PDG, ingénieurs et scientifiques de l'industrie technologique, y compris Google DeepMind, la Fondation XPRIZE et Elon Musk ont signé un engagement à « ne pas participer ni soutenir le développement, fabrication, Commerce, ou l'utilisation d'armes létales autonomes ».

Publié à Stockholm lors de la Conférence internationale conjointe sur l'intelligence artificielle 2018 (IJCAI), la plus grande réunion de recherche sur l'IA au monde avec plus de 5, 000 participants, le gage a été signé par 150 entreprises et plus de 2, 400 personnes de 90 pays travaillant dans l'intelligence artificielle (IA) et la robotique.

Les entreprises signataires incluent Google DeepMind, Collège universitaire de Londres, la Fondation XPRIZE, Moteurs ClearPath Robotics/OTTO, l'Association européenne pour l'IA, et la Société suédoise de l'IA. Les individus incluent le responsable de la recherche chez Google.ai Jeff Dean, Les pionniers de l'IA Stuart Russell, Yoshua Bengio, Anca Dragan et Toby Walsh, et le député travailliste britannique Alex Sobel.

L'engagement, organisé par le Future of Life Institute, défie les gouvernements, les universités et l'industrie à suivre leur exemple, en disant :« Nous, le soussigné, appeler les gouvernements et les chefs de gouvernement à créer un avenir avec des normes internationales fortes, réglementations et lois contre les armes autonomes létales. ... Nous demandons aux entreprises et organisations technologiques, ainsi que les dirigeants, créateurs de politiques, et d'autres individus, rejoignez-nous dans cet engagement."

Max Tegmark, professeur de physique au Massachusetts Institute of Technology et président du Future of Life Institute, a annoncé l'engagement.

"Je suis ravi de voir les leaders de l'IA passer de la parole à l'action, mettre en œuvre une politique que les politiciens n'ont pas encore mis en œuvre, " a déclaré Tegmark. " L'IA a un énorme potentiel pour aider le monde, si nous stigmatisons et prévenons ses abus. Les armes d'IA qui décident de manière autonome de tuer des gens sont aussi dégoûtantes et déstabilisantes que les armes biologiques, et doit être traité de la même manière.

Les systèmes d'armes létales autonomes (LAWS) - également surnommés "robots tueurs" - sont des armes qui peuvent identifier, cible, et tuer une personne, sans un humain "dans la boucle". C'est-à-dire, personne ne prend la décision finale d'autoriser la force meurtrière :la décision et l'autorisation de savoir si quelqu'un va mourir ou non est laissée au système d'armes autonome. Cela n'inclut pas les drones d'aujourd'hui, qui sont sous contrôle humain ; ni des systèmes autonomes qui se contentent de se défendre contre d'autres armes.

L'engagement commence par la déclaration :« L'intelligence artificielle est sur le point de jouer un rôle croissant dans les systèmes militaires. Il existe une opportunité et une nécessité urgentes pour les citoyens, créateurs de politiques, et les dirigeants à faire la distinction entre les utilisations acceptables et inacceptables de l'IA."

Un autre organisateur clé de l'engagement, Toby Walsh, professeur d'intelligence artificielle à l'Université australienne de Nouvelle-Galles du Sud à Sydney, souligne les questions éthiques épineuses entourant les LOIS :« Nous ne pouvons pas confier la décision de savoir qui vit et qui meurt à des machines. Ils n'ont pas l'éthique pour le faire. Je vous encourage, vous et vos organisations, à vous engager à faire en sorte que la guerre ne devenir plus terrible de cette façon.

Ryan Gariépy, Fondateur et CTO de Clearpath Robotics et d'OTTO Motors, un farouche opposant aux armes autonomes létales, a fait écho à l'appel :« Clearpath continue de croire que la prolifération des systèmes d'armes létales autonomes reste un danger clair et présent pour les citoyens de tous les pays du monde. Aucune nation ne sera en sécurité, peu importe la puissance.

« Les préoccupations de Clearpath sont partagées par une grande variété d'autres sociétés et développeurs clés de systèmes autonomes, et nous espérons que les gouvernements du monde entier décident d'investir leur temps et leurs efforts dans des systèmes autonomes qui améliorent la santé de leurs populations, plus sûr, et plus productifs que des systèmes dont le seul usage est le déploiement de la force meurtrière, " il ajouta.

Toby Walsh, professeur d'intelligence artificielle à l'Université australienne de Nouvelle-Galles du Sud à Sydney, avec un robot Baxter. Crédit : Grant Turner/UNSW

En plus des questions éthiques troublantes entourant les armes autonomes létales, de nombreux partisans d'une interdiction internationale des LOIS craignent qu'ils ne soient difficiles à contrôler - plus faciles à pirater, plus susceptibles de finir sur le marché noir, et plus facile à obtenir pour les terroristes et les despotes, ce qui pourrait devenir déstabilisant pour tous les pays. Un tel scénario est joué dans la vidéo Slaughterbots publiée par FLI.

En décembre 2016, la Conférence d'examen des Nations Unies de la Convention sur les armes classiques (CCW) a entamé une discussion formelle sur les LOIS. 26 pays participant à la Conférence ont jusqu'à présent annoncé leur soutien à un certain type d'interdiction, y compris la Chine.

Une telle interdiction n'est pas sans précédent :les armes biologiques et chimiques ont également été interdites, non seulement pour des raisons éthiques et humanitaires, mais aussi pour la menace déstabilisatrice qu'ils représentaient.

La prochaine réunion des Nations Unies sur les LOIS aura lieu en août 2018, et les signataires de l'engagement espèrent que leur engagement encouragera les législateurs à développer un engagement envers un accord international entre les pays.

Comme le dit l'engagement :« Nous, le soussigné, appeler les gouvernements et les chefs de gouvernement à créer un avenir avec des normes internationales fortes, réglementations et lois contre les armes autonomes létales. ... Nous demandons aux entreprises et organisations technologiques, ainsi que les dirigeants, créateurs de politiques, et d'autres individus, rejoignez-nous dans cet engagement."

Le texte intégral de l'engagement

L'intelligence artificielle (IA) est en passe de jouer un rôle croissant dans les systèmes militaires. Il y a une opportunité et une nécessité urgentes pour les citoyens, créateurs de politiques, et les dirigeants à faire la distinction entre les utilisations acceptables et inacceptables de l'IA.

Dans cette lumière, nous soussignés convenons que la décision de prendre une vie humaine ne devrait jamais être déléguée à une machine. Il y a une composante morale à cette position, que nous ne devrions pas permettre aux machines de prendre des décisions vitales pour lesquelles d'autres - ou personne - seront coupables.

Il y a aussi un argument pragmatique puissant :les armes autonomes létales, sélectionner et engager des cibles sans intervention humaine, serait dangereusement déstabilisante pour chaque pays et chaque individu. Des milliers de chercheurs en IA s'accordent à dire qu'en supprimant le risque, attribution, et la difficulté de prendre des vies humaines, les armes autonomes mortelles pourraient devenir de puissants instruments de violence et d'oppression, en particulier lorsqu'elles sont liées à des systèmes de surveillance et de données.

De plus, les armes autonomes létales ont des caractéristiques assez différentes du nucléaire, armes chimiques et biologiques, et les actions unilatérales d'un seul groupe pourraient trop facilement déclencher une course aux armements que la communauté internationale n'a pas les outils techniques et les systèmes de gouvernance mondiale pour gérer. La stigmatisation et la prévention d'une telle course aux armements devraient être une priorité élevée pour la sécurité nationale et mondiale.

Nous, le soussigné, appeler les gouvernements et les chefs de gouvernement à créer un avenir avec des normes internationales fortes, réglementations et lois contre les armes autonomes létales. Ceux-ci étant actuellement absents, nous choisissons de nous maintenir à un niveau élevé :nous ne participerons ni ne soutiendrons le développement, fabrication, Commerce, ou l'utilisation d'armes autonomes létales. Nous demandons aux entreprises et organisations technologiques, ainsi que les dirigeants, créateurs de politiques, et d'autres individus, rejoignez-nous dans cet engagement.