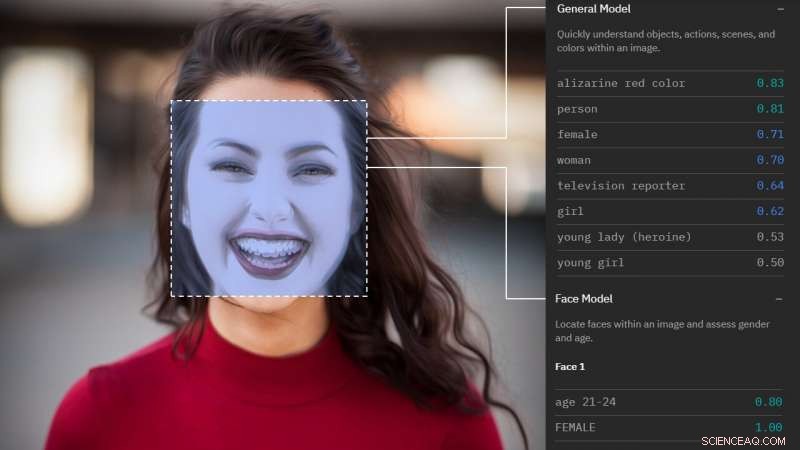

Comment l'analyse faciale vous voit. Crédit :Morgan Klaus Scheuerman/CU Boulder

Avec un bref regard sur un seul visage, les nouveaux logiciels de reconnaissance faciale peuvent désormais catégoriser le sexe de nombreux hommes et femmes avec une précision remarquable.

Mais si ce visage appartient à une personne transgenre, de tels systèmes se trompent plus d'un tiers du temps, selon une nouvelle étude de l'Université du Colorado à Boulder.

« Nous avons constaté que les services d'analyse faciale étaient systématiquement moins bons pour les personnes transgenres, et étaient universellement incapables de classer les genres non binaires, " a déclaré l'auteur principal Morgan Klaus Scheuerman, un doctorat étudiant au département des sciences de l'information. « Bien qu'il existe de nombreux types de personnes différentes, ces systèmes ont une vision extrêmement limitée de ce à quoi ressemble le genre. »

L'étude intervient à un moment où les technologies d'analyse faciale - qui utilisent des caméras cachées pour évaluer et caractériser certaines caractéristiques d'un individu - deviennent de plus en plus répandues, intégré dans tout, des applications de rencontres sur smartphone et des kiosques numériques dans les centres commerciaux aux systèmes de surveillance de la sécurité des aéroports et des forces de l'ordre.

Des recherches antérieures suggèrent qu'ils ont tendance à être plus précis lors de l'évaluation du sexe des hommes blancs, mais méconnaître les femmes de couleur jusqu'à un tiers du temps.

"Nous savions qu'il y avait des préjugés inhérents dans ces systèmes autour de la race et de l'ethnicité et nous soupçonnions qu'il y aurait également des problèmes autour du genre, " a déclaré l'auteur principal Jed Brubaker, professeur assistant en sciences de l'information. "Nous avons entrepris de tester cela dans le monde réel."

Les chercheurs ont collecté 2, 450 images de visages d'Instagram, dont chacun avait été étiqueté par son propriétaire avec un hashtag indiquant leur identité de genre. Les images ont ensuite été divisées en sept groupes de 350 images (#femmes, #homme, #femme trans, #transman, #genre, #genderqueer, #nonbinary) et analysé par quatre des plus grands fournisseurs de services d'analyse faciale (IBM, Amazone, Microsoft et Clarifai).

Notamment, Google n'a pas été inclus car il n'offre pas de services de reconnaissance du genre.

En moyenne, les systèmes étaient plus précis avec des photos de femmes cisgenres (celles nées de sexe féminin et s'identifiant comme étant de sexe féminin), obtenir leur sexe juste 98,3 % du temps. Ils ont catégorisé les hommes cisgenres avec précision 97,6% du temps.

Mais les hommes trans ont été identifiés à tort comme des femmes jusqu'à 38% du temps.

Et ceux qui se sont identifiés comme agenres, genderqueer ou non binaire - indiquant qu'ils ne s'identifient ni comme un homme ni comme une femme - ont été mal caractérisés 100 pour cent du temps.

"Ces systèmes ne connaissent pas d'autre langue que celle masculine ou féminine, donc pour de nombreuses identités de genre, il n'est pas possible qu'elles soient correctes, " dit Brubaker.

L'étude suggère également que ces services identifient le genre sur la base de stéréotypes dépassés.

Quand Scheuerman, qui est un homme et a les cheveux longs, a soumis sa propre photo, la moitié l'a classé comme femme.

Les chercheurs n'ont pas pu accéder aux données d'entraînement, ou des entrées d'image utilisées pour "apprendre" au système à quoi ressemblent les hommes et les femmes, mais des recherches antérieures suggèrent qu'ils évaluent des choses comme la position des yeux, plénitude des lèvres, la longueur des cheveux et même les vêtements.

« Ces systèmes risquent de renforcer les stéréotypes sur ce à quoi vous devez ressembler si vous voulez être reconnu comme un homme ou une femme. Et cela impacte tout le monde, " a déclaré Scheuermann.

Lorsque le chercheur Morgan Klaus Scheuerman, qui est un homme, soumis sa photo à plusieurs services d'analyse faciale, la moitié s'est trompée sur son sexe. Crédit :Morgan Klaus Scheuerman/CU Boulder

Le marché des services de reconnaissance faciale devrait doubler d'ici 2024, alors que les développeurs technologiques s'efforcent d'améliorer l'interaction homme-robot et ciblent plus soigneusement les publicités pour les acheteurs. Déjà, Brubaker note, les gens utilisent quotidiennement la technologie de reconnaissance faciale pour accéder à leurs smartphones ou se connecter à leurs ordinateurs.

S'il a tendance à tromper certains, déjà vulnérable, populations qui pourraient avoir de graves conséquences.

Par exemple, une application de mise en relation pourrait organiser un rendez-vous avec quelqu'un avec le mauvais sexe, conduisant à une situation potentiellement dangereuse. Ou une inadéquation entre le sexe qu'un programme de reconnaissance faciale voit et la documentation qu'une personne porte pourrait entraîner des problèmes pour passer la sécurité de l'aéroport, dit Scheuerman.

Il est très préoccupé par le fait que de tels systèmes réaffirment les notions selon lesquelles les personnes transgenres ne s'intègrent pas.

"Les gens pensent que la vision par ordinateur est futuriste, mais il y a beaucoup de gens qui pourraient être exclus de ce soi-disant futur, " il a dit.

Les auteurs disent qu'ils aimeraient voir les entreprises technologiques s'éloigner complètement de la classification par sexe et s'en tenir à des étiquettes plus spécifiques telles que "cheveux longs" ou "maquillage" lors de l'évaluation des images.

« Quand vous marchez dans la rue, vous pouvez regarder quelqu'un et présumer que vous connaissez son sexe, mais c'est une idée vraiment pittoresque des années 90 et ce n'est plus à quoi ressemble le monde, " a déclaré Brubaker. " Au fur et à mesure que notre vision et notre compréhension culturelle de ce qu'est le genre ont évolué. Les algorithmes qui régissent notre avenir technologique ne l'ont pas fait. C'est profondément problématique."

La recherche sera présentée en novembre à la conférence ACM sur le travail coopératif assisté par ordinateur à Austin, Texas.