Illustration d'agents jouant à Capturer le drapeau, montrant une gamme de comportements. Crédit :DeepMind

Depuis les premiers jours des échecs virtuels et du solitaire, les jeux vidéo ont été un terrain de jeu pour développer l'intelligence artificielle (IA). Chaque victoire de la machine contre l'humain a contribué à rendre les algorithmes plus intelligents et plus efficaces. Mais pour s'attaquer aux problèmes du monde réel, tels que l'automatisation de tâches complexes, notamment la conduite et la négociation, ces algorithmes doivent naviguer dans des environnements plus complexes que les jeux de société, et apprendre le travail d'équipe. Enseigner à l'IA comment travailler et interagir avec d'autres joueurs pour réussir était une tâche insurmontable, jusqu'à présent.

Dans une nouvelle étude, les chercheurs ont détaillé un moyen de former des algorithmes d'IA pour atteindre des niveaux de performance humains dans un jeu multijoueur 3D populaire, une version modifiée de Quake III Arena en mode Capture the Flag.

Même si la tâche de ce jeu est simple (deux équipes opposées s'affrontent pour capturer les drapeaux de l'autre en naviguant sur une carte), gagner exige une prise de décision complexe et une capacité à prédire et à réagir aux actions des autres joueurs.

C'est la première fois qu'une IA acquiert des compétences humaines dans un jeu vidéo à la première personne. Alors comment les chercheurs ont-ils fait ?

La courbe d'apprentissage du robot

En 2019, plusieurs jalons dans la recherche sur l'IA ont été atteints dans d'autres jeux de stratégie multijoueurs. Cinq "bots - des joueurs contrôlés par une IA - ont vaincu une équipe professionnelle d'e-sport dans une partie de DOTA 2. Des joueurs humains professionnels ont également été battus par une IA dans une partie de StarCraft II. Dans tous les cas, une forme d'apprentissage par renforcement a été appliquée, où l'algorithme apprend par essais et erreurs et en interagissant avec son environnement.

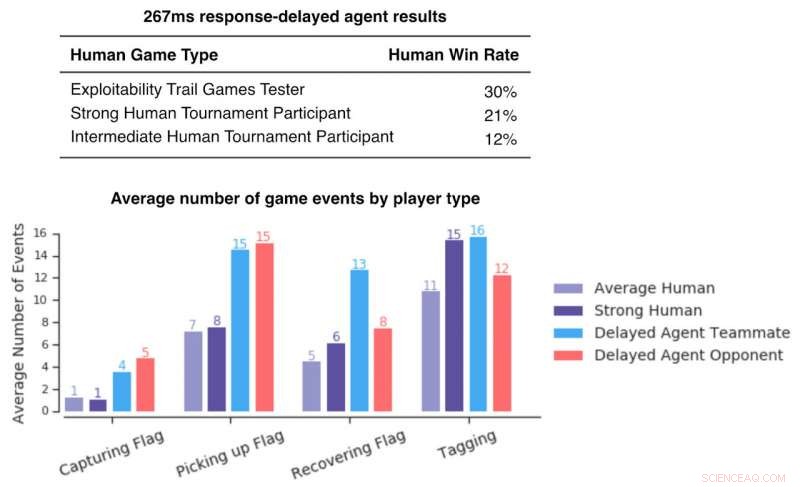

Figure illustrant les taux de victoire des joueurs humains par rapport aux agents en retard de réponse. Ceux-ci sont bas, indiquant que même avec des délais de réaction comparables à l'homme, les agents surpassent les joueurs humains. Crédit :DeepMind

Gif montrant les résultats les plus récents des agents jouant dans deux différentes cartes complètes de Quake III Arena avec différents modes de jeu. Crédit :DeepMind

Les cinq robots qui ont battu les humains à DOTA 2 n'ont pas appris des humains en jouant - ils ont été entraînés exclusivement en jouant des matchs contre des clones d'eux-mêmes. L'amélioration qui leur a permis de vaincre les joueurs professionnels est venue de la mise à l'échelle des algorithmes existants. En raison de la vitesse de l'ordinateur, l'IA pourrait jouer en quelques secondes à un jeu qui prend des minutes voire des heures aux humains. Cela a permis aux chercheurs de former leur IA avec 45, 000 ans de gameplay en dix mois de temps réel.

Le bot Capture the Flag de la récente étude a également commencé à apprendre à partir de zéro. Mais au lieu de jouer contre son clone identique, une cohorte de 30 bots a été créée et entraînée en parallèle de leur propre signal de récompense interne. Chaque bot au sein de cette population jouerait alors ensemble et apprendrait les uns des autres. Comme le fait remarquer David Silver, l'un des chercheurs scientifiques impliqués, L'IA commence à "supprimer les contraintes de la connaissance humaine… et à créer la connaissance elle-même".