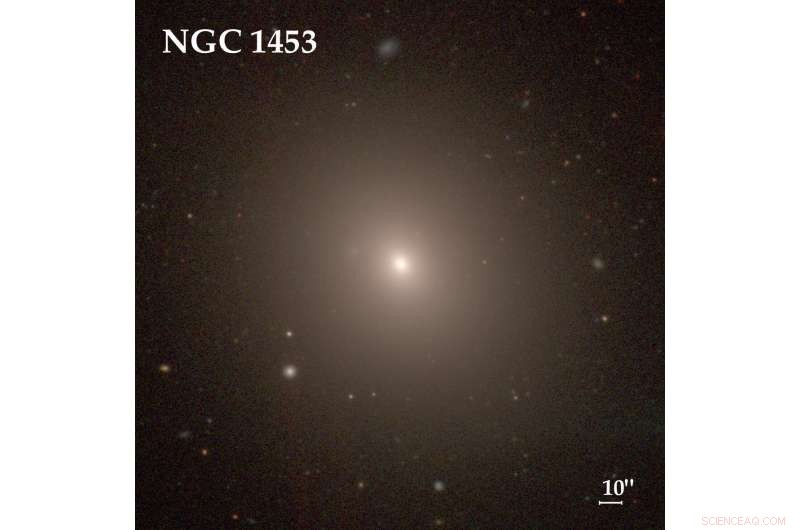

NGC 1453, une galaxie elliptique géante dans la constellation Eridanus, était l'une des 63 galaxies utilisées pour calculer le taux d'expansion de l'univers local. L'année dernière, l'équipe d'enquête MASSIVE a déterminé que la galaxie est située à 166 millions d'années-lumière de la Terre et a un trou noir en son centre avec une masse près de 3 milliards de fois celle du soleil. Crédit :le Carnegie-Irvine Galaxy Survey

Déterminer à quelle vitesse l'univers s'étend est essentiel pour comprendre notre destin cosmique, mais avec des données plus précises, une énigme est apparue :les estimations basées sur des mesures au sein de notre univers local ne concordent pas avec les extrapolations de l'ère peu après le Big Bang il y a 13,8 milliards d'années.

Une nouvelle estimation du taux d'expansion locale - la constante de Hubble, ou H0 (H-naught) - renforce cet écart.

En utilisant une technique relativement nouvelle et potentiellement plus précise pour mesurer les distances cosmiques, qui utilise la luminosité stellaire moyenne dans les galaxies elliptiques géantes comme un échelon sur l'échelle de distance, les astronomes calculent un taux de 73,3 kilomètres par seconde par mégaparsec, à plus ou moins 2,5 km/sec/Mpc—qui se situe au milieu de trois autres bonnes estimations, y compris l'estimation de l'étalon-or des supernovae de type Ia. Cela signifie que pour chaque mégaparsec (3,3 millions d'années-lumière), ou 3 milliards de milliards de kilomètres—de la Terre, l'univers s'étend de 73,3 ± 2,5 kilomètres supplémentaires par seconde. La moyenne des trois autres techniques est de 73,5 ± 1,4 km/sec/Mpc.

De façon perplexe, estimations du taux d'expansion locale basées sur les fluctuations mesurées du fond diffus cosmologique et, indépendamment, fluctuations de la densité de matière normale dans l'univers primitif (oscillations acoustiques baryoniques), donner une réponse très différente :67,4 ±0,5 km/sec/Mpc.

Les astronomes sont naturellement préoccupés par cette inadéquation, parce que le taux d'expansion est un paramètre critique pour comprendre la physique et l'évolution de l'univers et est essentiel pour comprendre l'énergie noire, qui accélère le taux d'expansion de l'univers et fait ainsi changer la constante de Hubble plus rapidement que prévu avec l'augmentation de la distance de Terre. L'énergie noire comprend environ les deux tiers de la masse et de l'énergie de l'univers, mais reste un mystère.

Pour la nouvelle estimation, les astronomes ont mesuré les fluctuations de la luminosité de surface de 63 galaxies elliptiques géantes pour déterminer la distance et tracé la distance en fonction de la vitesse pour chacune afin d'obtenir H0. La technique de fluctuation de la luminosité de la surface (SBF) est indépendante des autres techniques et a le potentiel de fournir des estimations de distance plus précises que d'autres méthodes à environ 100 Mpc de la Terre, soit 330 millions d'années-lumière. Les 63 galaxies de l'échantillon sont à des distances allant de 15 à 99 Mpc, en regardant dans le temps une simple fraction de l'âge de l'univers.

"Pour mesurer les distances aux galaxies jusqu'à 100 mégaparsecs, c'est une méthode fantastique, " a déclaré le cosmologiste Chung-Pei Ma, le professeur Judy Chandler Webb en sciences physiques à l'Université de Californie, Berkeley, et professeur d'astronomie et de physique. "C'est le premier papier qui rassemble un grand, ensemble homogène de données, sur 63 galaxies, dans le but d'étudier H-naught en utilisant la méthode SBF."

Ma dirige l'étude MASSIVE des galaxies locales, qui a fourni des données pour 43 des galaxies, soit les deux tiers de celles utilisées dans la nouvelle analyse.

Les données sur ces 63 galaxies ont été rassemblées et analysées par John Blakeslee, un astronome du NOIRLab de la National Science Foundation. Il est le premier auteur d'un article maintenant accepté pour publication dans Le Journal d'Astrophysique qu'il a co-écrit avec son collègue Joseph Jensen de l'Utah Valley University à Orem. Blakeslee, qui dirige le personnel scientifique qui soutient les observatoires optiques et infrarouges de la NSF, est un pionnier dans l'utilisation du SBF pour mesurer les distances aux galaxies, et Jensen a été l'un des premiers à appliquer la méthode aux longueurs d'onde infrarouges. Les deux ont travaillé en étroite collaboration avec Ma sur l'analyse.

« Toute l'histoire de l'astronomie est, en un sens, l'effort pour comprendre l'échelle absolue de l'univers, qui nous renseigne ensuite sur la physique, " Blakeslee a dit, en revenant au voyage de James Cook à Tahiti en 1769 pour mesurer un transit de Vénus afin que les scientifiques puissent calculer la vraie taille du système solaire. "La méthode SBF est plus largement applicable à la population générale de galaxies évoluées dans l'univers local, et certainement si nous obtenons suffisamment de galaxies avec le télescope spatial James Webb, cette méthode a le potentiel de donner la meilleure mesure locale de la constante de Hubble."

Le télescope spatial James Webb, 100 fois plus puissant que le télescope spatial Hubble, est prévu pour le lancement en octobre.

Galaxies elliptiques géantes

La constante de Hubble est une pomme de discorde depuis des décennies, depuis qu'Edwin Hubble a mesuré pour la première fois le taux d'expansion locale et a trouvé une réponse sept fois trop grande, ce qui implique que l'univers était en fait plus jeune que ses étoiles les plus anciennes. Le problème, alors et maintenant, consiste à localiser des objets dans l'espace qui donnent peu d'indices sur leur distance.

Au fil des ans, les astronomes ont gravi de plus grandes distances, commencer par calculer la distance aux objets suffisamment proches pour qu'ils semblent se déplacer légèrement, à cause de la parallaxe, comme la Terre tourne autour du soleil. Les étoiles variables appelées Céphéides vous emmènent plus loin, car leur luminosité est liée à leur période de variabilité, et les supernovae de type Ia vous emmènent encore plus loin, car ce sont des explosions extrêmement puissantes qui, à leur apogée, brille aussi fort que toute une galaxie. Pour les céphéides et les supernovae de type Ia, il est possible de déterminer la luminosité absolue à partir de leur évolution dans le temps, puis la distance peut être calculée à partir de leur luminosité apparente vue de la Terre.

La meilleure estimation actuelle de H0 provient des distances déterminées par les explosions de supernova de type Ia dans des galaxies lointaines, bien que les méthodes plus récentes - les retards causés par la lentille gravitationnelle des quasars distants et la luminosité des masers d'eau en orbite autour des trous noirs - donnent toutes à peu près le même nombre.

La technique utilisant les fluctuations de luminosité de surface est l'une des plus récentes et repose sur le fait que les galaxies elliptiques géantes sont anciennes et ont une population cohérente d'étoiles anciennes - principalement des étoiles géantes rouges - qui peuvent être modélisées pour donner une luminosité infrarouge moyenne sur toute leur surface. Les chercheurs ont obtenu des images infrarouges à haute résolution de chaque galaxie avec la caméra à grand champ 3 du télescope spatial Hubble et ont déterminé à quel point chaque pixel de l'image différait de la "moyenne" - plus les fluctuations étaient fluides sur l'ensemble de l'image, plus la galaxie est éloignée, une fois les corrections apportées aux imperfections telles que les régions brillantes de formation d'étoiles, que les auteurs excluent de l'analyse.

Ni Blakeslee ni Ma n'ont été surpris que le taux d'expansion soit proche de celui des autres mesures locales. Mais ils sont également confondus par le conflit flagrant avec les estimations de l'univers primitif - un conflit qui, selon de nombreux astronomes, signifie que nos théories cosmologiques actuelles sont fausses, ou du moins incomplète.

Les extrapolations de l'univers primitif sont basées sur la théorie cosmologique la plus simple, appelée matière noire froide lambda, ou ΛCDM—qui n'utilise que quelques paramètres pour décrire l'évolution de l'univers. La nouvelle estimation enfonce-t-elle un enjeu au cœur de ΛCDM ?

"Je pense que cela pousse cet enjeu un peu plus, " Blakeslee a déclaré. "Mais il (ΛCDM) est toujours en vie. Certaines personnes pensent, concernant toutes ces mesures locales, (que) les observateurs se trompent. Mais il devient de plus en plus difficile de faire cette affirmation - il faudrait qu'il y ait des erreurs systématiques dans le même sens pour plusieurs méthodes différentes :supernovae, SBF, lentille gravitationnelle, maîtres de l'eau. Donc, à mesure que nous obtenons des mesures plus indépendantes, cet enjeu va un peu plus loin."

Ma se demande si les incertitudes que les astronomes attribuent à leurs mesures, qui reflètent à la fois des erreurs systématiques et des erreurs statistiques, sont trop optimistes, et que peut-être les deux fourchettes d'estimations peuvent encore être conciliées.

"Le jury est sorti, " dit-elle. " Je pense que c'est vraiment dans les barres d'erreur. Mais en supposant que les barres d'erreur de chacun ne soient pas sous-estimées, la tension devient inconfortable."

En réalité, l'un des géants du domaine, l'astronome Wendy Freedman, a récemment publié une étude fixant la constante de Hubble à 69,8 ± 1,9 km/sec/Mpc, remuer les eaux encore plus loin. Le dernier résultat d'Adam Riess, un astronome qui a partagé le prix Nobel de physique 2011 pour la découverte de l'énergie noire, rapporte 73,2 ± 1,3 km/sec/Mpc. Riess était boursier postdoctoral Miller à l'UC Berkeley lorsqu'il a effectué cette recherche, et il a partagé le prix avec l'UC Berkeley et le physicien du Berkeley Lab, Saul Perlmutter.

Galaxies MASSIVES

La nouvelle valeur de H0 est un sous-produit de deux autres relevés de galaxies proches, en particulier, L'enquête MASSIVE de Ma, qui utilise des télescopes spatiaux et terrestres pour étudier de manière exhaustive les 100 galaxies les plus massives à environ 100 Mpc de la Terre. Un objectif majeur est de peser les trous noirs supermassifs au centre de chacun.

Pour faire ça, des distances précises sont nécessaires, et la méthode SBF est la meilleure à ce jour, elle a dit. L'équipe d'enquête MASSIVE a utilisé cette méthode l'année dernière pour déterminer la distance à une galaxie elliptique géante, NGC 1453, dans la constellation du ciel austral d'Eridan. En combinant cette distance, 166 millions d'années-lumière, avec de nombreuses données spectroscopiques des télescopes Gemini et McDonald - qui ont permis aux étudiants diplômés de Ma Chris Liepold et Matthew Quenneville de mesurer les vitesses des étoiles près du centre de la galaxie - ils ont conclu que NGC 1453 a un trou noir central avec une masse de près de 3 milliards de fois celle du soleil.

Pour déterminer H0, Blakeslee a calculé les distances SBF à 43 des galaxies dans l'enquête MASSIVE, sur la base de 45 à 90 minutes de temps d'observation HST pour chaque galaxie. Les 20 autres provenaient d'une autre enquête qui a utilisé le HST pour imager de grandes galaxies, spécifiquement celles dans lesquelles des supernovae de type Ia ont été détectées.

La plupart des 63 galaxies ont entre 8 et 12 milliards d'années, ce qui signifie qu'ils contiennent une grande population de vieilles étoiles rouges, qui sont la clé de la méthode SBF et peuvent également être utilisées pour améliorer la précision des calculs de distance. Dans le journal, Blakeslee a utilisé à la fois des étoiles variables céphéides et une technique qui utilise les étoiles géantes rouges les plus brillantes d'une galaxie, appelées pointe de la branche de la géante rouge, ou technique TRGB - pour atteindre les galaxies à grande distance. Ils ont produit des résultats cohérents. La technique TRGB tient compte du fait que les géantes rouges les plus brillantes des galaxies ont à peu près la même luminosité absolue.

"L'objectif est de rendre cette méthode SBF complètement indépendante de la méthode de supernova de type Ia calibrée par les Céphéides en utilisant le télescope spatial James Webb pour obtenir un étalonnage de branche géante rouge pour les SBF, " il a dit.

"Le télescope James Webb a le potentiel de vraiment diminuer les barres d'erreur pour SBF, " ajouta Maman. Mais pour l'instant, les deux mesures discordantes de la constante de Hubble devront apprendre à cohabiter.

« Je n'avais pas l'intention de mesurer H0 ; c'était un excellent produit de notre enquête, " dit-elle. " Mais je suis cosmologiste et je regarde cela avec beaucoup d'intérêt. "