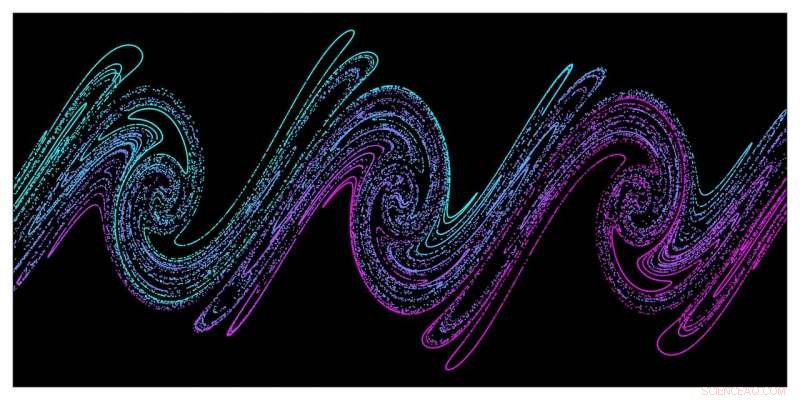

Des simulations à grande échelle démontrent que le chaos est responsable du chauffage stochastique du plasma dense par une énergie laser intense. Cette image montre un instantané de l'espace de phase de distribution des électrons (position/impulsion) du plasma dense tiré des simulations PIC, illustrant le mécanisme dit "d'étirement et de pliage" responsable de l'émergence du chaos dans les systèmes physiques. Crédit :G. Blaclard, CEA Saclay

Un nouvel outil de simulation 3D de particules dans la cellule (PIC) développé par des chercheurs du Lawrence Berkeley National Laboratory et du CEA Saclay permet des simulations de pointe des mécanismes de couplage laser/plasma qui étaient auparavant hors de portée des codes PIC standard utilisés dans recherche sur le plasma. Une compréhension plus détaillée de ces mécanismes est essentielle au développement d'accélérateurs de particules ultra-compacts et de sources lumineuses qui pourraient résoudre des défis de longue date en médecine, industrie, et la science fondamentale de manière plus efficace et rentable.

Dans des expériences laser-plasma comme celles du Berkeley Lab Laser Accelerator (BELLA) Center et du CEA Saclay, un centre de recherche international en France qui fait partie du Commissariat à l'énergie atomique, de très grands champs électriques dans les plasmas qui accélèrent les faisceaux de particules pour hautes énergies sur des distances beaucoup plus courtes par rapport aux technologies d'accélérateur existantes. L'objectif à long terme de ces accélérateurs laser-plasma (APL) est de construire un jour des collisionneurs pour la recherche à haute énergie, mais de nombreuses retombées sont déjà en cours de développement. Par exemple, Les LPA peuvent rapidement déposer de grandes quantités d'énergie dans des matériaux solides, créant des plasmas denses et soumettant cette matière à des températures et pressions extrêmes. Ils ont également le potentiel de piloter des lasers à électrons libres qui génèrent des impulsions lumineuses d'une durée de quelques attosecondes seulement. Ces impulsions extrêmement courtes pourraient permettre aux chercheurs d'observer les interactions de molécules, atomes, et même des particules subatomiques sur des échelles de temps extrêmement courtes.

Les simulations de superordinateurs sont devenues de plus en plus essentielles à cette recherche, et le Centre national de calcul scientifique de la recherche énergétique de Berkeley Lab (NERSC) est devenu une ressource importante dans cet effort. En donnant aux chercheurs accès à des observables physiques tels que les orbites de particules et les champs rayonnés qui sont difficiles à obtenir dans les expériences à des échelles de temps et de longueur extrêmement petites, Les simulations PIC ont joué un rôle majeur dans la compréhension, la modélisation, et guider les expériences de physique à haute intensité. Mais le manque de codes PIC suffisamment précis pour modéliser l'interaction laser-matière à des intensités ultra-élevées a entravé le développement de nouvelles sources de particules et de lumière produites par cette interaction.

Ce challenge a conduit l'équipe Berkeley Lab/CEA Saclay à développer leur nouvel outil de simulation, surnommé Warp+PXR, un effort a commencé au cours du premier cycle du NERSC Exascale Science Applications Program (NESAP). Le code combine le code PIC 3D largement utilisé Warp avec la bibliothèque haute performance PICSAR co-développée par Berkeley Lab et le CEA Saclay. Il exploite également un nouveau type de solveur pseudo-spectral massivement parallèle co-développé par Berkeley Lab et le CEA Saclay qui améliore considérablement la précision des simulations par rapport aux solveurs généralement utilisés dans la recherche sur les plasmas.

En réalité, sans ce nouveau, solveur hautement évolutif, "les simulations que nous faisons actuellement ne seraient pas possibles, " a déclaré Jean-Luc Vay, un physicien senior au Berkeley Lab qui dirige le programme de modélisation des accélérateurs dans la division Physique appliquée et technologies des accélérateurs du laboratoire. "Comme notre équipe l'a montré dans une étude précédente, ce nouveau solveur spectral FFT permet une précision beaucoup plus élevée que ce qui peut être fait avec les solveurs de domaine temporel aux différences finies (FDTD), nous avons donc pu atteindre certains espaces de paramètres qui n'auraient pas été accessibles avec les solveurs FDTD standard. le nouveau code Warp-X dans le cadre du projet Exascale Computing du département américain de l'Énergie.

Simulations 2D et 3D Critiques

Vay est également co-auteur d'un article publié le 21 mars dans Examen physique X qui rend compte de la première étude complète des mécanismes de couplage laser-plasma utilisant Warp+PXR. Cette étude combinait des mesures expérimentales de pointe menées sur l'installation laser UHI100 du CEA Saclay avec des simulations 2D et 3D de pointe exécutées sur le supercalculateur Cori du NERSC et les systèmes Mira et Theta de l'Argonne Leadership. Installation de calcul au Laboratoire national d'Argonne. Ces simulations ont permis à l'équipe de mieux comprendre les mécanismes de couplage entre la lumière laser ultra-intense et le plasma dense qu'elle a créé, fournir de nouvelles informations sur la façon d'optimiser les sources de particules et de lumière ultra-compactes. Les benchmarks avec Warp+PXR ont montré que le code est évolutif jusqu'à 400, 000 cœurs sur Cori et 800, 000 cœurs sur Mira et peut accélérer le temps de résolution jusqu'à trois ordres de grandeur sur les problèmes liés aux expériences de physique à ultra-haute intensité.

« Nous ne pouvons pas répéter ou reproduire systématiquement ce qui s'est passé dans l'expérience avec des simulations 2D. Nous avons besoin de 3D pour cela, " a déclaré le co-auteur Henri Vincenti, scientifique dans l'équipe de physique des hautes intensités du CEA Saclay. Vincenti a dirigé le travail théorique/simulation de la nouvelle étude et a été boursier postdoctoral Marie Curie au Berkeley Lab dans le groupe de Vay, où il a commencé à travailler sur le nouveau code et le solveur. "Les simulations 3D étaient également très importantes pour pouvoir comparer la précision apportée par le nouveau code aux expériences."

Pour l'expérience décrite dans le Examen physique X papier, les chercheurs du CEA Saclay ont utilisé un faisceau laser femtoseconde de forte puissance (100TW) de l'installation UHI100 du CEA focalisé sur une cible de silice pour créer un plasma dense. En outre, deux diagnostics, un écran scintillant Lanex et un spectromètre ultraviolet extrême, ont été appliqués pour étudier l'interaction laser-plasma au cours de l'expérience. Les outils de diagnostic ont présenté des défis supplémentaires lorsqu'il s'agissait d'étudier les échelles de temps et de longueur pendant le déroulement de l'expérience, rendant à nouveau les simulations essentielles aux conclusions des chercheurs.

"Souvent, dans ce genre d'expérience, vous ne pouvez pas accéder aux échelles de temps et de longueur impliquées, surtout parce que dans les expériences vous avez un champ laser très intense sur votre cible, donc vous ne pouvez pas mettre de diagnostic près de la cible, " a déclaré Fabien Quéré, chercheur qui dirige le programme expérimental au CEA et est co-auteur de l'article PRX. "Dans ce genre d'expérience, nous examinons les choses émises par la cible qui est éloignée - 10, 20 cm—et en temps réel, essentiellement, tandis que la physique est à l'échelle du micron ou submicronique et à l'échelle subfemtoseconde dans le temps. Nous avons donc besoin des simulations pour déchiffrer ce qui se passe dans l'expérience."

"Les simulations de principes premiers que nous avons utilisées pour cette recherche nous ont donné accès à la dynamique complexe de l'interaction du champ laser, avec la cible solide au niveau de détail des orbites des particules individuelles, nous permettant de mieux comprendre ce qui se passait dans l'expérience, " ajouta Vincenti.

Ces très grandes simulations avec un solveur FFT spectral de très haute précision ont été possibles grâce à un changement de paradigme introduit en 2013 par Vay et ses collaborateurs. Dans une étude publiée dans le Journal of Computational Physics, ils ont observé que, lors de la résolution des équations de Maxwell dépendantes du temps, la méthode standard de parallélisation FFT (qui est globale et nécessite des communications entre processeurs sur l'ensemble du domaine de simulation) pourrait être remplacée par une décomposition de domaine avec des FFT locales et des communications limitées aux processeurs voisins. En plus de permettre une mise à l'échelle forte et faible beaucoup plus favorable sur un grand nombre de nœuds informatiques, la nouvelle méthode est également plus économe en énergie car elle réduit les communications.

« Avec les algorithmes FFT standard, vous devez effectuer des communications sur l'ensemble de la machine, " a déclaré Vay. " Mais le nouveau solveur FFT spectral permet d'économiser à la fois du temps et de l'énergie de l'ordinateur, ce qui est un gros problème pour les nouvelles architectures de supercalcul en cours d'introduction."